基于deepseek的LORA微调

LORA微调:

核心是:低秩转换,减少参数。冻结大部分,调节部分模块(注意力模块的Wq,Wk,Wv)。

调整过后得到一个lora.safetensors, 内部记录了(detail W: 即部分修改的W)。推理使用原权重和lora权重。

具体操作:

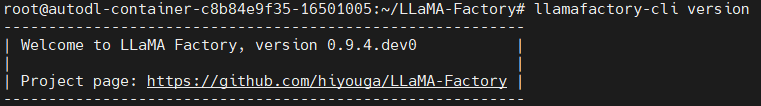

1,先进行工具,与库的下载

source /etc/network_turbo #先设置镜像 git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git # 下载工具库代码 cd LLaMA-Factory # 进入文件夹 pip install -e ".[torch,metrics]" # 下载环境 llamafactory-cli version #查看版本安装成功会有对应的版本

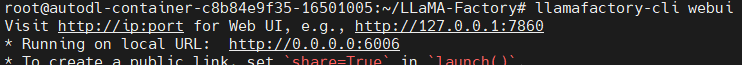

2,LLaMA-Factory运行网页管理页面

export GRADIO_SERVER_PORT=6006 # 设置临时端口 echo $GRADIO_SERVER_PORT # 查看是否设置成功 llamafactory-cli webui # 设置成功可以开启webui网页

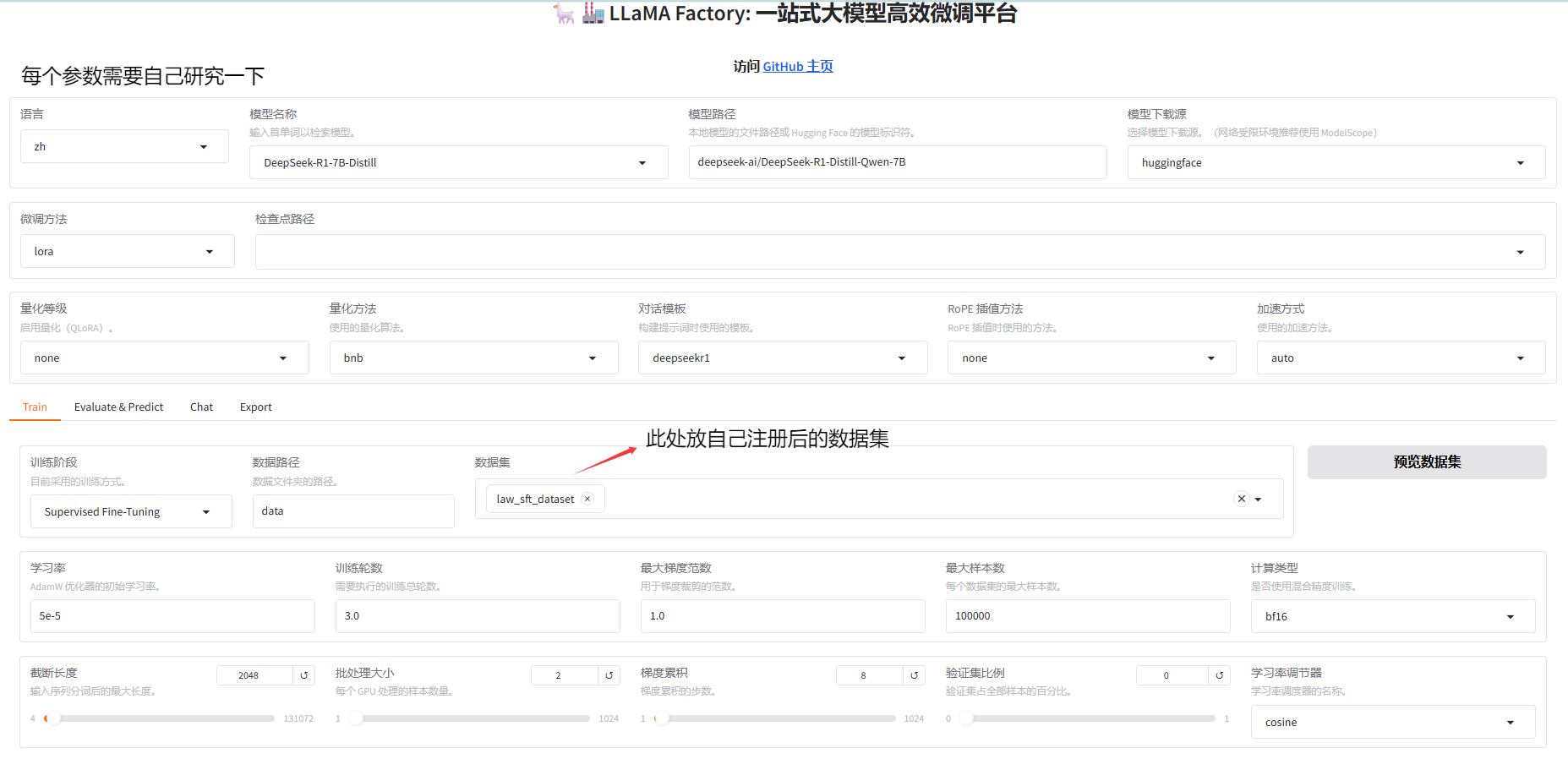

成功的话是这个页面

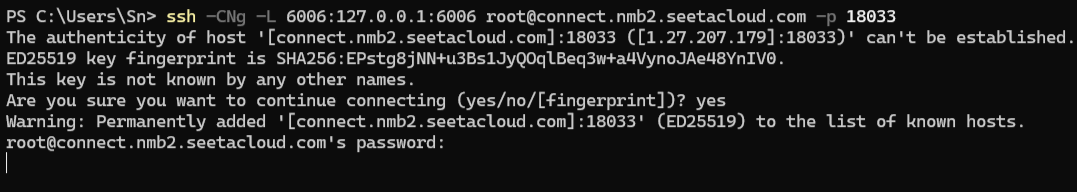

3,用电脑ssh连接算力云端口

4,进入微调页面

浏览器打开:http://localhost:6006/

5,数据处理与传输.

将你要微调的提示词文件放入/root/LLaMA-Factory/data/目录下。

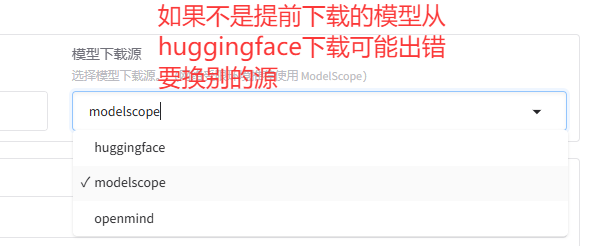

打开/root/LLaMA-Factory/data/dataset_info.json然后内部加上你的数据的josn格式

"law_sft_dataset": { "file_name": "law_sft_dataset_output.json" }, #等于是你要注册才能在网页上找到

6,调整参数开始训练.

注意点:

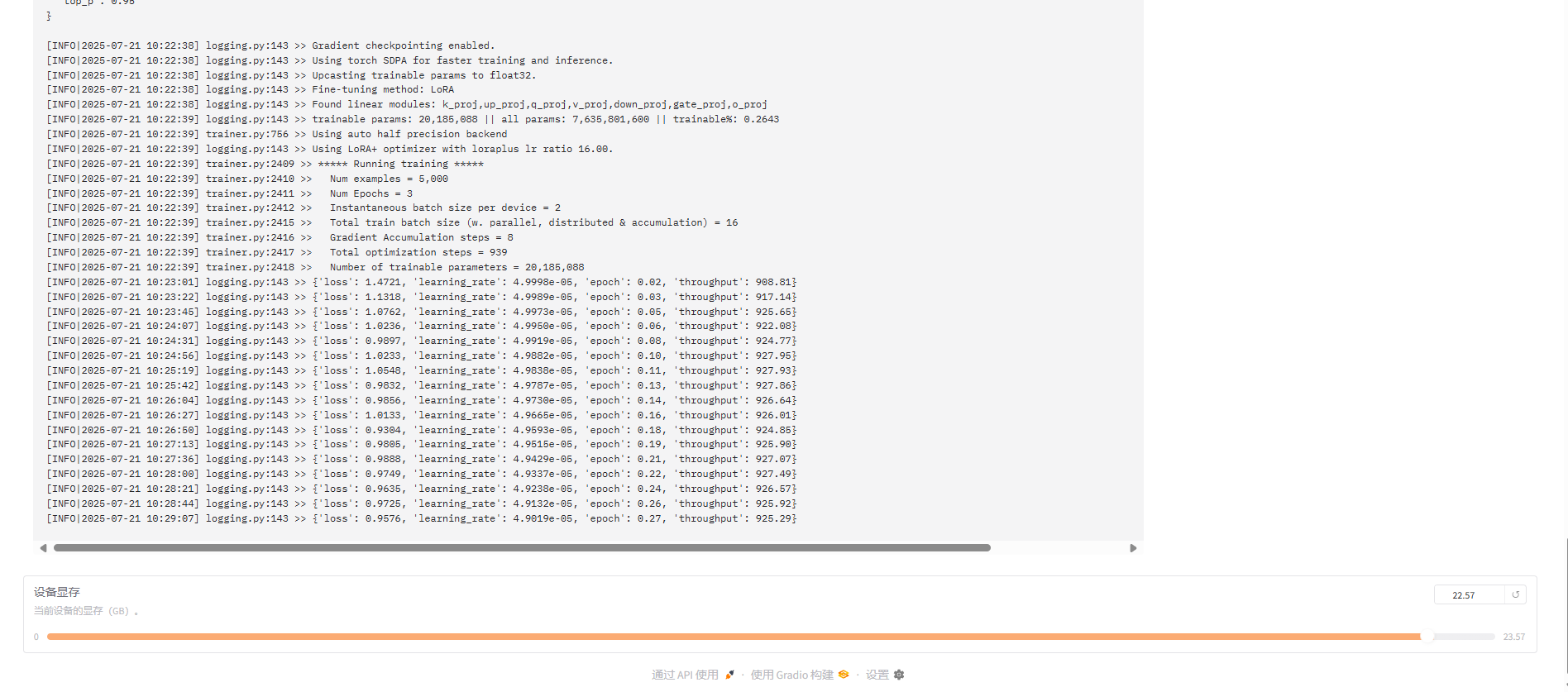

7,训练过程:

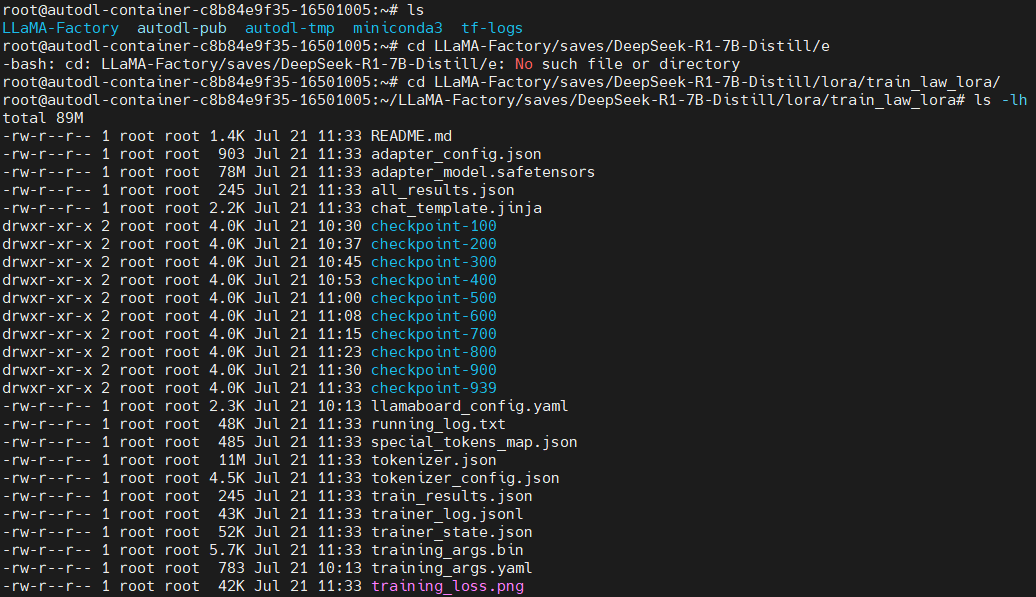

8,训练结果

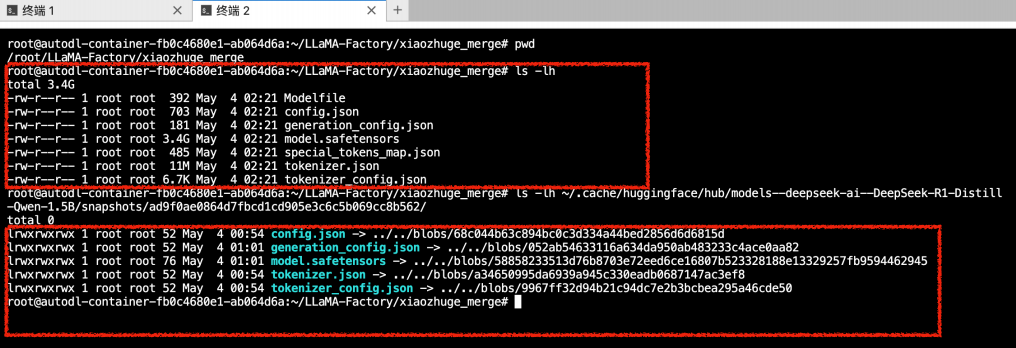

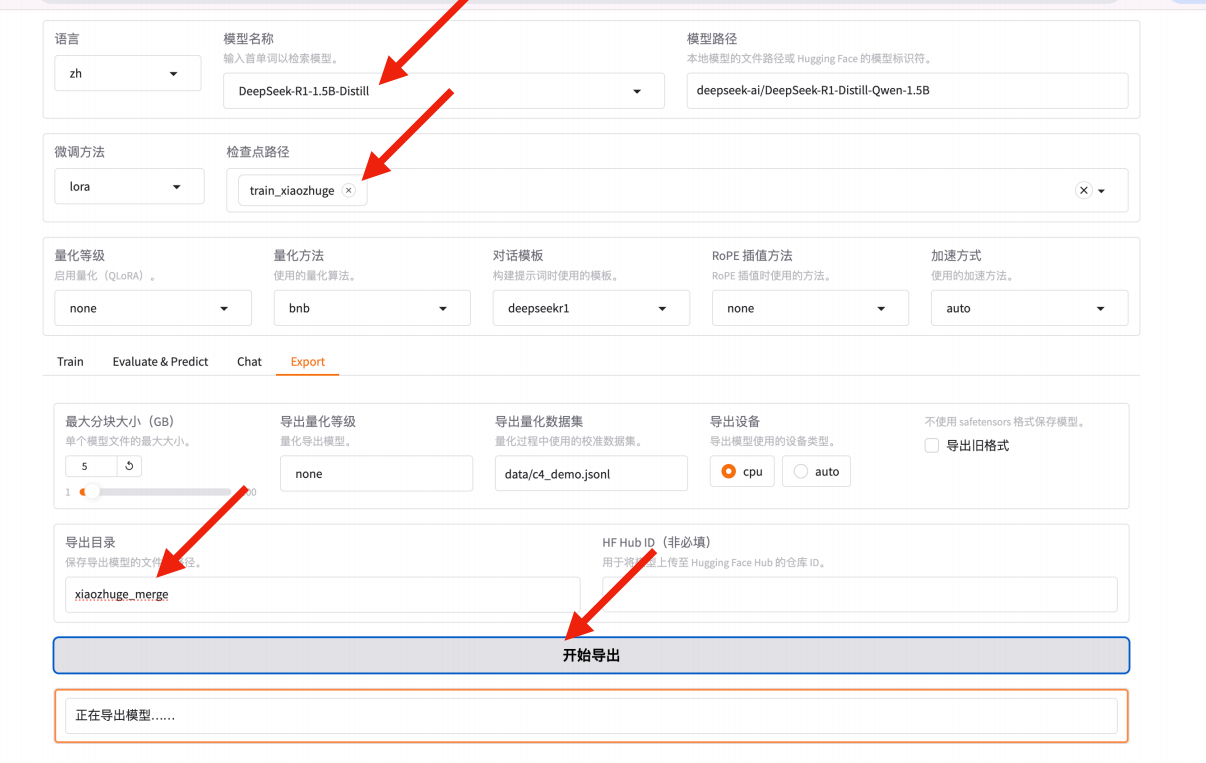

9,微调与原模型合并

最终就得到了进行特殊提示词微调后的模型了。