对LLM某一层进行优化:通过眼动数据发现中间层注重语句内在含义,进而对中间层参数优化

对LLM某一层进行优化:通过眼动数据发现中间层注重语句内在含义,进而对中间层参数优化

论文核心解析及核心原理举例

一、研究背景与动机

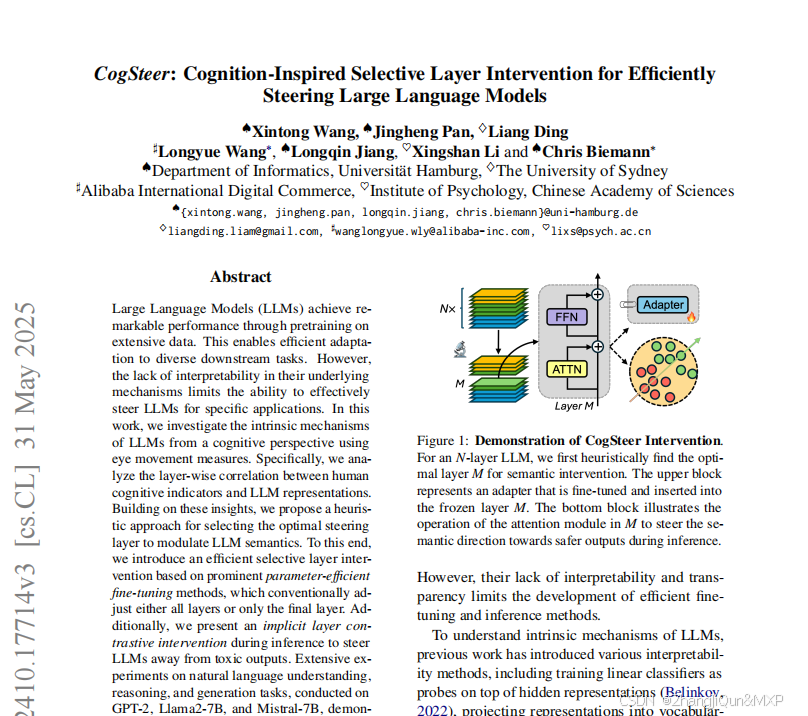

大语言模型(LLMs)通过大规模预训练在下游任务中表现优异,但内部机制的可解释性不足,导致难以高效引导其语义输出。传统参数高效微调(PEFT)方法通常干预所有层或仅最后一层,存在参数冗余和效率低下的问题。为此,论文提出CogSteer框架——一种基于认知启发的选择性层干预方法,通过分析LLM层功能特性,精准选择干预层以提升效率和性能。

二、核心原理:基于眼动数据的层功能解析与选择性干预

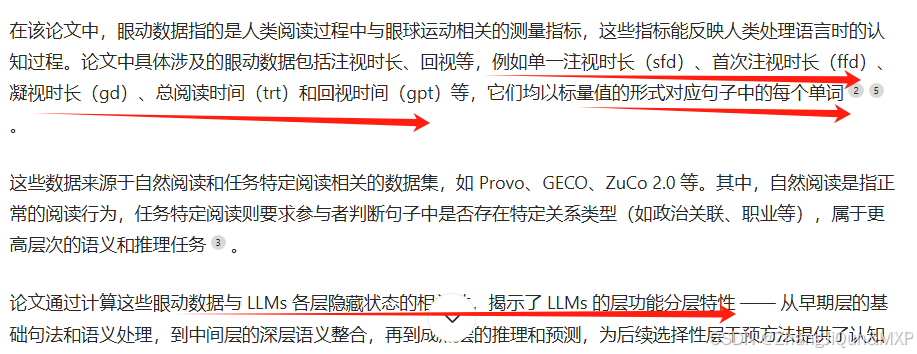

论文的核心逻辑是:通过人类认知指标(眼动数据)揭示LLM层功能分层规律,再基于此选择最优干预层,实现高效语义引导。