【ComfyUI】混合 ControlNet 多模型组合控制生成

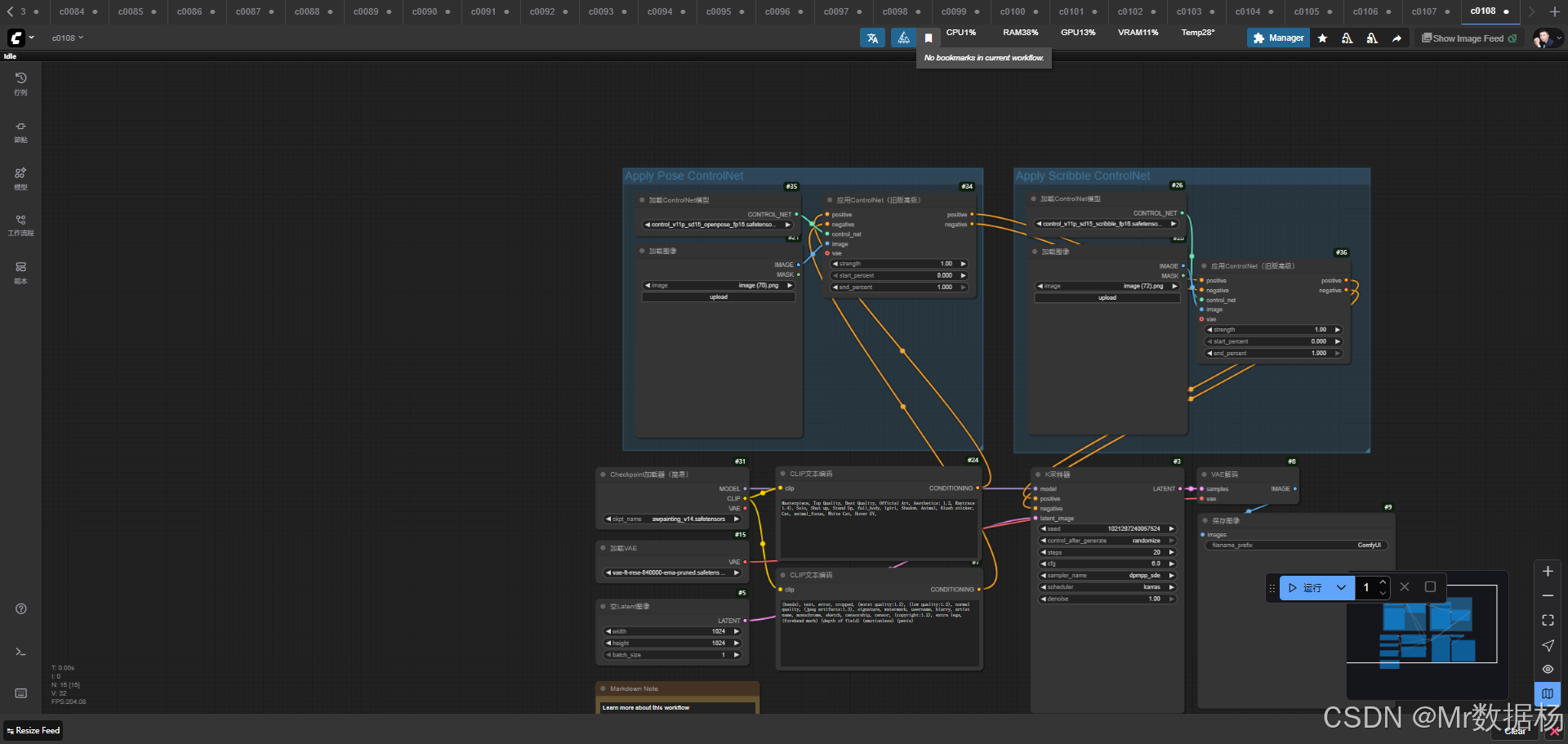

今天给大家演示一个结合 ControlNet 多模态约束 的 ComfyUI 工作流,通过同时加载姿态(OpenPose)与涂鸦(Scribble)两种 ControlNet 模型,配合 awpainting_v14 主模型与专用 VAE 解码器,实现从输入参考图到高质量成品图像的生成过程。在这个流程中,文本提示与负面提示经过 CLIP 编码后,与 ControlNet 的结构约束一起输入 KSampler 采样器,最终解码并保存为成品图像。整体效果直观展现了如何在创意生成中同时利用姿态控制与线稿约束,帮助生成既保持构图又能体现高质量细节的作品。

文章目录

- 工作流介绍

- 核心模型

- Node节点

- 工作流程

- 应用场景

- 开发与应用

工作流介绍

本工作流的核心逻辑在于通过 主模型 + ControlNet 双重控制 + 文本条件约束 来保证生成画面的稳定性与可控性。核心模型部分由 awpainting_v14.safetensors 作为生成基底,配合 vae-ft-mse-840000-ema-pruned.safetensors 进行图像解码,确保画面色彩与细节的还原。Node 节点设计方面,既包含了文本编码节点(CLIPTextEncode)、图像加载节点(LoadImage)、采样节点(KSampler)、以及最终的解码和保存节点(VAEDecode 与 SaveImage),也引入了 ControlNetLoader 与 ControlNetApplyAdvanced 节点来处理姿态与涂鸦输入,实现双重条件叠加的约束效果。整体流程清晰地串联了输入、条件控制、采样、解码与输出几个关键环节,让用户能够直观理解并灵活调整。

核心模型

核心模型采用 awpainting_v14 作为基础权重,结合高质量的 VAE 解码器来保障生成结果在色彩和清晰度上的表现,形成了一个兼具艺术风格与技术稳定性的模型组合。

| 模型名称 | 说明 |

|---|---|

| awpainting_v14.safetensors | 主模型,负责整体图像生成,偏向高质量绘画风格 |

| vae-ft-mse-840000-ema-pruned.safetensors | VAE 解码器,用于将潜空间图像转换为清晰成品图像 |

| control_v11p_sd15_openpose_fp16.safetensors | ControlNet 姿态约束模型,确保人物动作和结构准确 |

| control_v11p_sd15_scribble_fp16.safetensors | ControlNet 涂鸦约束模型,利用线稿信息控制画面构图 |

Node节点

节点设计上既体现了基础生成的完整链路,也引入了双重 ControlNet 约束的高级控制能力。文本编码节点处理正向与负向提示,ControlNet 节点负责将参考图信息注入,最终由采样器和解码器将潜变量转化为可见结果。

| 节点名称 | 说明 |

|---|---|

| CheckpointLoaderSimple | 加载主模型 awpainting_v14 |

| VAELoader | 加载 VAE 解码器,保证输出清晰度 |

| CLIPTextEncode | 编码正向与负向提示词,形成条件输入 |

| LoadImage | 加载参考图像作为 ControlNet 输入 |

| ControlNetLoader | 加载姿态与涂鸦两种 ControlNet 模型 |

| ControlNetApplyAdvanced | 应用 ControlNet 条件,融合文本与图像约束 |

| EmptyLatentImage | 生成初始潜变量作为采样输入 |

| KSampler | 基于模型、条件与潜变量进行采样生成 |

| VAEDecode | 将潜变量解码为最终图像 |

| SaveImage | 保存生成结果 |

工作流程

整个工作流程以加载模型与条件约束为起点,通过多重输入和节点衔接逐步完成生成。在起始阶段,CheckpointLoaderSimple 与 VAELoader 分别加载主模型和解码器,提供了基础的生成框架。随后,CLIPTextEncode 节点将正向与负向提示词转化为条件信息,与 LoadImage 节点导入的参考图像一并传递给 ControlNetLoader 与 ControlNetApplyAdvanced 节点。这里的关键在于双重 ControlNet 机制:姿态模型确保人物动作结构准确,涂鸦模型保证画面轮廓与构图稳定。两者的输出经过条件融合后,传入 KSampler 与 EmptyLatentImage 配合运行,在主模型潜空间中迭代采样生成。最终,VAEDecode 将潜变量转为高质量可见图像,并由 SaveImage 保存结果。整个流程形成了从模型加载、条件输入、双重约束到成品输出的闭环,既保证了画面可控性,也保留了创作自由度。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 模型与解码器加载 | 载入主模型与 VAE 解码器,建立生成框架 | CheckpointLoaderSimple、VAELoader |

| 2 | 提示词编码 | 将正向与负向提示词转化为条件输入 | CLIPTextEncode |

| 3 | 参考图导入 | 加载姿态图与涂鸦图作为结构约束 | LoadImage |

| 4 | ControlNet 加载与应用 | 加载姿态与涂鸦 ControlNet,并融合条件输入 | ControlNetLoader、ControlNetApplyAdvanced |

| 5 | 潜变量生成与采样 | 构建初始潜变量并在条件引导下迭代生成 | EmptyLatentImage、KSampler |

| 6 | 图像解码与输出 | 解码潜变量为高质量图像并保存 | VAEDecode、SaveImage |

应用场景

该工作流的应用场景主要集中在 角色绘制、结构约束创作、二次元插画生成以及快速草图转高质量成品 等方向。通过姿态控制与涂鸦约束的结合,用户既能确保画面结构合理,又能在提示词中定义风格与细节,兼顾灵活性与稳定性。对于需要将草图快速转化为精美插画的设计师,或希望严格遵循人物动作设定的动画制作人员来说,这一流程都极具实用价值。同时,它也能为个人创作爱好者提供从简单线稿到高质量画面的直观生成体验,效果不仅提升效率,更让创意落地过程更直观高效。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 二次元角色绘制 | 在风格化基础上保持姿态准确 | 插画师、二次元创作者 | 角色动作、造型设计 | 高质量角色图生成 |

| 草图转成品 | 将简单线稿或涂鸦转化为完整插画 | 设计师、爱好者 | 草图输入与细节提示 | 从粗略线条到完整成品 |

| 动画动作参考 | 在生成中确保动作与骨骼结构的准确 | 动画师、分镜设计师 | 动作参考图与提示词 | 保持动作一致性与稳定性 |

| 快速概念设计 | 辅助创意草案快速出图 | 游戏美术、视觉设计师 | 概念图与初步构思 | 高效生成具备参考价值的画面 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

ComfyUI使用教程、开发指导、资源下载

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用