个人电脑部署本地大模型+UI

在这个AI飞速进步的时代,越来越多的大模型出现在市面上

本地大模型也越来越火爆!

它完全免费,随时可以访问,数据仅存在本地,还可以自己微调,训练!

今天我来教大家,如何在一台普通的个人电脑上,部署属于自己的大模型!

01 硬件要求

操作系统: Windows 10+,macOS11+

内存: 4G以上,最好8G

cpu:4核心以上

gpu(独立显卡):完全不需要!

02安装框架环境

我们将使用目前最火的本地大模型运行环境ollama部署大模型

下载地址:Download Ollama on Windows

点开这个页面后下载合适自己系统的安装包.

按提示安装(一直下一步就行)

03选择本地大模型

打开以下链接,进入ollama的本地大模型库

Ollama

***如何选择合适的本地大模型***

模型名称后面的“b”代表大模型的参数量。

Windows电脑

内存4到8g:1.5-5b

内存8到16g7-14b

内存16g+:14-32b

有GPU32b+

MAC电脑

Intel芯片:7-16b

apple芯片:16-32b

找到合适的大模型后,点进它的详情页。

在左侧框里选择大模型的'B'值

再把右侧的代码复制下来。

几个好用的大模型推荐

1deepseek-r1

2gemma2

3llama3.3

04安装本地大模型

Windows电脑打开命令提示符(cmd)

macOS打开终端

粘贴运行刚才复制的代码

ollama会自动下载模型。

等待模型下载成功,中途不要变换网络!

等待下载成功,就可以聊天了。

以下是一些常用的ollama命令

1下载/打开大模型:ollama run 模型名

2查看已安装的大模型:ollama modems

3删除大模型:ollama rm 模型名

05安装UI

本地大模型只能在命令行中使用,很不方便

我们可以为它安装一个类似于open AI的聊天界面,使我们可以微调大模型,上传文件,进行多模型支持,以及保存回话内容。

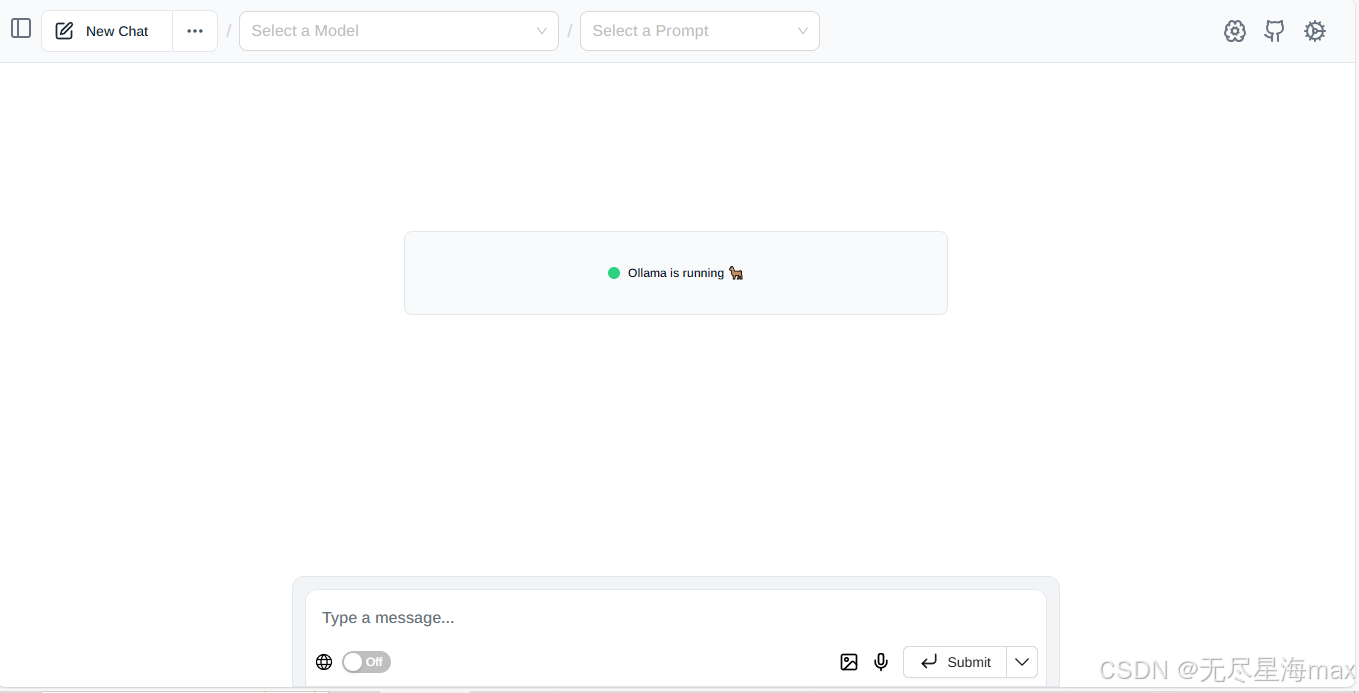

这里使用开源的Page AssistUI(适用于edge和Chrome)

访问:Page Assist - 本地 AI 模型的 Web UI | Chrome扩展 - Crx搜搜

若报安全问题,请选择保留。

安装成功后点击插件图标,进入聊天界面,开始使用!

这套方法成功率极高,如有问题,请留言!