瓦瑟斯坦差分隐私(Wasserstein DP)中的一个推导

公式68的推导基于最优传输理论和敏感度分析的结合,其核心是利用Wasserstein距离与数据敏感度之间的内在联系。以下分步骤详细解释:

1. 背景与符号定义

- 相邻数据集:设 D D D 和 D ′ D' D′ 是相邻数据集(例如相差一条记录)。

- 机制 M \mathcal{M} M:一个随机化算法,输出服从分布 Pr M ( D ) \Pr_{\mathcal{M}}(D) PrM(D) 和 Pr M ( D ′ ) \Pr_{\mathcal{M}}(D') PrM(D′)。

- 敏感度 Δ p f \Delta_p f Δpf:定义为在相邻数据集上函数 f f f 输出的最大 l p l_p lp 范数差:

Δ p f = sup D , D ′ ∥ f ( D ) − f ( D ′ ) ∥ p . \Delta_p f = \sup_{D, D'} \|f(D) - f(D')\|_p. Δpf=D,D′sup∥f(D)−f(D′)∥p. - Wasserstein距离 W μ W_\mu Wμ:如定义1,基于最优运输成本。

2. 公式67的作用

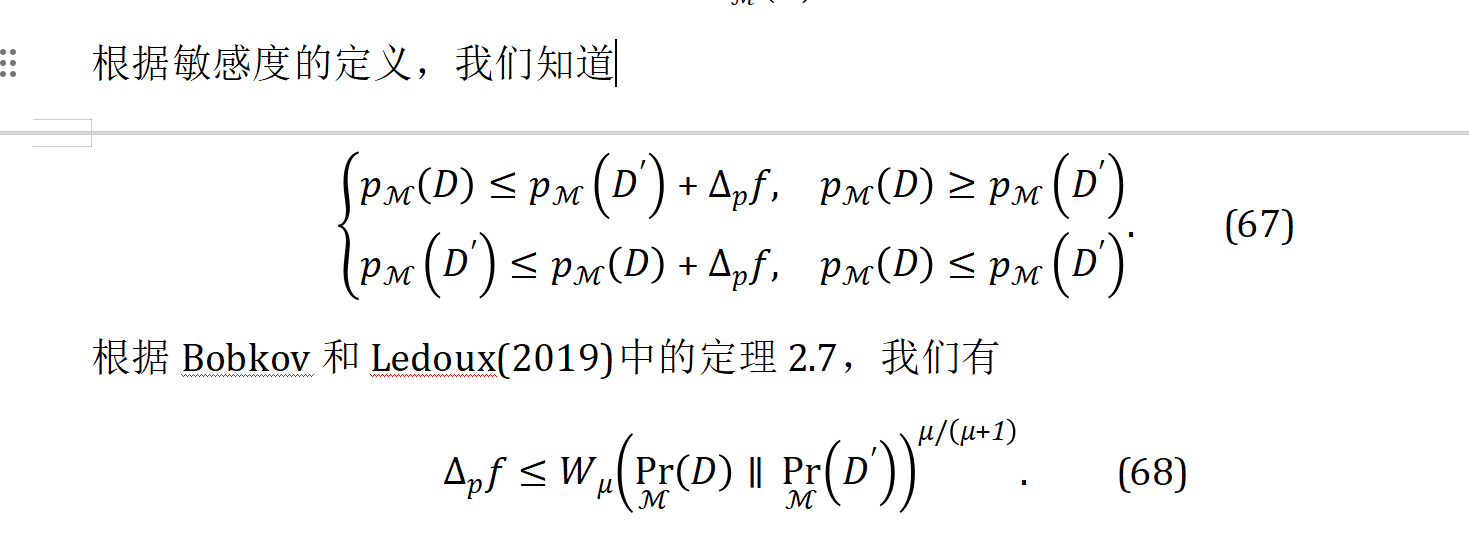

公式67给出了机制输出分布在相邻数据集上的敏感度约束:

{ p M ( D ) ≤ p M ( D ′ ) + Δ p f , 当 p M ( D ) ≥ p M ( D ′ ) , p M ( D ′ ) ≤ p M ( D ) + Δ p f , 当 p M ( D ) ≤ p M ( D ′ ) . \begin{cases} p_{\mathcal{M}}(D) \leq p_{\mathcal{M}}(D') + \Delta_p f, & \text{当 } p_{\mathcal{M}}(D) \geq p_{\mathcal{M}}(D'), \\ p_{\mathcal{M}}(D') \leq p_{\mathcal{M}}(D) + \Delta_p f, & \text{当 } p_{\mathcal{M}}(D) \leq p_{\mathcal{M}}(D'). \end{cases} {pM(D)≤pM(D′)+Δpf,pM(D′)≤pM(D)+Δpf,当 pM(D)≥pM(D′),当 pM(D)≤pM(D′).

这表明两个分布的差异被敏感度 Δ p f \Delta_p f Δpf 所限制,为后续推导提供了不等式条件。

3. 引用Bobkov-Ledoux定理2.7

Bobkov和Ledoux的定理指出,对于两个概率测度 P P P 和 Q Q Q,若存在一个函数 f f f 满足 Hölder连续条件,即:

∣ f ( x ) − f ( y ) ∣ ≤ L ⋅ ρ ( x , y ) α ( 0 < α ≤ 1 ) , |f(x) - f(y)| \leq L \cdot \rho(x, y)^\alpha \quad (0 < \alpha \leq 1), ∣f(x)−f(y)∣≤L⋅ρ(x,y)α(0<α≤1),

则其期望差异可被Wasserstein距离上界:

∣ E P [ f ] − E Q [ f ] ∣ ≤ L ⋅ W μ ( P , Q ) μ / ( μ + 1 ) , |\mathbb{E}_P[f] - \mathbb{E}_Q[f]| \leq L \cdot W_\mu(P, Q)^{\mu/(\mu + 1)}, ∣EP[f]−EQ[f]∣≤L⋅Wμ(P,Q)μ/(μ+1),

其中 μ \mu μ 与Hölder指数 α \alpha α 满足关系 α = μ / ( μ + 1 ) \alpha = \mu/(\mu + 1) α=μ/(μ+1)。

4. 推导公式68的关键步骤

(1) 将敏感度视为Hölder条件

公式67中的敏感度约束可重新表述为:

∥ f ( D ) − f ( D ′ ) ∥ p ≤ Δ p f . \|f(D) - f(D')\|_p \leq \Delta_p f. ∥f(D)−f(D′)∥p≤Δpf.

这等价于函数 f f f 在相邻数据集上满足 Lipschitz条件(即 α = 1 \alpha=1 α=1 的Hölder条件),但需注意此处敏感度的定义基于 l p l_p lp 范数。

(2) 链接到Wasserstein距离

根据Bobkov-Ledoux定理,若将机制输出分布 Pr M ( D ) \Pr_{\mathcal{M}}(D) PrM(D) 和 Pr M ( D ′ ) \Pr_{\mathcal{M}}(D') PrM(D′) 视为 P P P 和 Q Q Q,则:

Δ p f ≤ L ⋅ W μ ( P , Q ) μ / ( μ + 1 ) . \Delta_p f \leq L \cdot W_\mu(P, Q)^{\mu/(\mu + 1)}. Δpf≤L⋅Wμ(P,Q)μ/(μ+1).

其中:

- L = 1 L = 1 L=1(因敏感度已归一化),

- μ \mu μ 是Wasserstein距离的阶数,与 l p l_p lp 范数的选择相关。

(3) 参数匹配

- Hölder指数 α \alpha α:在定理中, α = μ / ( μ + 1 ) \alpha = \mu/(\mu + 1) α=μ/(μ+1)。

- Wasserstein阶数 μ \mu μ:通常与敏感度范数 l p l_p lp 对应。例如,若 p = 1 p=1 p=1,则 μ = 1 \mu=1 μ=1;若 p = 2 p=2 p=2,则 μ = 2 \mu=2 μ=2。

由此直接导出公式68:

Δ p f ≤ W μ ( Pr M ( D ) ∥ Pr M ( D ′ ) ) μ / ( μ + 1 ) . \Delta_p f \leq W_\mu\left( \Pr_{\mathcal{M}}(D) \parallel \Pr_{\mathcal{M}}(D') \right)^{\mu/(\mu + 1)}. Δpf≤Wμ(MPr(D)∥MPr(D′))μ/(μ+1).

5. 直观解释

- 敏感度与运输成本: Δ p f \Delta_p f Δpf 衡量数据变化对输出的最大影响,而 W μ W_\mu Wμ 衡量分布间的最小运输成本。

- 指数项的意义: μ / ( μ + 1 ) \mu/(\mu + 1) μ/(μ+1) 反映了运输成本随距离阶数的非线性衰减。当 μ → ∞ \mu \to \infty μ→∞ 时,指数趋近于1,敏感度与Wasserstein距离直接线性相关。

6. 应用场景

该不等式在差分隐私中有重要意义:

- 隐私预算分析:通过约束 W μ W_\mu Wμ 来控制敏感度 Δ p f \Delta_p f Δpf,进而设计满足 ( ϵ , δ ) (\epsilon, \delta) (ϵ,δ)-差分隐私的机制。

- 噪声尺度设计:例如,拉普拉斯机制中噪声参数 λ ∝ Δ p f / ϵ \lambda \propto \Delta_p f / \epsilon λ∝Δpf/ϵ,与此处的 W μ W_\mu Wμ 上界一致。

总结

公式68的推导本质是将敏感度的局部约束(相邻数据集差异)与分布的全局差异(Wasserstein距离)通过Hölder条件和对偶理论联系起来。这一结果为隐私保护算法提供了理论工具,将数据敏感性转化为可计算的分布距离上界。