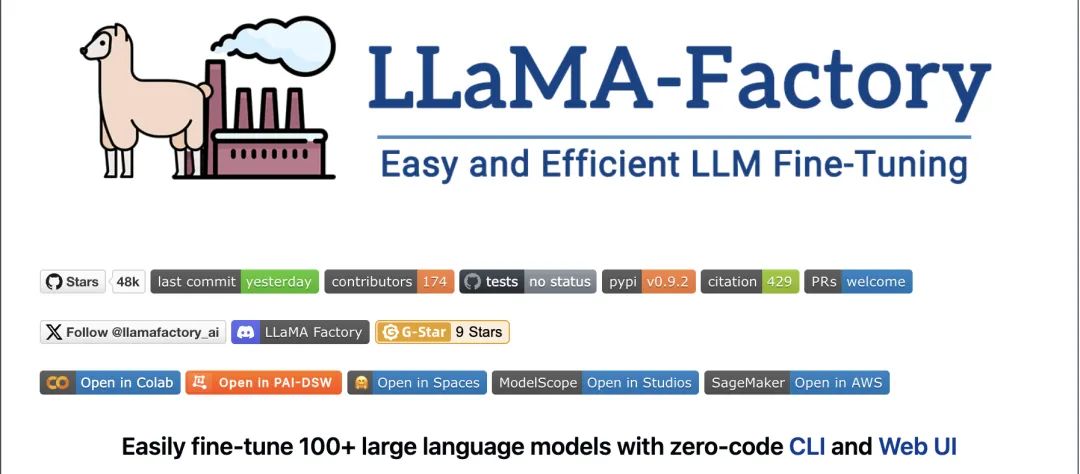

【学习笔记1】一站式大语言模型微调框架LLaMA-Factory

学习地址:https://llamafactory.cn/

学习文档:https://llamafactory.readthedocs.io/en/latest/getting_started/installation.html

github:https://github.com/hiyouga/LLaMA-Factory

LLaMA-Factory(Large Language Model Factory)是一个开源的、专注于大型语言模型(LLM)微调与部署的框架,由北航团队开发并维护。它通过提供低代码操作界面、丰富的算法支持以及硬件优化技术,显著降低了大模型定制化开发的技术门槛,广泛应用于智能客服、医疗诊断、法律助手等场景。

1. 核心功能与技术亮点

- 多模型兼容性

-

支持主流开源模型:LLaMA(包括LLaMA-2、LLaMA-3)、BLOOM、Mistral、Baichuan、Qwen、ChatGLM等。

-

扩展性:未来计划支持Gemma、Phi-3等新架构,进一步拓宽模型适配范围。

-

- 微调算法全覆盖

- 基础微调

全参数微调(32-bit精度)、冻结微调(16-bit精度)。

- 高效微调

LoRA(低秩适配)、QLoRA(4-bit量化+LoRA),显存占用降低至单卡消费级GPU(如RTX 3090)即可训练7B/13B模型。

- 强化学习

PPO(近端策略优化)、DPO/ORPO(偏好对齐训练),提升模型与人类需求的契合度。

- 领域适配

增量预训练、指令监督微调(SFT),支持医疗、法律等垂直领域数据注入。

- 基础微调

- 硬件优化与训练加速

- 量化技术

基于AQLM/AWQ/GPTQ的2-8比特QLoRA微调,显存消耗减少。

- 分布式训练

兼容PyTorch、DeepSpeed、FSDP,支持单机多卡/多机多卡并行计算。

- 混合精度

FP16/BF16计算类型适配不同GPU架构(如NVIDIA V100与AMD A10系列)。

- 量化技术

- 数据集与流程管理

- 内置数据集

包含Alpaca、ShareGPT等指令数据集,支持零代码直接调用。

- 自定义数据集

用户可上传JSON/CSV格式数据,框架自动处理分块与Token对齐。

- 标准化流程

模型选型→数据加载→参数配置(学习率、批次大小)→训练监控(损失曲线)→效果评估(BLEU、ROUGE)。

- 内置数据集

- 实验监控与评估

- 实时监控

集成TensorBoard、MLflow等工具,可视化训练指标。

- 自动评估

内置ROUGE分数计算,衡量模型输出与标准答案的相似度。

- 快速迭代

支持梯度检查点、动态分块技术,缩短调试周期。

- 实时监控

2. 环境安装

CUDA 是由 NVIDIA 创建的一个并行计算平台和编程模型,它让开发者可以使用 NVIDIA 的 GPU 进行高性能的并行计算。首先,在 https://developer.nvidia.com/ cuda-gpus 查看您的 GPU 是否支持CUDA。

1.保证当前 Linux 版本支持CUDA. 在命令行中输入 uname -m && cat /etc/*release,应当看到类似的输出

x86_64

DISTRIB_ID=Ubuntu

DISTRIB_RELEASE=22.042.检查是否安装了 gcc . 在命令行中输入 gcc --version ,应当看到类似的输出:

gcc (Ubuntu 11.4.0-1ubuntu1~22.04) 11.4.03.在以下网址下载所需的 CUDA,这里推荐12.2版本。 https://developer.nvidia.com/cuda-gpus 注意需要根据上述输出选择正确版本,如果您之前安装过 CUDA(例如为12.1版本),需要先使用 sudo /usr/local/cuda-12.1/bin/cuda-uninstaller 卸载。如果该命令无法运行,可以直接:

sudorm-r/usr/local/cuda-12.1/sudo apt clean && sudo apt auto clean

卸载完成后运行以下命令并根据提示继续安装:

wget https://developer.download.nvidia.com/compute/cuda/12.2.0/local_installers/cuda_12.2.0_535.54.03_linux.runsudo sh cuda_12.2.0_535.54.03_linux.run

3. LLaMA-Factory 安装

运行以下指令以安装 LLaMA-Factory 及其依赖:

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.gitcd LLaMA-Factorypip install -e ".[torch,metrics]"

如果出现环境冲突,请尝试使用 pip install --no-deps -e . 解决

4. LLaMA-Factory 校验

完成安装后,可以通过使用 llamafactory-cli version 来快速校验安装是否成功。如果您能成功看到类似下面的界面,就说明安装成功了。

5.其它环境包