Day22_【机器学习—集成学习(1)—基本思想、分类】

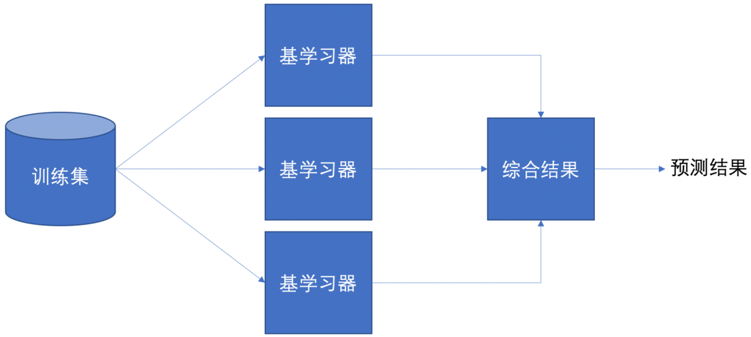

集成学习(Ensemble Learning) ,是一种机器学习的思想,通过结合多个弱学习器(模型)来构建一个更强大的“强”学习器。其核心思想是“三个臭皮匠,赛过诸葛亮”——多个模型的组合往往比单一模型表现更好、更稳定。

一、集成学习的基本思想

- 单个模型可能存在偏差大(欠拟合)或方差大(过拟合)的问题。

- 集成学习通过训练多个不同的弱学习器,并将它们的预测结果进行组合(如投票、加权平均等),从而降低整体的泛化误差。

- 成功的集成要求:个体学习器之间具有多样性(diversity),即它们的错误不完全相关。

二、集成学习的分类

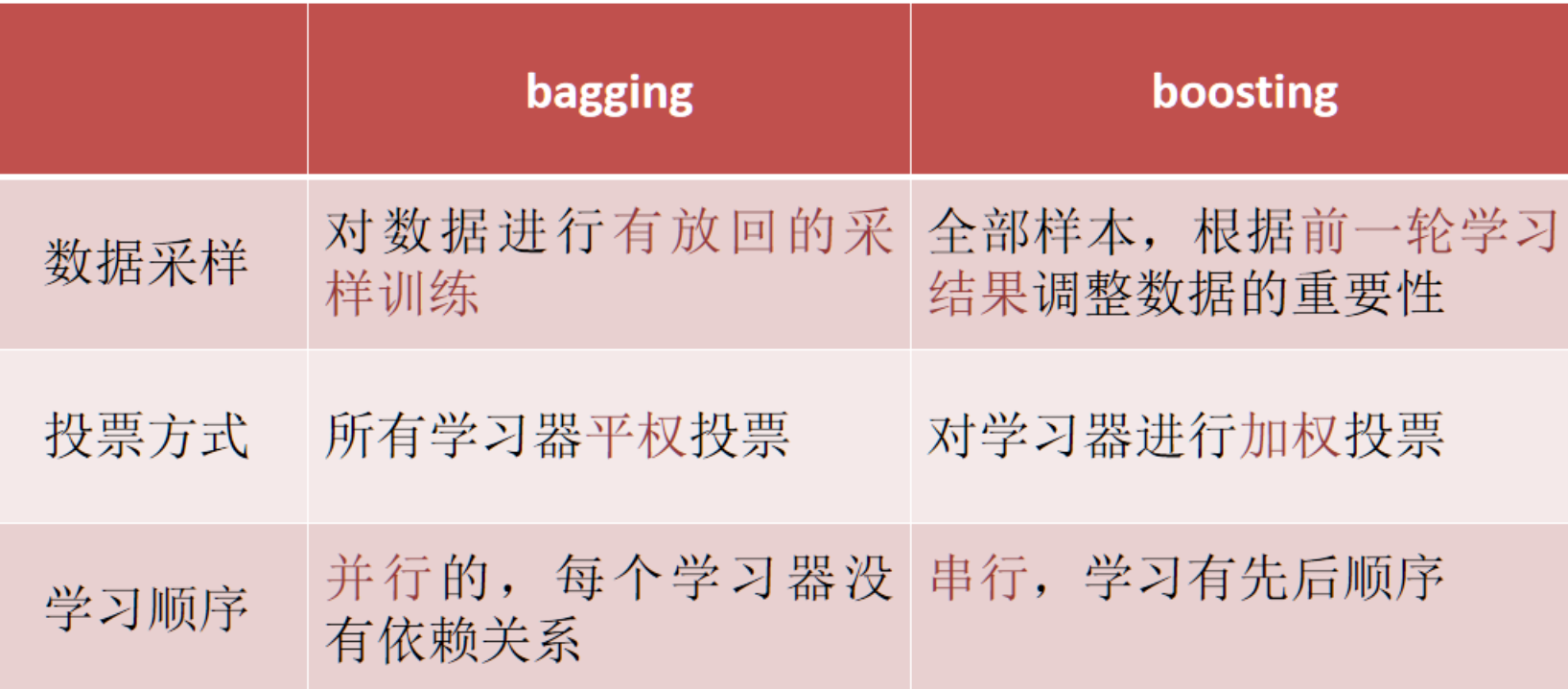

| 方法 | 训练方式 | 目标 | 典型算法 | 适用场景 |

|---|---|---|---|---|

| Bagging | 并行 | 降方差 | 随机森林 | 高方差模型、特征多 |

| Boosting | 串行 | 降偏差 | AdaBoost, XGBoost | 欠拟合、精度要求高 |

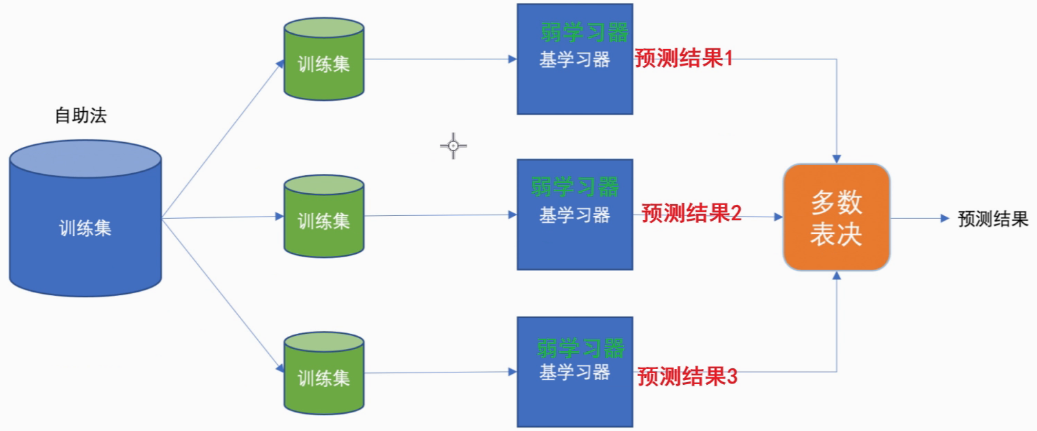

1.Bagging

- 有放回的抽样(bootstrap抽样)产生不同的训练集,从而训练不同的学习器

- 通过平权投票、多数表决的方式决定预测结果

- 弱学习器可以并行训练

代表算法:随机森林算法

随机抽样的原因:

如果不进行随机抽样,每棵树的训练集都一样,那么最终训练出的树分类结果也是完全一样。

有放回抽样的原因:

保证弱学习器的训练样本既有交集也有差异数据,更容易发挥投票表决效果

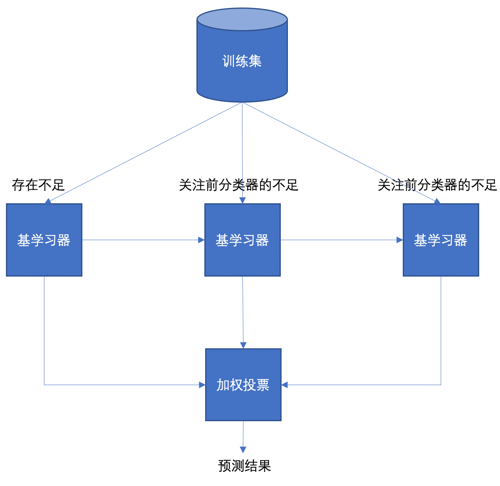

2.Boosting

- 每一个训练器重点关注前一个训练器不足的地方进行训练

- 通过加权投票的方式,得出预测结果(预测正确权重降低,预测错误,权重增加)

- 串行的训练方式

代表算法:Adaboost、XGboost、GBDT算法

3.对比