Gemini 2.5 Flash-Lite 与 GPT-5-mini:高性能低成本模型,如何选择?

当前,AI应用开发者和技术决策者在模型选型时,往往面临一个核心矛盾:是选择性能强大但成本高昂的大模型,还是选择成本可控但能力稍逊的轻量化模型?随着大模型技术的快速发展,市面上出现了越来越多定位各异的产品,精细化选型已成为项目成功的关键因素之一。

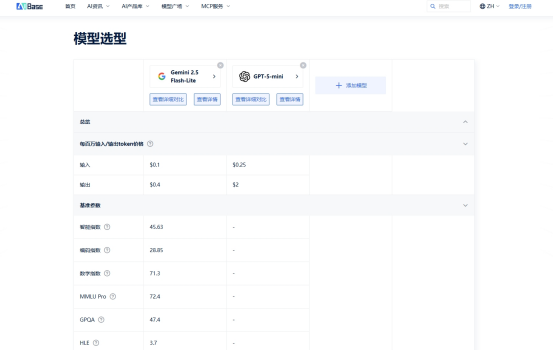

本文将以Google最新推出的Gemini 2.5 Flash-Lite和OpenAI的GPT-5-mini为例,基于AIbase模型选型对比平台提供的客观数据,从多个维度进行深度分析,帮助您根据实际需求做出明智选择。

一、核心性能对比

根据AIbase平台上的综合能力评分(涵盖推理、代码、数学等多个维度):

GPT-5-mini在综合评分上略占优势,特别是在复杂逻辑推理和代码生成任务上表现突出,适合需要较高准确性的场景。

Gemini 2.5 Flash-Lite虽然在绝对性能上稍逊,但在多轮对话、指令遵循和通用语言理解任务上表现稳定,满足大多数日常应用需求。

2款模型均具备强大的基础能力,差距更多体现在对特定任务类型的优化上。

二、价格体系与成本分析

价格是很多团队重点关注的因素。我们基于AIbase平台提供的官方定价数据(截至2025年8月)进行对比:

成本直观对比:

假设一个常见场景:需要处理1000篇平均长度为1万汉字(约合13,500 tokens)的文档进行摘要生成。

总输入tokens13.5 M tokens

总输出tokens(按摘要长度为原文10%计):1.35 M tokens

由此可见,在此规模下,Gemini 2.5 Flash-Lite的成本约为GPT-5-mini的40%,对于大规模应用而言,成本差异会随着使用量倍增而显著扩大。

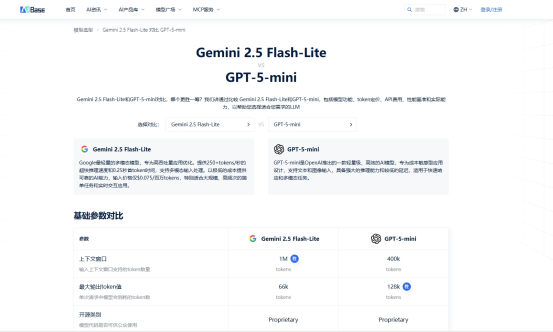

三、上下文长度对比

两款模型均支持128K超长上下文,这为实际项目开发带来了巨大便利:

长文档处理:一次性处理数百页的技术手册、法律合同或学术论文,完成高质量摘要、问答和分析。

代码库分析:能够深入分析中小型项目的完整代码库,进行代码理解、生成和重构。

复杂对话记忆:在多轮对话应用中维持更长时间的上下文记忆,提供更连贯的交互体验。

对于需要处理长文本信息的应用场景,128K上下文窗口已成为提升应用效果的关键能力。

四、特色功能与最佳适用场景

根据AIbase平台上的详细测试数据:

Gemini 2.5 Flash-Lite 更适合:

大规模数据处理任务,对成本敏感的应用场景

多语言处理任务,特别是在非英语语言上的表现

常规内容生成、对话系统和文档处理

GPT-5-mini 更擅长:

复杂推理任务和需要高准确性的代码生成

对输出质量要求极高的创意写作和技术内容生成

需要最强综合能力的通用人工智能应用

结论:如何根据需求选择?

选择模型时,不应简单地问"哪个模型更好",而应问"哪个模型更适合我的具体需求":

如果您的首要需求是极致性价比,需要处理大量数据且对成本敏感,Gemini 2.5 Flash-Lite 可能是更明智的选择。

如果您需要最强的综合性能,特别是在推理和代码能力上,且预算相对充足,GPT-5-mini 值得考虑。

如果您的应用需要处理超长文本,两款模型都能提供128K上下文支持,但需要结合具体性能和成本做权衡。

建议:最佳的模型选型策略是基于您的具体使用场景进行测试。推荐使用AIbase模型对比平台(https://model.aibase.com/zh/compare)提供的详细数据和在线测试功能,针对您的实际任务进行并行测试,用数据支撑决策。

无论选择哪款模型,都建议在正式大规模应用前进行充分测试,确保模型能力符合您的预期,同时精确计算总体拥有成本,找到性能与预算之间的最佳平衡点。

本文数据来源于AIbase模型选型对比平台,仅供参考。实际性能可能因使用场景和测试数据而异,请以各厂商官方信息为准。