在Window10 和 Ubuntu 24.04LTS 上 Ollama 在线或离线安装部署

Ollama 是一个开源的大型语言模型(LLM)服务框架,旨在通过轻量化、跨平台的设计,简化大模型在本地环境中的部署与应用。其基于 Go 语言开发,通过 Docker 容器化技术封装模型运行环境,提供类似命令行工具的交互体验(如 pull、run 等指令),支持用户在 Windows、Linux、macOS 甚至树莓派等设备上快速启动 qwen3、deepseek 等主流开源模型。

官方网址:https://ollama.com/

开源仓库: https://github.com/ollama/ollama

离线安装包下载地址:https://github.com/ollama/ollama/releases

# ollama 常用命令:

## 启动Ollama服务

ollama serve

## 从模型文件创建模型

ollama create

## 显示模型信息

ollama show

## 运行模型

ollama run 模型名称 ( ollama run --verbose <模型名称> )

## 从注册表中拉去模型

ollama pull 模型名称

## 将模型推送到注册表

ollama push

## 列出模型

ollama list

## 复制模型

ollama cp

## 删除模型

ollama rm 模型名称

## 获取有关Ollama任何命令的帮助信息

ollama help一、Window10 安装 Ollama 并配置模型存放盘符

Windows版本下载地址:https://ollama.com/download/OllamaSetup.exe

Windows版本 Ollama 通常的 .exe 格式的安装程序,直接点击下载。然后,双击运行,根据提示一步一步安装即可。

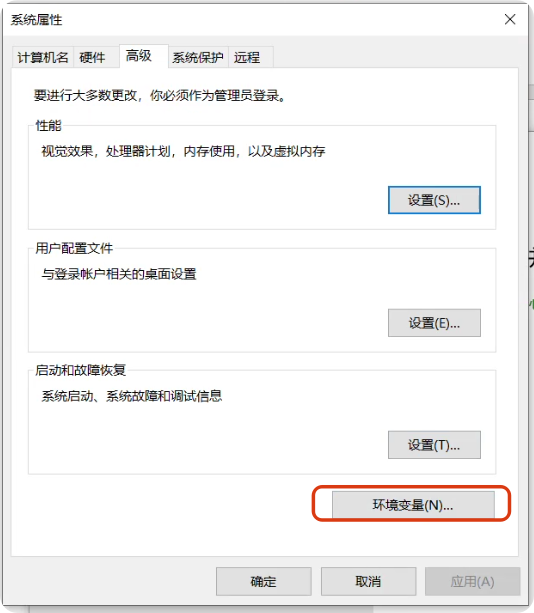

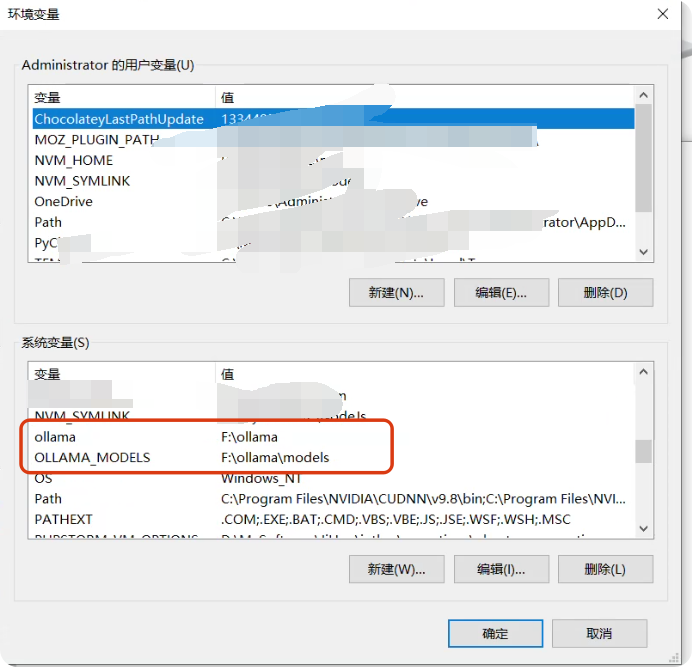

1.1 修改模型安装位置(默认C盘)

默认位置:C:\Users\%username%\.ollama\models 。如果你的C盘磁盘容量不够,可以修改环境变量,在“新建系统变量”窗口中,输入变量名OLLAMA_MODELS,变量值为你希望的模型存储路径(例如F:\ollama\models)。重启电脑后即刻生效。

二、在 Ubuntu24.04 LTS 上 Ollama 在线安装部署

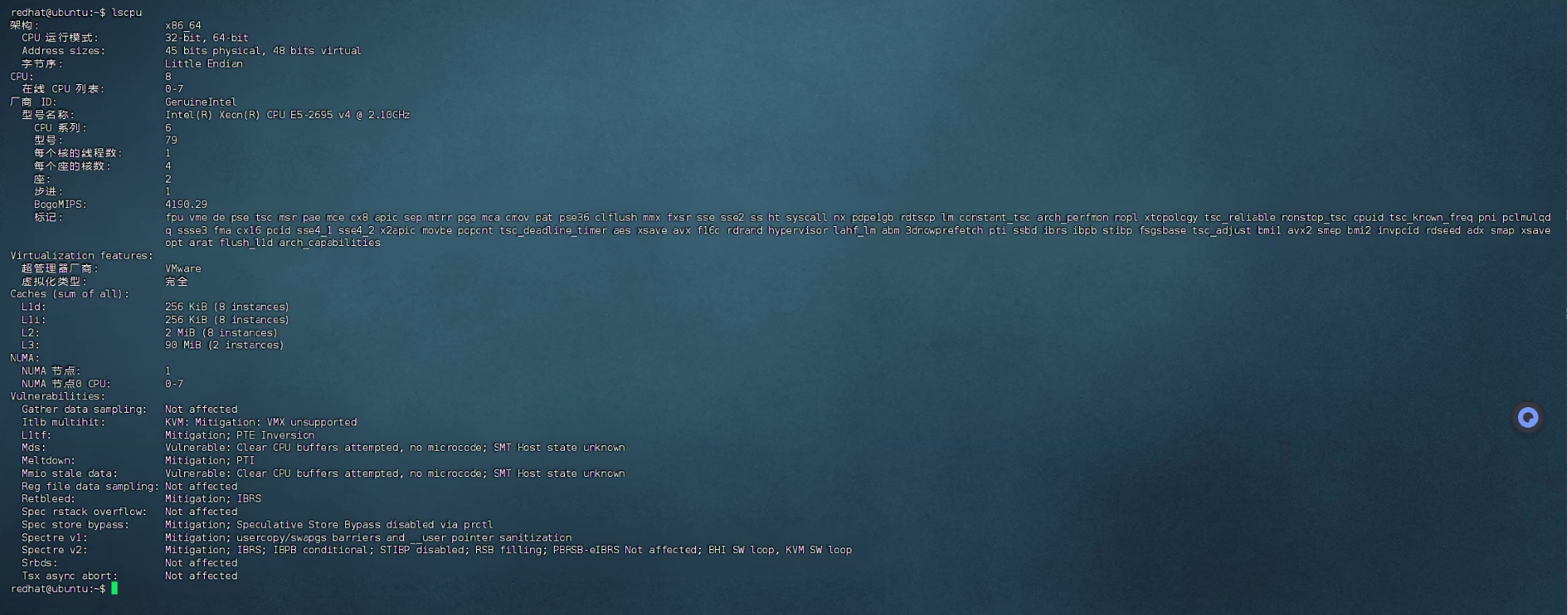

选择合适自己的主机的安装包,查看系统架构:lscpu ;如果是 x86_64 (Intel/AMD):下载 ollama-linux-amd64.tgz ;如果你的系统是 ARM64 架构:ollama-linux-arm64.tgz 。

在线命令安装(需要机子能访问互联网):

curl -fsSL https://ollama.com/install.sh | sh# 启动ollamasystemctl start ollama

# 查询ollama状态systemctl status ollama

# 重启服务systemctl daemon-reloadsystemctl restart ollama# 启用开机自启动systemctl enable ollama三、在 Ubuntu24.04 LTS 上 Ollama 离线安装部署

选择合适自己的主机的安装包,查看系统架构:lscpu ;如果是 x86_64 (Intel/AMD):下载 ollama-linux-amd64.tgz ;如果你的系统是 ARM64 架构:ollama-linux-arm64.tgz 。

# 将下载好的安装包进行解压,解压到/usr,解压命令:

sudo tar -C /usr -xzf ollama-linux-amd64.tgz# 然后为解压的文件添加权限:

sudo chmod +x /usr/bin/ollama# 创建 ollama 用户组和用户:

sudo useradd -r -s /bin/false -m -d /data/ollama ollama参数解释:

• -r:创建系统用户。

• -s /bin/false:禁止该用户登录。

• -d /data/ollama:指定用户主目录(存放模型文件)

# 创建系统文件并配置信息:

sudo vim /etc/systemd/system/ollama.service# 配置信息如下:[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

# 自定义端口

Environment="OLLAMA_HOST=0.0.0.0:11434"

#代表让ollama能识别到第几张显卡

Environment="CUDA_VISIBLE_DEVICES=0,1,2,3,4,5,6,7"

#这几张卡均衡使用

Environment="OLLAMA_SCHED_SPREAD=1"

#模型一直加载, 不自动卸载

Environment="OLLAMA_KEEP_ALIVE=-1"

#配置跨域请求

Environment="OLLAMA_ORIGINS=*"

#配置OLLAMA的模型存放路径,默认路径是/usr/share/ollama/.ollama/models/

Environment="OLLAMA_MODELS=/data/ollama/.ollama/models"

[Install]

WantedBy=default.target完成之后,执行命令:

# 启动ollamasystemctl start ollama

# 查询ollama状态systemctl status ollama

# 重启服务systemctl daemon-reloadsystemctl restart ollama# 启用开机自启动systemctl enable ollama查看 ollama 是否安装成功,查看版本:

ollama -version四、利用 Docker 安装 ollama

# 拉取 ollama 的镜像,拉取命令:

docker pull ollama/ollama# 拉取完成后,需要创建容器来运行 ollama,如果你电脑没有 GPU,则使用cpu版本命令:docker run -dit --name ollama11434 -p 11434:11434 ollama/ollama

# 用 GPU 版本(需要显卡与容器驱动支持),命令如下:docker run -dit --name ollama11434 --gpus all -p 11434:11434 ollama/ollama# 参数:-p 11436:11434 将容器的 11434 端口映射到宿主机的 11436 端口# 创建好容器后,需要进入 Docker 容器,进入容器后,执行ollama相关命令即可docker exec -it ollama11434 bash--------------------------------------

没有自由的秩序和没有秩序的自由,同样具有破坏性。