【完整源码+数据集+部署教程】雪崩检测与分类图像分割系统源码和数据集:改进yolo11-HSFPN

背景意义

研究背景与意义

雪崩作为一种自然灾害,常常对人类生命和财产安全造成严重威胁。随着全球气候变化的加剧,雪崩的发生频率和强度也在逐渐增加,尤其是在高山地区和滑雪场等人类活动频繁的区域。因此,及时、准确地检测和分类雪崩类型,成为了防灾减灾工作中的一项重要任务。传统的雪崩监测方法主要依赖于人工观察和气象数据分析,效率低下且容易受到人为因素的影响。随着计算机视觉技术的快速发展,基于深度学习的图像分割和目标检测方法逐渐成为雪崩监测的新兴手段。

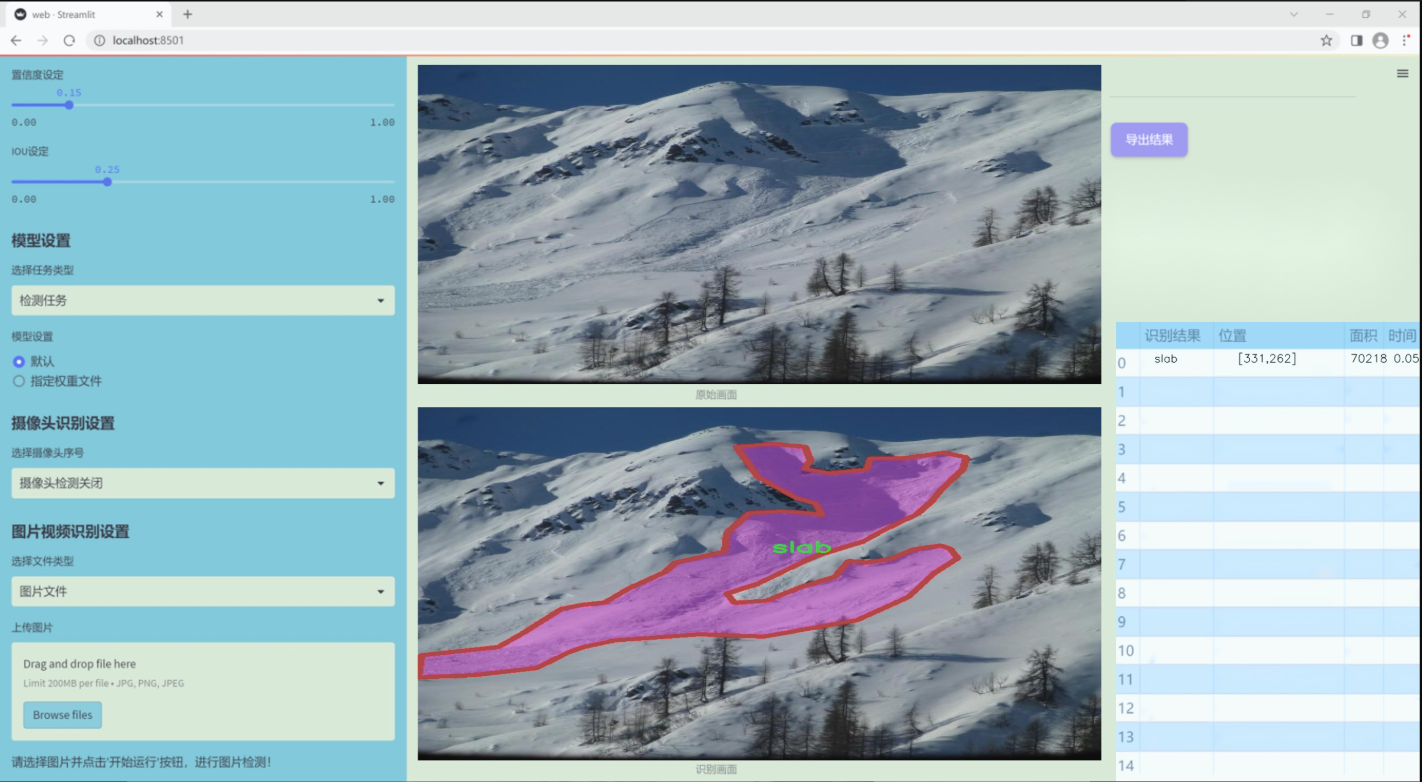

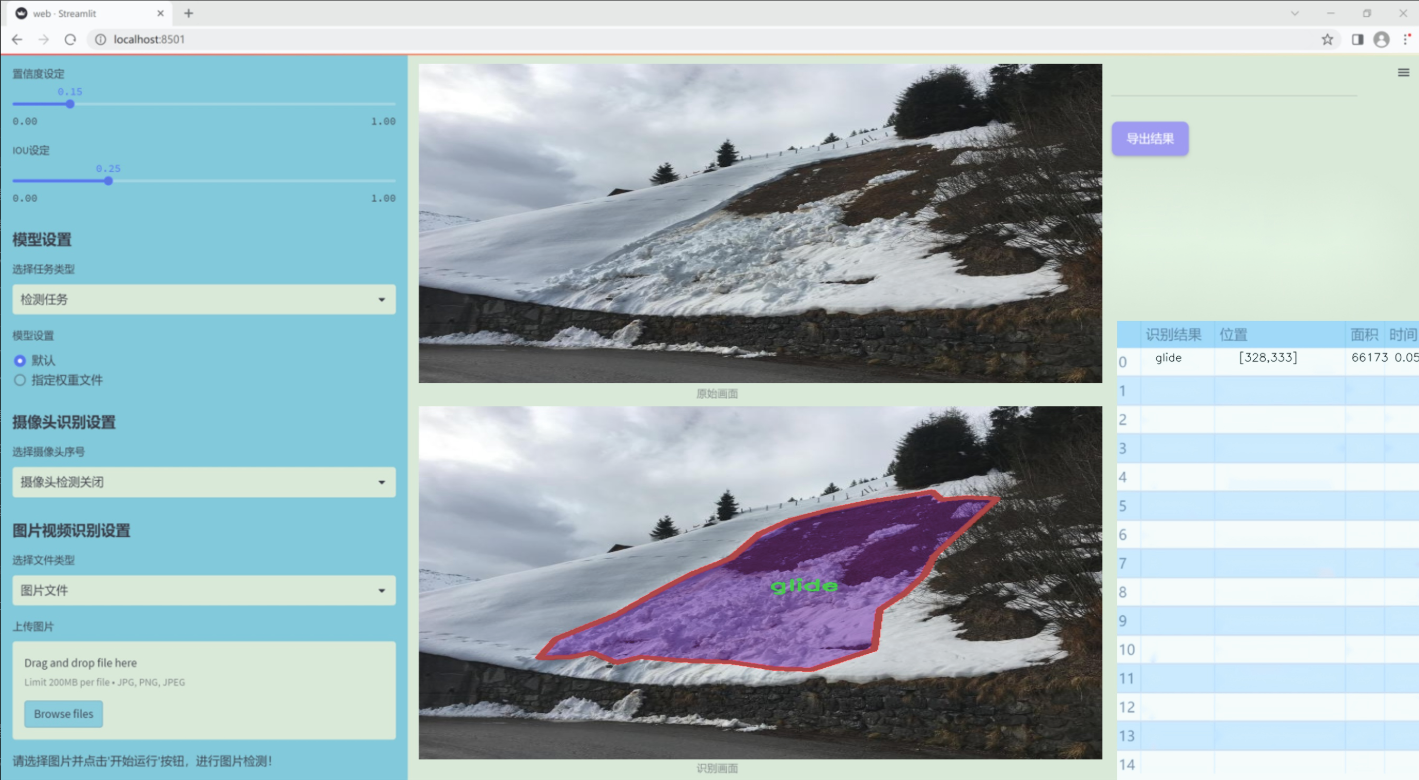

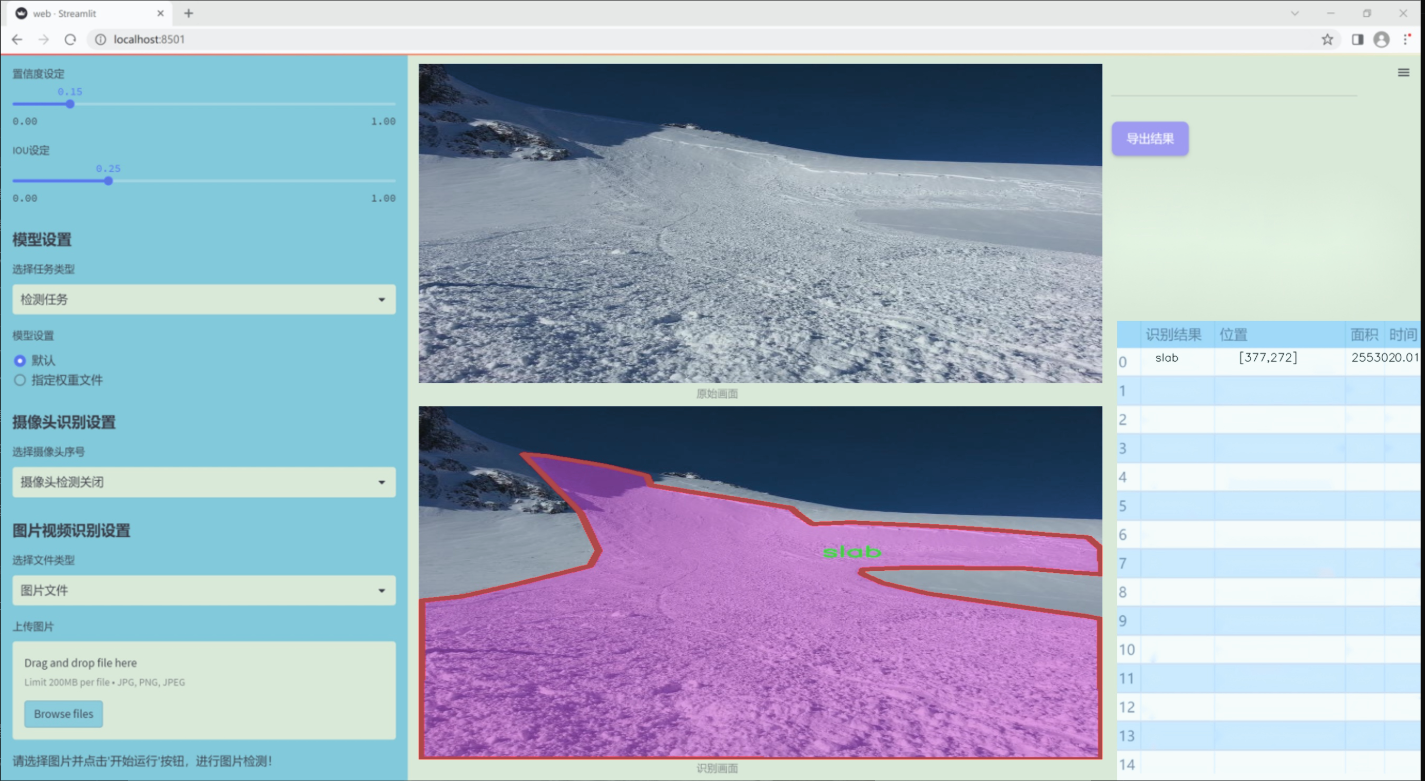

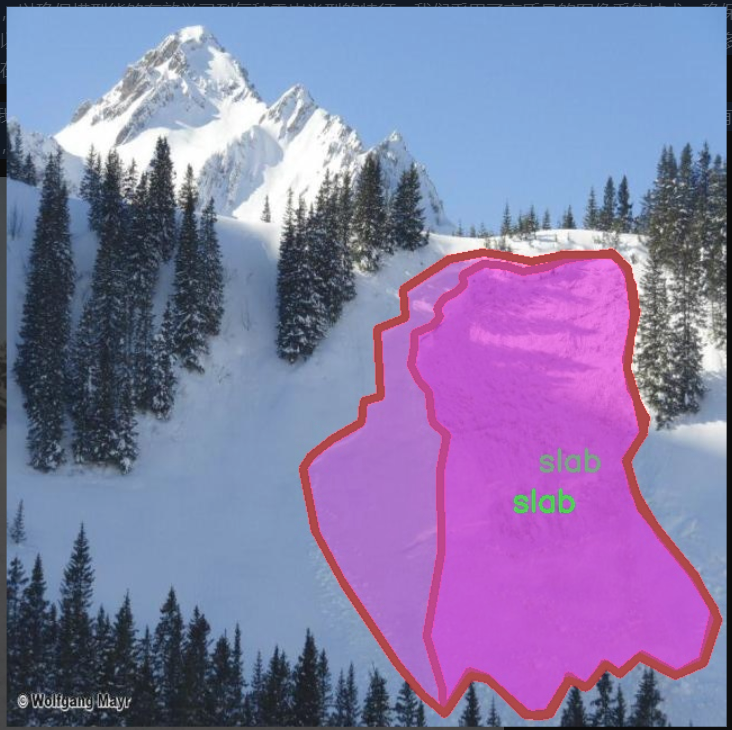

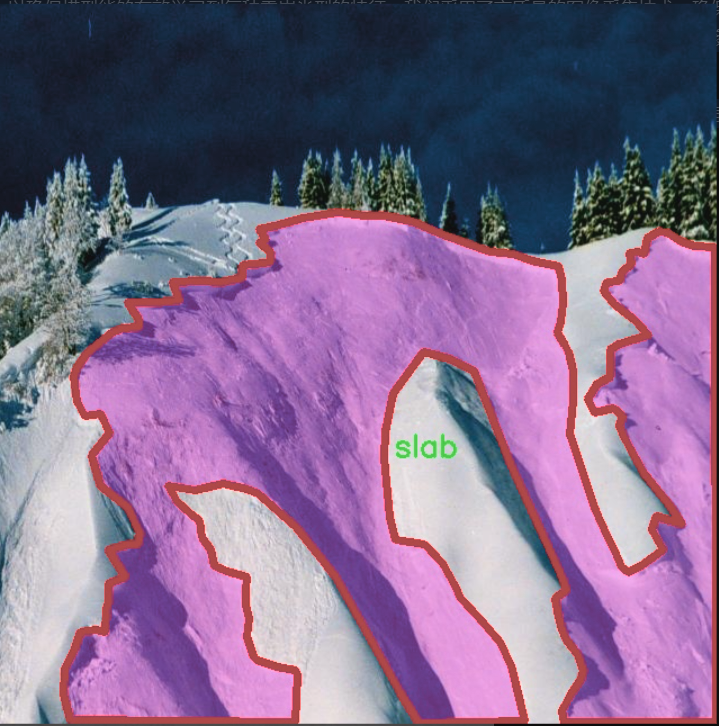

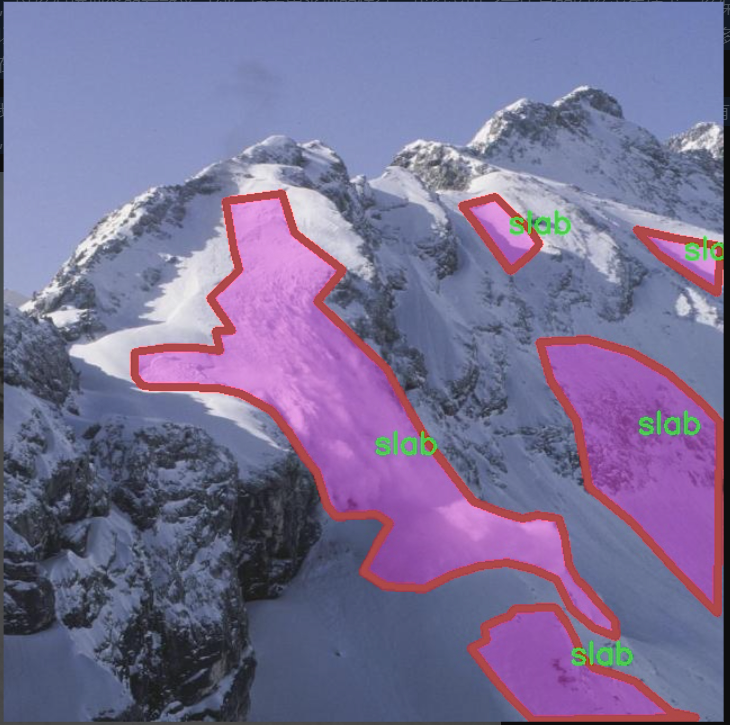

本研究旨在基于改进的YOLOv11模型,构建一个高效的雪崩检测与分类图像分割系统。该系统将利用一个包含4100张图像的数据集,涵盖三种雪崩类型:滑动雪崩(glide)、松散雪崩(loose)和板状雪崩(slab)。通过对这些图像进行实例分割,系统能够精确识别不同类型的雪崩,并为后续的风险评估和应急响应提供科学依据。

改进YOLOv11模型的引入,旨在提升检测精度和处理速度,使其能够在复杂的自然环境中实时运行。此外,利用实例分割技术,可以更好地理解雪崩的形态特征及其对周围环境的影响,从而为雪崩的预警和管理提供更为详尽的信息。这一研究不仅具有重要的理论意义,还有助于推动雪崩监测技术的进步,进而提高公众安全意识和应对能力,为减少雪崩带来的损失贡献力量。

图片效果

数据集信息

本项目旨在改进YOLOv11的雪崩检测与分类图像分割系统,为此我们构建了一个专门的数据集,名为“avalert”。该数据集专注于雪崩相关的图像数据,涵盖了三种主要类别,分别是“glide”(滑动雪崩)、“loose”(松散雪崩)和“slab”(板状雪崩)。这些类别的选择基于雪崩发生的不同机制和特征,旨在为系统提供多样化的训练样本,以提高其在实际应用中的准确性和鲁棒性。

在数据集的构建过程中,我们收集了大量的雪崩图像,这些图像来自于不同的地理区域和气候条件,以确保数据的多样性和代表性。每一类雪崩都有相应的标注,标注信息包括雪崩的类型、发生的环境以及相关的地理特征。这些信息不仅有助于模型的训练,还能为后续的分析提供丰富的背景资料。

数据集的规模经过精心设计,以确保模型能够有效学习到每种雪崩类型的特征。我们采用了高质量的图像采集技术,确保数据的清晰度和细节表现,以便于模型在进行图像分割时能够准确识别和分类不同类型的雪崩。此外,数据集还包含了多种场景下的雪崩图像,例如在不同光照条件、不同天气状态下的雪崩情景,这为模型的泛化能力提供了良好的基础。

通过使用“avalert”数据集,我们期望能够显著提升YOLOv11在雪崩检测与分类任务中的性能,使其能够在实际应用中更有效地识别和预测雪崩的发生,从而为相关领域的安全管理和风险评估提供有力支持。

核心代码

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

import torch.nn as nn

import torch.nn.functional as F

from torch.autograd import Function

import pywt

def create_wavelet_filter(wave, in_size, out_size, type=torch.float):

# 创建小波滤波器

w = pywt.Wavelet(wave) # 使用PyWavelets库创建小波对象

# 反转并转换为张量

dec_hi = torch.tensor(w.dec_hi[::-1], dtype=type)

dec_lo = torch.tensor(w.dec_lo[::-1], dtype=type)

# 生成分解滤波器

dec_filters = torch.stack([dec_lo.unsqueeze(0) * dec_lo.unsqueeze(1),

dec_lo.unsqueeze(0) * dec_hi.unsqueeze(1),

dec_hi.unsqueeze(0) * dec_lo.unsqueeze(1),

dec_hi.unsqueeze(0) * dec_hi.unsqueeze(1)], dim=0)

# 扩展滤波器以适应输入通道数

dec_filters = dec_filters[:, None].repeat(in_size, 1, 1, 1)

# 生成重构滤波器

rec_hi = torch.tensor(w.rec_hi[::-1], dtype=type).flip(dims=[0])

rec_lo = torch.tensor(w.rec_lo[::-1], dtype=type).flip(dims=[0])

rec_filters = torch.stack([rec_lo.unsqueeze(0) * rec_lo.unsqueeze(1),rec_lo.unsqueeze(0) * rec_hi.unsqueeze(1),rec_hi.unsqueeze(0) * rec_lo.unsqueeze(1),rec_hi.unsqueeze(0) * rec_hi.unsqueeze(1)], dim=0)

# 扩展滤波器以适应输出通道数

rec_filters = rec_filters[:, None].repeat(out_size, 1, 1, 1)return dec_filters, rec_filters

def wavelet_transform(x, filters):

# 执行小波变换

b, c, h, w = x.shape # 获取输入张量的形状

pad = (filters.shape[2] // 2 - 1, filters.shape[3] // 2 - 1) # 计算填充

# 使用卷积进行小波变换

x = F.conv2d(x, filters.to(x.dtype).to(x.device), stride=2, groups=c, padding=pad)

x = x.reshape(b, c, 4, h // 2, w // 2) # 重塑输出形状

return x

def inverse_wavelet_transform(x, filters):

# 执行逆小波变换

b, c, _, h_half, w_half = x.shape # 获取输入张量的形状

pad = (filters.shape[2] // 2 - 1, filters.shape[3] // 2 - 1) # 计算填充

x = x.reshape(b, c * 4, h_half, w_half) # 重塑输入形状

# 使用转置卷积进行逆小波变换

x = F.conv_transpose2d(x, filters.to(x.dtype).to(x.device), stride=2, groups=c, padding=pad)

return x

class WaveletTransform(Function):

# 定义小波变换的自定义函数

@staticmethod

def forward(ctx, input, filters):

ctx.filters = filters # 保存滤波器以便反向传播使用

with torch.no_grad():

x = wavelet_transform(input, filters) # 执行前向小波变换

return x

@staticmethod

def backward(ctx, grad_output):grad = inverse_wavelet_transform(grad_output, ctx.filters) # 执行逆小波变换以计算梯度return grad, None

class WTConv2d(nn.Module):

# 定义小波卷积层

def init(self, in_channels, out_channels, kernel_size=5, stride=1, bias=True, wt_levels=1, wt_type=‘db1’):

super(WTConv2d, self).init()

assert in_channels == out_channels # 输入通道数必须等于输出通道数self.in_channels = in_channelsself.wt_levels = wt_levelsself.stride = stride# 创建小波滤波器self.wt_filter, self.iwt_filter = create_wavelet_filter(wt_type, in_channels, in_channels, torch.float)self.wt_filter = nn.Parameter(self.wt_filter, requires_grad=False) # 不需要训练的小波滤波器self.iwt_filter = nn.Parameter(self.iwt_filter, requires_grad=False) # 不需要训练的逆小波滤波器# 初始化小波变换和逆小波变换的函数self.wt_function = wavelet_transform_init(self.wt_filter)self.iwt_function = inverse_wavelet_transform_init(self.iwt_filter)# 基础卷积层self.base_conv = nn.Conv2d(in_channels, in_channels, kernel_size, padding='same', stride=1, groups=in_channels, bias=bias)def forward(self, x):# 前向传播# 省略其他层的细节x = self.base_conv(x) # 通过基础卷积层return x

代码说明:

创建小波滤波器:create_wavelet_filter 函数生成用于小波变换和逆变换的滤波器。

小波变换和逆变换:wavelet_transform 和 inverse_wavelet_transform 函数分别实现小波变换和逆变换。

自定义函数:WaveletTransform 类定义了小波变换的前向和反向传播逻辑。

小波卷积层:WTConv2d 类实现了一个小波卷积层,包含基础卷积和小波变换的逻辑。

以上是代码的核心部分及其详细注释,帮助理解小波变换在卷积神经网络中的应用。

这个程序文件 wtconv2d.py 实现了一个基于小波变换的二维卷积层,命名为 WTConv2d。该层结合了小波变换和卷积操作,能够在特征提取和图像处理任务中提供更丰富的表示能力。

首先,文件导入了必要的库,包括 PyTorch 和 PyWavelets。接着,定义了一些辅助函数。create_wavelet_filter 函数用于生成小波变换的滤波器,输入参数包括小波类型、输入和输出通道数。该函数通过 PyWavelets 库生成小波的分解和重构滤波器,并将其转换为 PyTorch 张量。

wavelet_transform 和 inverse_wavelet_transform 函数分别实现了小波变换和逆小波变换。它们通过卷积操作对输入张量进行处理,并利用小波滤波器进行特征提取和重构。

接下来,定义了两个类 WaveletTransform 和 InverseWaveletTransform,它们继承自 torch.autograd.Function。这两个类分别实现了小波变换和逆变换的前向和反向传播逻辑。通过使用上下文管理器 ctx,可以在反向传播时获取所需的滤波器。

wavelet_transform_init 和 inverse_wavelet_transform_init 函数用于初始化小波变换和逆变换的应用函数,这些函数将会在 WTConv2d 类中使用。

WTConv2d 类是该文件的核心部分,继承自 nn.Module。在初始化方法中,首先检查输入和输出通道数是否相等。然后创建小波滤波器,并定义小波变换和逆变换的函数。该类还包含一个基础卷积层 base_conv 和多个小波卷积层 wavelet_convs,用于处理不同层次的小波特征。

在 forward 方法中,输入张量经过小波变换,分解为低频和高频部分。每一层的小波变换结果都被存储,并在最后通过逆小波变换重构出最终的特征图。最后,基础卷积层的输出与小波变换的输出相加,形成最终的输出。如果设定了步幅,则会应用步幅卷积。

最后,_ScaleModule 类用于实现缩放操作,通过学习的参数对输入进行缩放,增强了模型的灵活性。

总体而言,这个文件实现了一个结合小波变换和卷积操作的深度学习模块,适用于需要多尺度特征提取的任务,如图像处理和计算机视觉。

10.4 deconv.py

以下是经过简化和注释的核心代码部分,主要保留了卷积层的定义和前向传播的逻辑。

import math

import torch

from torch import nn

from einops.layers.torch import Rearrange

定义一个自定义的二维卷积层,带有权重获取功能

class Conv2d_cd(nn.Module):

def init(self, in_channels, out_channels, kernel_size=3, stride=1,

padding=1, dilation=1, groups=1, bias=False, theta=1.0):

super(Conv2d_cd, self).init()

# 初始化标准的卷积层

self.conv = nn.Conv2d(in_channels, out_channels, kernel_size=kernel_size, stride=stride, padding=padding, dilation=dilation, groups=groups, bias=bias)

self.theta = theta # 可调参数

def get_weight(self):# 获取卷积层的权重并进行处理conv_weight = self.conv.weightconv_shape = conv_weight.shape# 重排权重的形状conv_weight = Rearrange('c_in c_out k1 k2 -> c_in c_out (k1 k2)')(conv_weight)# 创建一个新的权重张量并初始化为0conv_weight_cd = torch.zeros(conv_shape[0], conv_shape[1], 3 * 3, device=conv_weight.device, dtype=conv_weight.dtype)# 将原始权重赋值到新权重中conv_weight_cd[:, :, :] = conv_weight[:, :, :]# 调整权重以确保和为0conv_weight_cd[:, :, 4] = conv_weight[:, :, 4] - conv_weight[:, :, :].sum(2)# 重排回原来的形状conv_weight_cd = Rearrange('c_in c_out (k1 k2) -> c_in c_out k1 k2', k1=conv_shape[2], k2=conv_shape[3])(conv_weight_cd)return conv_weight_cd, self.conv.bias # 返回处理后的权重和偏置

定义一个包含多个卷积层的解卷积模型

class DEConv(nn.Module):

def init(self, dim):

super(DEConv, self).init()

# 初始化多个自定义卷积层

self.conv1_1 = Conv2d_cd(dim, dim, 3, bias=True)

self.conv1_2 = Conv2d_cd(dim, dim, 3, bias=True) # 使用相同的类进行示例

self.conv1_3 = Conv2d_cd(dim, dim, 3, bias=True)

self.conv1_4 = Conv2d_cd(dim, dim, 3, bias=True)

self.conv1_5 = nn.Conv2d(dim, dim, 3, padding=1, bias=True)

self.bn = nn.BatchNorm2d(dim) # 批归一化层self.act = nn.ReLU() # 激活函数def forward(self, x):# 前向传播w1, b1 = self.conv1_1.get_weight()w2, b2 = self.conv1_2.get_weight()w3, b3 = self.conv1_3.get_weight()w4, b4 = self.conv1_4.get_weight()w5, b5 = self.conv1_5.weight, self.conv1_5.bias# 将所有卷积层的权重和偏置相加w = w1 + w2 + w3 + w4 + w5b = b1 + b2 + b3 + b4 + b5# 使用合并后的权重和偏置进行卷积操作res = nn.functional.conv2d(input=x, weight=w, bias=b, stride=1, padding=1, groups=1)# 进行批归一化和激活res = self.bn(res)return self.act(res)def switch_to_deploy(self):# 将模型切换到部署模式,合并权重和偏置w1, b1 = self.conv1_1.get_weight()w2, b2 = self.conv1_2.get_weight()w3, b3 = self.conv1_3.get_weight()w4, b4 = self.conv1_4.get_weight()w5, b5 = self.conv1_5.weight, self.conv1_5.bias# 合并权重和偏置self.conv1_5.weight = torch.nn.Parameter(w1 + w2 + w3 + w4 + w5)self.conv1_5.bias = torch.nn.Parameter(b1 + b2 + b3 + b4 + b5)# 删除不再需要的卷积层del self.conv1_1del self.conv1_2del self.conv1_3del self.conv1_4

示例代码

if name == ‘main’:

data = torch.randn((1, 128, 64, 64)).cuda() # 创建输入数据

model = DEConv(128).cuda() # 初始化模型

output1 = model(data) # 前向传播

model.switch_to_deploy() # 切换到部署模式

output2 = model(data) # 再次前向传播

print(torch.allclose(output1, output2)) # 检查输出是否相同

代码注释说明:

Conv2d_cd 类:定义了一个自定义的二维卷积层,包含权重的获取和处理方法。

DEConv 类:构建了一个包含多个卷积层的解卷积模型,支持前向传播和权重合并的功能。

前向传播:在 forward 方法中,获取所有卷积层的权重和偏置,并进行卷积操作,最后通过批归一化和激活函数处理输出。

switch_to_deploy 方法:合并所有卷积层的权重和偏置,以减少模型在推理时的计算量,并删除不再需要的卷积层。

这个程序文件 deconv.py 定义了一系列卷积神经网络的模块,主要用于实现不同类型的卷积操作。文件中包含多个类,每个类都继承自 nn.Module,并实现了特定的卷积功能。

首先,Conv2d_cd、Conv2d_ad、Conv2d_rd、Conv2d_hd 和 Conv2d_vd 这些类都是自定义的卷积层。它们的构造函数中都初始化了一个标准的二维卷积层 nn.Conv2d,并提供了一些参数,如输入和输出通道数、卷积核大小、步幅、填充等。每个类都有一个 get_weight 方法,用于获取卷积层的权重,并根据特定的规则对权重进行处理。

Conv2d_cd 类的 get_weight 方法会对卷积权重进行重排,并调整权重的某些值,使其满足特定的条件。

Conv2d_ad 类则通过对权重进行加权和重排,生成新的卷积权重。

Conv2d_rd 类在前向传播中根据 theta 的值决定是否使用标准卷积或自定义的卷积权重。

Conv2d_hd 和 Conv2d_vd 类的 get_weight 方法则主要处理一维卷积的权重。

接下来,DEConv 类是一个更复杂的模块,它整合了前面定义的多个卷积层。构造函数中定义了多个卷积层,并在前向传播中通过调用每个卷积层的 get_weight 方法来获取权重和偏置,然后将它们相加,最终通过 nn.functional.conv2d 进行卷积操作。该类还包含了批归一化和激活函数的应用。

switch_to_deploy 方法用于在模型部署时优化模型结构。它将多个卷积层的权重和偏置合并到最后一个卷积层中,并删除中间的卷积层,以减少模型的复杂性和提高推理速度。

在文件的最后部分,有一个简单的测试代码段。它创建了一个随机输入数据,并实例化 DEConv 模型进行前向传播。然后调用 switch_to_deploy 方法进行模型优化,最后再次进行前向传播,并检查两次输出是否相等。

总体来说,这个文件实现了多种卷积操作的自定义实现,并通过组合这些操作来构建一个更复杂的卷积神经网络模块,适用于深度学习任务。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式👇🏻