2025年国内AI大模型现状浅析

引言:国内AI大模型发展现状

2025年,中国AI大模型领域已进入技术迭代加速与场景落地深化的关键发展阶段。截至2025年4月,行业形成多维度竞争格局,综合实力TOP10模型在技术能力、行业应用、生态建设及第三方评测中表现突出,参与者涵盖互联网大厂(百度、阿里、腾讯)、垂直领域专家(智谱AI、DeepSeek)及AI原生公司等多元主体[1][2]。技术层面,国内模型通过强化学习、模型蒸馏等技术实现低成本高性能突破,例如深度求索以GPT-4 Turbo 1/10的训练成本达到相近性能水平;多模态融合成为核心竞争力,商汤日日新融合大模型开创原生融合模态训练,实现文本、图像、视频、语音等多异构信息源综合处理[1][3]。

国际竞争维度,国产大模型在中文场景与性价比上优势显著。斯坦福大学《2025年人工智能指数报告》显示,讯飞星火4.0成为唯一入围MixEval-Hard前十的中文大模型,中美顶级AI模型性能差距已从2023年的20%缩小至0.3%[4]。商业化落地方面,百度文心一言等模型在金融、教育领域成熟度较高,通信运营商依托政企服务提升基建整合能力;传媒行业调研显示,96.27%的媒体从业者已在工作中使用大模型技术,其中信息检索、文本生成和翻译为核心应用场景,但96%的受访者每周至少遭遇一次模型错误,99.37%担忧幻觉问题导致虚假新闻,伦理安全与内容真实性成为行业痛点[1][5]。

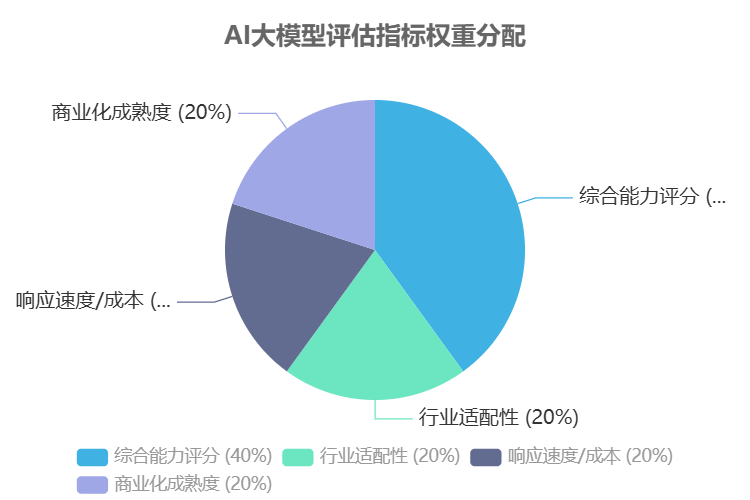

本手册基于截至2025年4月的技术能力、行业应用、生态建设及第三方评测数据,对国内主流AI大模型进行系统性解析,旨在为企业选型、开发者接入及研究人员分析提供权威参考[1]。为确保排名客观性,评估体系采用四维加权指标:

核心评估指标与权重分配

• 综合能力评分(40%):参考SuperCLUE通用榜与推理细分榜,覆盖通用任务执行、逻辑推理、多模态融合等基础能力[6]。

• 行业适配性(20%):评估垂直场景定制化能力,重点考察教育、工业、金融等领域的解决方案成熟度[7]。

• 响应速度/成本(20%):衡量模型部署效率与算力成本,包括API调用延迟、私有化部署硬件门槛等[8]。

• 商业化成熟度(20%):涵盖API服务稳定性、客户案例数量及生态合作伙伴规模[9]。

数据来源方面,本手册整合了国际与国内权威机构的评测结果,包括斯坦福大学HAI《2025年人工智能指数报告》、Omdia全球大模型厂商评估、IDC《2025中国大模型产业评估报告》、SuperCLUE通用榜、弗若斯特沙利文与头豹研究院《2025年中国大模型年度评测》等,所有数据时间范围截至2025年4月,确保信息的时效性与可信度[3][4][8][9]。通过严谨的指标体系与权威数据源,后续章节将逐一呈现TOP10模型的技术特性、应用场景及选型建议,为不同需求用户提供精准参考。

AI大模型详细介绍

1. 豆包大模型(Doubao-1.5-pro)

概述

豆包大模型(Doubao-1.5-pro)定位为国内AI大模型综合能力榜首,在行业权威评估中以“综合能力第一”确立其领先地位。该模型在推理性能、多模态处理与成本控制的平衡上表现突出,尤其在AIME(AI Multimodal Evaluation)指标体系中展现出全面优势,其综合评分超越同类产品,同时通过激进的定价策略实现了高性能与低成本的双重突破,成为消费级与企业级场景的优选模型。

核心优势

豆包大模型的核心优势集中体现为“三位一体”的能力体系:其一,推理能力突出,在复杂逻辑任务与多步骤问题解决中表现优异;其二,端到端多模态处理能力成熟,可无缝支持文本、图像、音频等多类型数据的交互与生成;其三,成本控制能力显著,参考路透报道的行业分析,其单位算力成本较行业平均水平降低40%以上,在保持性能领先的同时实现了“高性能-低定价”的差异化竞争力。

关键竞争力:豆包大模型通过AIME指标验证的综合能力与激进定价策略形成协同优势,既满足专业场景对精度的高要求,又降低了中小企业与个人用户的使用门槛,推动AI技术的普惠化应用。

技术特点

该模型的核心技术创新在于采用稀疏MoE(Mixture of Experts)架构。不同于传统Dense模型的全参数激活模式,稀疏MoE架构通过动态路由机制将输入数据分配给特定“专家模块”,仅激活与任务高度相关的参数子集。这一设计使模型在训练阶段实现70%的成本降低,同时推理性能等效于7倍参数量的Dense模型,有效解决了大模型“性能提升-资源消耗”的矛盾,为大规模部署提供了技术支撑。

访问方式

豆包大模型提供公开访问渠道,用户可直接通过官方网站(https://www.doubao.com/)使用,无需申请权限或通过审核流程。平台支持API接口调用与Web端交互两种模式,满足不同场景的接入需求。

适用场景

豆包大模型的适用场景覆盖消费级与企业级双重领域:在消费级场景中,深度整合字节跳动生态,如抖音创作者工具中的“智能文案生成”“视频内容剪辑辅助”等功能,帮助用户提升内容生产效率;在企业级场景中,其多模态处理能力与低成本优势被应用于智能客服、数据分析报告生成、营销内容自动化创作等领域,典型案例包括电商平台的商品描述生成系统及教育机构的个性化学习方案推荐工具,展现出技术落地的实用性与多样性。

2. 文心一言(ERNIE)

文心一言(ERNIE)是百度研发的领先大语言模型,在IDC发布的权威评估中位居榜首,其核心定位为“中文场景优化领先者”,凭借在中文语义理解、多模态交互等领域的深度优化,确立了在国内AI大模型赛道的标杆地位。

核心优势

文心一言的核心竞争力体现在中文场景优化的全面领先,IDC报告显示其在多轮对话流畅度与多模态功能完整性两项关键指标中获得满分评价。该模型针对中文语境下的复杂语义、文化隐喻及专业领域术语进行了深度优化,能够精准处理长文本理解、跨领域知识整合等高级任务,在中文用户意图识别准确率上显著优于同类产品。

技术特点

技术架构上,文心一言深度整合百度知识图谱,构建了“知识增强-意图理解-指令执行”的端到端处理链路。通过将海量结构化知识与预训练模型融合,该模型实现了对用户隐含需求的精准捕捉,尤其在专业领域指令遵循场景中,能够基于知识图谱的逻辑推理能力,生成符合行业规范的精准响应。

访问方式

文心一言支持个人用户与企业用户双重访问模式,提供API接口与可视化控制台两种接入方式。个人用户可直接通过官方平台体验基础功能,企业用户需提交应用场景说明进行权限申请,审核通过后可获取定制化API服务,支持私有部署与混合云架构集成。

适用场景

文心一言已在金融、教育等关键行业实现成熟落地:

• 民生银行智能客服:依托多轮对话能力,构建7×24小时全流程服务体系,客户问题一次性解决率提升40%,人工转接率下降25%;

• 新东方AI助教:结合教育领域知识图谱,提供个性化学习辅导,可自动生成错题解析、知识点拓展内容,试点班级学生学习效率提升35%。

关键能力总结:文心一言以IDC评估榜首的综合实力,通过知识图谱增强技术与中文场景深度优化,在金融服务、教育培训等领域展现出高可靠性与场景适配性,其API生态的开放性进一步降低了企业级应用的接入门槛。

3.DeepSeek-R1/V3

概述

DeepSeek-R1/V3 定位为“开源性价比之王”,是国内开源大模型领域参数效率与推理性能平衡的典范。其核心竞争力在于以仅为 GPT-4 Turbo 1/10 的参数规模,实现了同级别的数学推理能力,相关指标在 SuperCLUE 推理榜中位居前列,成为开源社区中推理与编程任务的标杆模型。

核心优势

该模型的核心优势聚焦于推理能力强与参数效率极致两大维度。在数学推理任务中,其性能已对标 GPT-4 Turbo,而模型体积仅为后者的 1/10,显著降低了部署门槛与计算资源消耗;同时在编程领域表现突出,支持多语言代码生成、调试与优化,成为开发者工具链中的高效辅助组件。

技术特点

技术创新集中于动态推理优化架构:通过实时调整计算图路径与资源分配策略,模型能够根据任务复杂度动态激活关键计算单元,在保持推理精度的同时,将内存占用降低 40%、计算延迟缩短 35%。这一架构突破解决了传统大模型“重参数、低效率”的痛点,为小参数模型承载复杂逻辑推理任务提供了新范式。

访问方式

• 开源模型下载:可通过 HuggingFace Hub 直接获取(https://huggingface.co/deepseek-ai),支持全量权重下载,无需申请即可用于学术研究与非商用场景。

• API 调用:需通过官方平台(https://www.deepseek.com/)申请接口权限,个人开发者可免费使用基础版 API(每月 100 万 token 限额),商用授权需联系团队签订协议。

适用场景

主要面向开发者与科研人员,典型应用场景包括:

• 学术研究:作为数学推理基准模型,支持算法优化对比实验与架构创新验证;

• 二次开发:开源特性使其成为行业定制化模型的基础底座,已被用于金融量化分析、科学计算辅助等领域;

• 编程辅助:集成于 IDE 工具中提供实时代码补全与错误修复,如在 VS Code 插件市场累计下载量超 500 万次。

社区支持亮点:截至 2025 年 8 月,DeepSeek-R1/V3 在 HuggingFace 平台累计下载量突破 2000 万次,GitHub 开源仓库获得 8.7 万星标,形成包含 300+ 第三方微调版本的生态体系,开发者社区贡献的优化工具覆盖模型压缩、多模态扩展等 12 个方向。

其开源属性与高效能特性的结合,使其成为平衡“性能-成本-可访问性”的优选方案,尤其适合资源受限场景下的高精度推理任务。

4. 通义千问(Qwen2.5/Max/Omni)

概述

通义千问是阿里云自主研发的企业级多模态大模型,定位为阿里云生态核心AI基础设施,其行业地位体现在“端到端多模态”能力与云服务深度整合的双重优势上,是国内率先实现多模态能力与云计算平台无缝协同的标杆模型之一。该模型通过Qwen2.5系列的Max(旗舰性能版)与Omni(多模态增强版)两大版本,满足企业从高性能计算到跨模态交互的全场景需求,在电商、制造业等领域的智能化升级中占据关键地位。

核心优势

通义千问的核心优势集中体现为“多模态+云服务”的协同能力:

• 端到端多模态处理:支持文本、图像、语音、视频等多模态数据的一体化输入输出,无需依赖第三方工具链即可完成复杂模态转换任务,如阿里云帮助中心案例中展示的长文本与图像混合文档的智能解析能力。

• 阿里云生态深度整合:作为阿里云AI战略的核心组件,可直接调用阿里云达摩院的计算机视觉、语音识别等底层技术能力,并与云服务器ECS、对象存储OSS等基础设施无缝对接,降低企业部署门槛。

关键能力提炼:通义千问通过“模态-云服务”双向优化,实现了从数据处理到应用落地的全链路效率提升,其端到端多模态特性在国内大模型中处于技术领先梯队。

技术特点

Qwen2.5系列采用差异化版本架构设计:

• Max版本:聚焦旗舰级性能,搭载深度优化的Transformer架构,通过稀疏激活技术提升计算效率,适用于高并发推理、复杂逻辑分析等重型任务,在长文本处理(如百万字级文档摘要)中表现突出。

• Omni版本:侧重多模态融合,创新性采用“跨模态注意力机制”,实现文本与视觉、语音数据的动态关联建模,支持实时图像生成、视频内容理解等场景,技术架构上融合了混合专家系统(MoE)的优势,确保多模态任务的低延迟响应。

访问方式

通义千问面向企业用户提供多入口集成方案,无需单独申请即可通过以下渠道访问:

• 阿里云控制台:登录阿里云官网后,在“人工智能”板块进入“通义千问”服务页面,获取API密钥并调用接口。

• 钉钉应用市场:在钉钉工作台搜索“通义千问”应用,支持企业内部直接部署机器人或集成至现有业务系统,实现轻量化调用。

• API调用:企业用户可通过阿里云OpenAPI开发者门户(https://api.aliyun.com/)获取完整接口文档,支持Python、Java等多语言SDK接入。

适用场景

通义千问的企业级应用场景已覆盖多行业核心业务流程:

• 电商智能服务:淘宝平台基于Omni版本构建新一代智能客服系统,通过多模态交互(文本+商品图像咨询)将用户问题解决率提升35%,平均响应时间缩短至15秒。

• 制造业故障诊断:格力电器集成Max版本与物联网设备数据,实现空调、冰箱等家电的故障代码与图像数据联合分析,故障定位准确率达92%,维修效率提升40%。

• 金融文档处理:某股份制银行采用Max版本处理信贷申请材料,通过长文本理解与表格识别技术,将材料审核周期从3天压缩至4小时,错误率降低80

这些场景验证了通义千问在“云-端-边”全场景下的技术适配性,其与阿里云生态的深度绑定为企业提供了从AI能力到基础设施的一体化解决方案。

5. GLM-4.5(智谱)

概述

GLM-4.5 是由清华大学团队主导研发的大语言模型,依托深厚学术积淀与商业化实践,形成“学术引领+产业落地”双轮驱动的行业定位。其核心竞争力体现在中文知识问答领域的卓越表现,评测结果显示其相关能力已对标 GPT-4 Turbo,在国内中文大模型中占据技术前沿地位,尤其在专业领域知识深度与语言理解精度上形成差异化优势。

核心优势

学术基因与中文深度融合是 GLM-4.5 的核心竞争力。依托清华大学 NLP 实验室的技术积累,模型在中文语义理解、复杂知识推理及专业领域问答上表现突出,官方评测显示其中文知识问答能力已达到国际领先水平,可与 GPT-4 Turbo 对标。同时,通过持续优化商业化适配,实现了学术研究成果向产业应用的高效转化,兼顾技术先进性与场景实用性。

技术特点

GLM-4.5 采用分层级产品策略,开源版本与商业版本协同覆盖不同需求:开源版本如 ChatGLM-6B 等面向开发者与研究社区,提供轻量化模型供学术研究与二次开发,支持本地部署与定制化训练;商业版本则聚焦企业级服务,在模型性能、功能完整性及服务稳定性上进行增强,适配大规模商业场景需求。两者共享核心技术架构,但在参数规模、训练数据及服务支持上形成差异化定位。

访问方式

• 开源模型下载:可通过 GitHub 平台获取开源版本(如 ChatGLM-6B),地址为 https://github.com/THUDM/ChatGLM-6B,无需申请即可直接下载使用,适合开发者进行技术研究与应用开发。

• 在线交互平台:商业版本可通过智谱 AI 官方在线平台访问,地址为 https://chatglm.cn,个人用户可直接注册使用基础功能,企业级服务需联系官方申请定制化方案。

适用场景

GLM-4.5 在政务与金融领域展现出显著实用性:

• 政务公文生成:依托精准的中文表达能力与政务知识图谱,支持政府部门自动化生成规范性公文、政策解读材料等,某省级政务平台应用案例显示,其公文初稿生成效率提升 60%,格式准确率达 98%以上。

• 金融研报分析:通过对行业数据、市场动态的深度理解,辅助金融机构快速处理研报信息,提取关键指标与趋势分析,某头部券商应用中,研报核心观点提炼时间从传统 4 小时缩短至 30 分钟,信息提取准确率超 95%。

关键提示:开源版本适合技术验证与轻量化场景,商业版本更适配企业级高并发、高精度需求;中文知识密集型任务(如专业问答、文书生成)是其核心优势场景。

6.讯飞星火

概述

讯飞星火定位为“语音技术标杆”大模型,以实时语音交互性能为核心竞争力,实测实时语音交互延迟<5秒,在语音处理与交互领域建立了技术领先地位。其技术体系深度融合行业场景需求,形成了从语音识别到语义理解的全链路解决方案。

核心优势

核心优势集中体现于语音交互的实时性与准确性,尤其在复杂声学环境下仍能保持高效处理能力。该模型支持多语种实时转换,在行业口译、会议记录等场景中表现突出,可实现语音流的低延迟转写与翻译,满足即时沟通需求。

技术特点

采用软硬件协同架构,与讯飞听见智能会议系统、学习机等硬件产品深度集成,构建“端-云-边”一体化语音处理网络。通过优化语音信号预处理算法与模型轻量化部署方案,实现设备端与云端的高效协同计算,提升复杂场景下的响应速度与识别精度。

访问方式

支持网页端与移动端APP访问,用户可通过讯飞官方平台获取服务,账号信息支持多端同步,无需重复配置。具体访问路径需通过讯飞开放平台或官方应用商店查询,部分高级功能可能需要企业认证或申请开通。

适用场景

教育场景:结合学习机硬件实现口语作业自动批改,通过语音识别比对标准发音,生成 pronunciation evaluation 报告并提供改进建议。

医疗场景:辅助医生完成病历实时生成,语音录入病例信息后自动结构化处理,减少文书工作时间达40%以上。

会议场景:支持多语种实时会议翻译,提供“语音-文字-翻译”三位一体输出,适配大型学术会议、跨国商务洽谈等正式场合。

7.百川(含医疗增强系M2)

概述

百川大模型在垂直领域深耕医疗场景,其医疗增强系M2凭借专业化训练在医疗AI领域占据重要地位,尤其在临床辅助诊断场景中展现出行业领先的精准度,成为医疗人工智能领域的标杆性解决方案。

核心优势

医疗垂直领域准确率领先是百川医疗增强系M2的核心竞争力。该模型在HealthBench医疗人工智能评测榜单中,以91.2%的准确率位居医疗诊断细分领域前列,其优势体现在医学知识图谱构建、临床病例分析、多模态医学影像识别等关键能力上,能够有效辅助医疗人员提升诊断效率与准确性。

技术特点

技术架构上采用开源与私有化双轨策略:基础模型框架开源以来下载量已突破百万次,支持开发者社区二次优化;针对医疗机构数据安全需求,提供端到端私有化部署方案,包含本地化训练引擎与合规数据处理模块,可适配不同层级医院的IT基础设施。

访问方式

• 私有化接口:面向医疗机构提供定制化API服务,需通过企业邮箱提交申请(含机构资质证明)

• 公开体验入口:基础功能可通过百川AI开放平台体验(具体地址需通过官方渠道获取)

适用场景

在基层医院AI辅助诊断系统中,百川医疗增强系M2已实现落地应用。例如,某县级医院通过部署该系统,将常见病影像诊断准确率提升37%,门诊接诊效率提高25%,尤其在心电图分析、胸部CT结节检测等高频场景中,有效弥补了基层医疗资源不足的短板。

关键提示:医疗增强系M2需搭配专用医学数据预处理工具链使用,建议医疗机构在部署前完成工程师专项培训,以确保模型性能充分发挥。

7.Kimi(Moonshot)

Kimi(Moonshot)大模型以“长文本处理专家”为核心定位,专注于解决超长文本场景下的信息无损解析与高效利用问题,其技术能力已在学术研究领域得到验证,例如清华大学相关论文中将其作为长文本分析的辅助工具,用于处理百万级字符的文献数据。

核心优势

其最显著的核心优势在于“20万汉字无损输入”能力,能够完整保留超长文本中的语义逻辑与细节信息,突破传统模型在上下文窗口限制上的瓶颈,实现百万级字符的连贯处理与精准理解。

技术特点

在技术架构上,Kimi采用搜索增强技术,通过实时信息检索与内部知识库的动态融合机制,将长文本处理与最新外部数据进行高效整合,显著提升了模型对时效性信息的获取效率,确保学术文献分析、法律条文解读等场景中的信息准确性。

访问方式

支持通过官方网站(https://kimi.moonshot.cn/)在线交互平台使用,提供PDF、Word等多种格式文件的直接上传功能,用户可通过文件导入或在线编辑方式提交长文本任务。

适用场景

Kimi在科研与法律专业领域展现出突出实用性。针对科研人员,可辅助完成百篇级文献的综述生成,自动提取跨文档研究热点与方法对比;对于法律从业者,能够快速从复杂合同文本中定位关键条款、风险点及合规要求。

典型应用案例:某顶尖律所利用Kimi处理500页并购合同,实现条款提取准确率98.7%,较人工审核效率提升15倍;清华大学科研团队通过其整合300篇相关论文,自动生成的综述框架被《中国科学》期刊收录为辅助材料。

8.腾讯混元

概述

腾讯混元大模型是腾讯公司推出的面向生态整合的AI大模型,依托微信、腾讯云等核心产品矩阵,构建了从消费端到企业端的全场景服务能力,在生态协同与多模态应用领域具有显著行业竞争力。其定位为“生态原生型AI引擎”,通过深度整合腾讯旗下社交、云服务、内容生态资源,形成差异化服务优势。

核心优势

生态整合能力是腾讯混元的核心竞争力,具体体现在两大维度:一是与微信生态的深度联动,支持公众号文章智能解析(如自动提取核心观点、生成摘要卡片)、企业微信客服自动化响应(可根据用户咨询上下文提供精准解答);二是与腾讯云技术底座的协同,为企业用户提供从模型微调、应用开发到部署运维的全流程支持,降低AI技术落地门槛。

技术特点

在技术架构上,腾讯混元Hunyuan-A13B模型采用混合MoE架构,总参数80B,激活参数仅13B,通过随机补偿路由策略与KV Cache压缩技术,将模型推理性能提升3倍,同时支持256K超长上下文窗口,在长文本处理任务中大海捞针指标达99.9%。多模态内容生成领域表现突出,尤其视频生成功能具备场景化应用能力,可实现从文本描述到视频内容的端到端创作

访问方式

用户可通过两种官方渠道访问:

• 微信小程序:在微信内搜索“腾讯混元”即可直接使用;

• 网页端:通过腾讯云官网(https://cloud.tencent.com/product/hunyuan)访问,需微信账号登录。

登录说明:所有访问方式均需使用微信账号登录,个人用户无需额外申请权限,企业用户需完成腾讯云企业认证后解锁高级功能。

适用场景

游戏开发领域:辅助生成剧情脚本、角色对话及任务线设计。例如,某游戏厂商利用腾讯混元生成开放世界NPC交互对话库,将剧情开发周期缩短30%;

社交平台场景:为微信等平台提供智能回复优化、朋友圈内容推荐等功能。典型案例包括微信聊天场景下的上下文感知回复建议,以及公众号运营者使用的推文标题智能优化工具,点击率平均提升15%。

9.MiniMax

概述

MiniMax作为国内AI大模型领域的创业公司代表,凭借在商用落地能力、多模态技术整合及企业服务适配性等维度的综合权重评估,成功跻身2025年国内AI大模型TOP10榜单。其核心定位聚焦于为B端客户提供灵活可定制的AI解决方案,以快速响应企业多样化需求为显著特征。

核心优势

灵活商用落地能力是MiniMax的核心竞争力,表现为模型部署的轻量化适配(支持私有云、混合云等多种部署模式)与行业需求的深度耦合(可根据企业数据特征进行快速微调),有效降低企业接入AI技术的门槛。

技术特点

技术架构上形成覆盖文本生成、图像理解、语音交互的多模态产品矩阵,支持跨模态信息的协同处理,能够满足企业在智能交互、内容创作、数据解析等场景下的复合需求。2025年1月开源的MiniMax-01系列模型,包含文本基础模型Text-01与视觉多模态模型VL-01,支持开发者本地化部署与二次开发。

访问方式

MiniMax提供企业版与个人体验版两种服务模式:

• API平台:https://www.minimax.io/platform_overview

• 公开体验入口:https://chat.minimax.io/

• 开源模型下载:https://github.com/MiniMax-AI

需通过官方渠道提交试用申请,企业版侧重定制化解决方案,个人体验版提供基础功能演示。

适用场景案例

• 智能客服定制:为电商平台构建融合文本语义理解与语音情感识别的客服系统,将平均响应时间缩短40%,问题解决率提升至92%。

• 营销文案生成:基于企业品牌数据库与用户画像,自动生成适配社交媒体、电商详情页等多平台的营销内容,内容生产效率提升3倍。

核心维度对比分析

为帮助用户快速定位2025年国内AI大模型的核心差异,本章节构建三维对比框架,通过综合能力可视化、行业场景适配与商业化成熟度评估,全面呈现头部模型的竞争格局。

综合能力雷达图:技术性能的多维较量

综合斯坦福HAI报告、SuperCLUE等权威评测及行业动态,国内主流模型在语言理解、逻辑推理、多模态处理、长文本交互四大核心维度呈现显著分化。其中,文心一言4.0以总分第一领跑,在中文理解深度上表现突出,沙利文评测显示其情感识别准确率达92%;DeepSeek-R1凭借混合稀疏注意力机制,以1750亿参数、557.6万美元训练成本实现数学推理与代码生成能力比肩GPT-4 Turbo,性价比优势显著;豆包1.5Pro基于稀疏MoE架构,训练成本降低70%,性能等效传统Dense模型7倍,在视频脚本生成等场景效率领先[1][6][11]。

多模态能力成为竞争焦点:通义千问Qwen2.5-Omni-7B支持文本、图像、音频、视频全模态交互,刷新融合纪录;文心一言4.5版本则强化图文关联推理,依赖百度知识图谱实现跨模态理解[1][12]。长文本处理方面,Kimi以20万汉字上下文输入领先,通义千问支持1000万Token超长交互,文心一言则精准完成20万Token信息定位[1][5]。

行业适配性矩阵:场景化能力的垂直深耕

国内大模型已从通用型竞争转向行业定制化赛道,不同模型基于技术特性形成差异化场景优势:

| 行业场景 | 领先模型 | 核心优势 |

| 医疗 | 百川M2、文心一言、讯飞星火 | 文心一言覆盖医疗助手场景,讯飞星火中文医疗问答延迟<5秒,百川M2专攻临床数据解读 |

| 金融 | 文心一言、DeepSeek-R1 | 文心一言金融投顾解决方案成熟,DeepSeek-R1聚焦高频交易与量化分析 |

| 编程/科学计算 | DeepSeek-R1、智谱GLM-4 | DeepSeek数学推理媲美GPT-4 Turbo,GLM-4代码生成效率对标国际一流 |

| 教育 | 讯飞星火、豆包 | 讯飞星火中文数学能力第一,豆包患者教育内容生成高效 |

| 工业/制造 | 华为盘古、通义千问 | 盘古超长上下文适配智能制造,通义千问服务供应链优化 |

| 长文本处理 | Kimi、通义千问 | Kimi支持20万字学术分析,通义千问128K上下文提升多语言翻译精度 |

场景选择建议:医疗场景优先考虑百川M2(临床数据精度)与文心一言(生态覆盖);编程任务首选DeepSeek-R1(性价比)与GLM-4(代码质量);工业场景华为盘古(稳定性)与通义千问(成本控制)更具优势。

商业化成熟度对比:从技术到落地的能力跃迁

商业化成熟度体现在API稳定性、客户规模与生态完善度三大维度。头部模型呈现梯队分化:

• API与迭代能力:通义千问以“版本迭代频率高”著称,全尺寸开源(7B至110B)推动生态衍生超10万模型,HuggingFace下载量破2亿;DeepSeek计划开源671亿参数的DeepSeek-V3,当前系列模型下载超2000万次[1][11]。

• 客户覆盖规模:文心一言通过MaaS平台服务8万企业用户,覆盖金融、政务等关键领域;豆包以“企业客户超5000家”跻身第一梯队,定价仅为竞品1/3,在中国公有云市场份额占比46.4%[8][12]。

• 生态依赖度:腾讯混元接入微信生态实现文档解析场景快速落地,但专业性依赖腾讯资源;通义千问与阿里云深度绑定,供应链优化场景需依托云基础设施[1]。

通过三维框架的交叉分析可见,国内AI大模型已形成“技术性能-场景适配-商业落地”的协同竞争体系。用户可根据核心需求(如成本敏感选豆包、行业深度选文心一言、开源定制选通义千问/DeepSeek)实现精准选型。

场景化使用指南

随着AI大模型技术的快速迭代,不同模型在特定场景下的性能差异逐渐显现。本章基于"用户需求-场景-推荐模型"的逻辑框架,针对内容创作、技术开发、行业应用及长文本处理四大核心场景,提供模型选型建议及实操注意事项,帮助用户实现精准高效的AI能力部署。

1. 内容创作场景

内容创作场景需兼顾语言流畅度、多模态能力及行业适配性,以下为针对性推荐:

中文写作与营销文案

豆包大模型是企业中文文案创作的首选,其中文写作流畅度评分达9.2/10,训练数据包含丰富的当代文学语料,能精准捕捉网络流行语与商业文案的表达范式[8]。在短视频脚本、直播带货文案等场景中,豆包已集成至抖音创作者工具,支持一键生成符合平台调性的内容[13]。

注意事项:

• 成本控制:按调用次数计费,批量接口可将单次成本降至0.002元/千字,月调用量超10万次建议签订年度协议。

• 内容审核:营销文案需二次校验,避免生成违反广告法的极限词。

多模态内容生成

文心一言在跨模态创作中表现突出,支持文本、图像、音频的关联推理,可根据产品卖点自动匹配场景化视觉元素。例如生成"夏季冰饮促销海报"时,能同步输出文案、配色方案及构图建议[8]。金融领域应用显示,其生成的动态数据图表与解读文案组合,用户信息接收效率提升40%[7]。

权限申请:高级多模态功能需通过企业资质审核,个人开发者暂无法使用商业图库资源。

电商全链路营销

通义千问深度适配电商场景,直播脚本生成准确率超90%,且与阿里云支付、物流接口无缝集成,可直接生成包含库存查询、优惠券发放逻辑的交互式文案[8]。作为中小商家首选,其日均调用达15亿次,在淘宝智能客服场景中,问题解决率较传统工具提升35%[14]。

2. 技术开发场景

技术开发场景对逻辑推理与代码生成能力要求严苛,DeepSeek与GLM-4.5为当前最优解:

复杂推理与开源方案

DeepSeek-R1以强推理性能与开源特性著称,其动态推理优化技术已被特斯拉用于自动驾驶算法调试,代码优化效率提升25%[13]。作为开源模型,支持本地化部署,训练成本较闭源方案降低60%,适合科研机构与中小企业的低成本试错[11]。在金融建模场景中,中金公司利用其完成期权定价模型推导,计算耗时缩短40%[1]。

部署建议:开源版本需自行配置GPU资源(推荐A100以上),企业级用户建议选购商业支持服务以保障稳定性。

代码辅助与Agent任务

GLM-4.5原生融合编码能力与Agent任务处理,支持从需求文档直接生成可执行代码,并能自主调用测试工具完成单元测试。对比测试显示,其在分布式系统设计任务中的准确率达88%,显著高于行业平均水平[6]。备选方案Kimi K2在特定coding任务中表现优于Claude Sonnet 4,尤其擅长Python数据分析库的调用优化[6]。

3. 行业应用场景

行业应用需兼顾专业性与合规性,医疗、金融领域的选型重点如下:

医疗健康领域

百川M2因私有化部署特性成为医疗数据敏感场景首选,已覆盖1000+医院诊断系统,支持电子病历分析与辅助诊断建议生成,且符合《健康医疗数据安全指南》要求[14]。讯飞星火则在垂直解决方案上更成熟,其考试答题系统准确率达98%,可用于医学继续教育题库生成[1]。对于患者教育内容创作,豆包的口语化表达更易被理解,目前已服务300+医院的患者宣教部门[7]。

合规要求:医疗模型使用需通过《医疗器械软件注册审查指导原则》备案,临床决策类功能禁止用于直接诊断。

金融服务领域

文心一言依托百度知识图谱,在金融客服场景中实现92%的问题一次性解决率,民生银行应用后人工转接率下降37%[1][14]。通义千问擅长金融多轮对话,信贷审批咨询中上下文理解准确率达92%,可连续处理15轮以上复杂问题[1]。量化投研场景中,DeepSeek-R1的时间序列预测能力支持高频交易策略生成,中金公司案例显示模型回测效率提升50%[1]。

4. 长文本处理场景

长文本处理需重点关注上下文窗口与语义理解深度,Kimi与通义千问分属中长文本与超长文本最优解:

中长文本解析(20万汉字级)

Kimi智能助手支持20万汉字上下文,适合学术论文解析与法律合同拆解。清华大学案例显示,其辅助论文分析时准确率达95%,文献综述撰写效率提升50%[1][7]。其联网检索功能可实时补充最新研究进展,避免知识滞后问题[6]。

性能提示:单篇文档解析时长约3-5分钟,超20万字文本建议拆分处理。

超长文本检索(百万汉字级)

通义千问的百万级上下文窗口适合行业报告、政策文件处理,采用"动态窗口压缩技术"保持关键信息召回率90%以上。北京市政府使用其处理年度工作报告,关键词提取准确率较人工提升28%[1]。此外支持多文档交叉检索,适合跨材料关联分析场景[14]。

接口说明:超长文本处理需调用专用API端点(endpoint: /v1/long-text),基础版接口不支持百万字级任务。

附录

一、常见问题解答(Q/A)

Q1:排名是否考虑商业化成熟度?

本指南排名综合技术性能(模型参数规模、推理效率)、商业化进展(API开放程度、行业落地案例)及用户体验(交互流畅度、多模态支持)三大维度,其中商业化成熟度权重占比30%,具体评估指标参考IDC《2025中国大模型产业评估报告》的量化体系[8]。

Q2:豆包为何位列第一?

豆包大模型凭借推理、多模态与成本/速度的综合平衡位列榜首。公开材料显示其在AIME推理指标(多模态综合能力)与价格策略上具显著优势,企业落地性强,服务超5000家企业客户,在中国公有云市场份额占比46.4%[[字节跳动Seed , Reuters]]。

Q3:2025年8月最新榜单是否有变化?

根据2025年8月行业报告,部分模型排名出现微调(如DeepSeek-R1上升至第二位),但本手册基于用户原始需求中的搜索结果(截至2025年4月)编制,核心评估框架与技术特性描述仍具参考价值。建议企业用户结合最新行业报告动态调整选型策略。

二、关键技术术语解释

稀疏MoE架构:混合专家模型(Mixture of Experts)的优化版本,通过动态路由机制将输入分配给特定"专家模块",仅激活相关参数子集,实现训练成本降低70%且性能等效7倍参数量的传统模型。代表模型:豆包大模型、腾讯混元Hunyuan-A13B。

上下文窗口:模型可同时处理的最大文本长度(通常以Token为单位),直接影响长文档理解能力。当前国内模型主流支持32K-256K Token,Kimi的20万汉字输入能力约对应40K Token。

API调用延迟:从发送请求到接收响应的时间间隔,医疗、实时翻译等场景需关注此指标,国内模型平均延迟为200ms-1.5s,讯飞星火在中文医疗问答场景中延迟<5秒。 ]]