BAGEL-7B-MoT论文速读:统一多模态预训练的新特性

《Emerging Properties in Unified Multimodal Pretraining》论文解读

一、引言

本文介绍了一个名为 BAGEL 的开源基础模型,它在统一多模态理解和生成方面表现出色。BAGEL 是一个仅解码器的统一模型,经过大规模交错文本、图像、视频和网络数据的预训练。与现有模型相比,BAGEL 在多模态生成和理解方面展现出了显著优势,尤其是在自由形式图像操作、未来帧预测、3D 操控和世界导航等复杂多模态推理任务上。

二、研究背景与动机

多模态理解和生成领域的研究热度不断攀升。许多研究项目展示了在统一架构下联合优化生成和理解基准测试的有希望的结果。然而,与 GPT-4o 和 Gemini 2.0 等专有系统相比,学术模型在统一多模态理解和生成方面存在巨大差距。本文认为,通过精心设计的多模态交错数据进行扩展是缩小这一差距的关键。

三、方法

数据协议

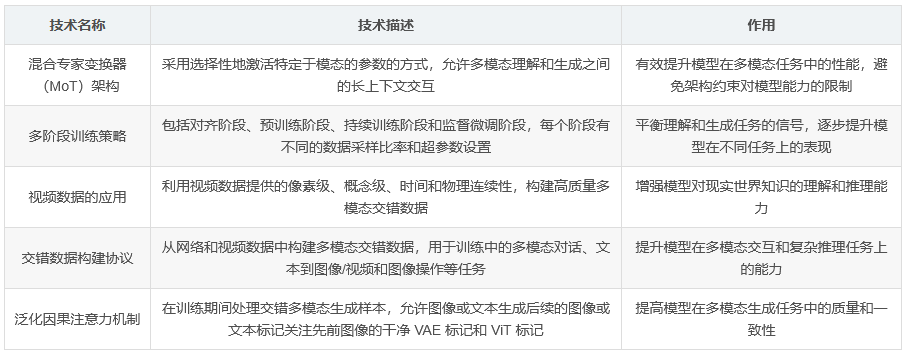

研究者们建立了一个新的数据源、过滤和构建高质量多模态交错数据的协议。除了网络来源外,还引入了视频数据,因为视频数据提供了像素级、概念级、时间和物理连续性,这对于大规模获取基于现实的知识至关重要。

模型架构

BAGEL 采用混合专家变换器(MoT)架构,该架构选择性地激活特定于模态的参数。与之前的方法不同,BAGEL 的设计允许多模态理解和生成之间的长上下文交互,通过共享自注意力操作实现。

训练策略

研究者们采用多阶段训练策略,包括对齐阶段、预训练阶段、持续训练阶段和监督微调阶段。每个阶段都有不同的数据采样比率和超参数设置,以平衡理解和生成任务的信号。

四、实验与结果

数据集

BAGEL 的训练数据包括文本数据、图像-文本配对理解数据、图像-文本配对生成数据、交错理解数据以及来自视频和网络的交错生成数据。这些数据集的多样性和规模使 BAGEL 能够执行多模态推理、上下文预测、物理动力学建模和未来帧预测等任务。

模型评估

研究者们使用多个基准测试对 BAGEL 进行了评估,包括多模态理解、文本到图像生成和图像编辑任务。结果显示,BAGEL 在多模态理解和生成的多个基准测试中均优于现有的开源统一模型。

新兴特性

随着预训练规模的扩大,BAGEL 展现出了一种清晰的新兴模式:基本的多模态理解和高质量生成首先收敛;接下来,复杂的编辑和自由形式视觉操作能力开始显现;最后,长上下文推理开始有益于多模态理解和生成。

五、结论

BAGEL 的提出展示了在统一预训练中扩展多模态交错数据的潜力。它在标准多模态理解和生成基准测试中均取得了顶级性能,并且在世界建模和推理能力方面表现突出。研究者们希望 BAGEL 的开源能够为多模态研究提供更多机会。

六、核心技术总结