【序列晋升】29 Spring Cloud Task 微服务架构下的轻量级任务调度框架

Spring Cloud Task作为微服务架构中的轻量级任务调度框架,为开发人员提供了一种构建短生命周期微服务任务的便捷方式。它允许开发者快速创建、执行和管理一次性任务或短期批处理作业,任务执行完成后自动关闭以释放系统资源,避免了传统长期运行微服务的资源浪费问题。本文将深入解析Spring Cloud Task的定义、背景、架构设计、核心组件、关键特性、使用方法以及在微服务场景下的实际应用,帮助技术开发人员更好地理解和应用这一框架。

一、什么是Spring Cloud Task?

Spring Cloud Task是一个轻量级框架,专为构建短生命周期微服务任务而设计。与传统长期运行的微服务不同,Spring Cloud Task应用启动后执行预定义的业务逻辑,完成后自动关闭,不会持续消耗系统资源。这种设计使得它特别适合处理一次性任务(如数据迁移)、短期批处理(如文件处理)以及定时任务(如订单状态检查、缓存清理)等场景。

在技术实现上,Spring Cloud Task基于Spring Boot构建,通过@EnableTask注解启用任务功能。它提供了一套完整的API和工具,用于管理任务的执行状态、参数传递和结果存储。框架会自动跟踪任务的执行情况,包括启动时间、结束时间、退出码等信息,并将这些元数据持久化到数据库中。这种轻量级、自包含的特性使得Spring Cloud Task成为微服务架构中处理短暂任务的理想选择。

二、诞生背景

Spring Cloud Task的诞生源于微服务架构的普及和发展。在单体应用时代,定时任务通常通过Quartz或Spring Task等框架实现,但在微服务架构下,传统任务调度方式面临诸多挑战:

首先,微服务架构的分布式特性使得任务调度变得复杂。传统定时任务难以保证在分布式环境中不重复执行,且缺乏有效的任务协调机制。其次,微服务应用通常长期运行,导致资源浪费。许多任务只需执行一次或短时间运行,却需要持续占用服务器资源。最后,微服务环境中的任务管理缺乏统一的视角。随着服务数量的增加,任务执行状态的跟踪和历史查询变得困难。

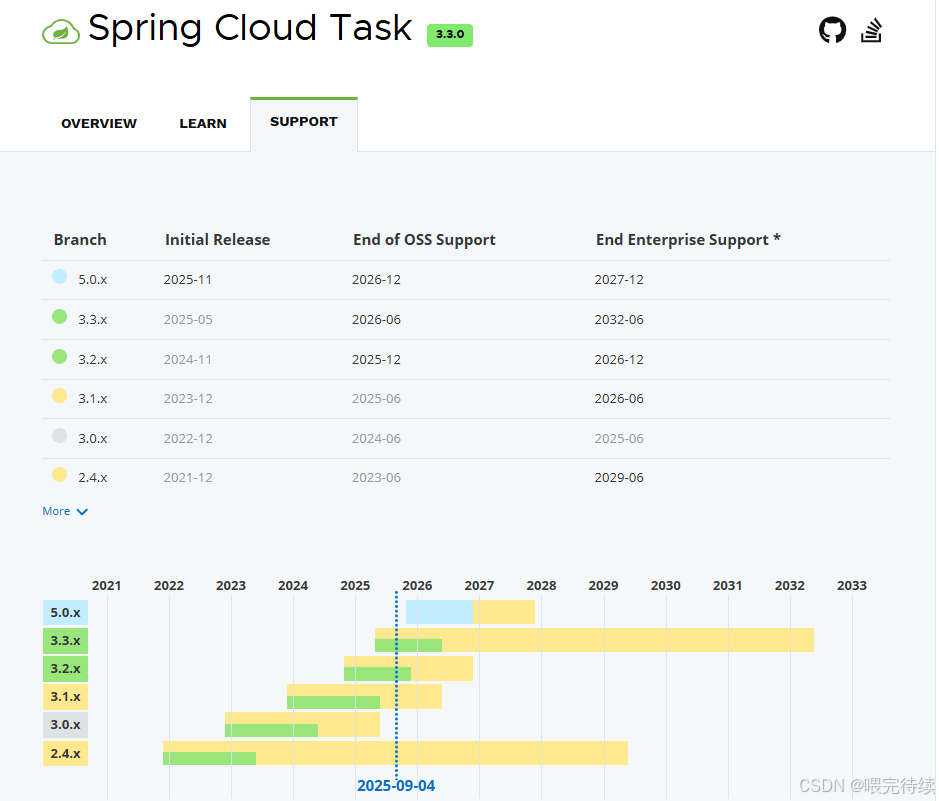

正是针对这些挑战,Spring Cloud Task于2016年随Spring Cloud 1.0版本一起推出,旨在简化微服务环境中的任务调度与管理。它作为Spring Cloud生态系统的一部分,填补了微服务架构中短暂任务管理的空白,为开发人员提供了一种更轻量、更灵活的任务执行方式。

三、架构设计

Spring Cloud Task采用分层架构设计,主要包括以下四个层次:

+-------------------+ +-------------------+ +-------------------+

| Coordinator |<----->| Database |<----->| TaskExecutor |

| (任务协调中心) | | (任务元数据存储) | | (任务执行器) |

+-------------------+ +-------------------+ +-------------------+| | || 1.任务触发 | ||------------------------->| || | 3.创建任务实例并存储状态 || |------------------------->|| | | 4.执行任务逻辑| | |------------------------->|| | | | 5.更新任务状态| | |<-------------------------|| 2.分配任务到Executor | ||------------------------->| || | |网关层:负责接收外部任务请求,如HTTP API或命令行触发,并将请求转发到任务调度中心 。在微服务环境中,这一层通常由Spring Cloud Gateway或Zuul实现,提供统一的入口和路由功能。

核心处理层:这是Spring Cloud Task的核心,包含任务生成器和任务调度中心 。任务生成器负责将外部请求解析为具体任务,并根据任务类型进行拆分(如单一任务、批量任务或组合任务) 。任务调度中心则负责管理任务状态,使用分布式锁机制从数据库获取待分配任务列表,并将任务分配到不同的服务模块 。

任务执行层:这一层由各个微服务模块组成,负责执行具体任务逻辑 。任务执行可以是简单的CommandLineRunner或复杂的Tasklet,也可以集成Spring Batch进行大规模批处理。执行完成后,各模块将结果反馈给任务调度中心,更新任务状态。

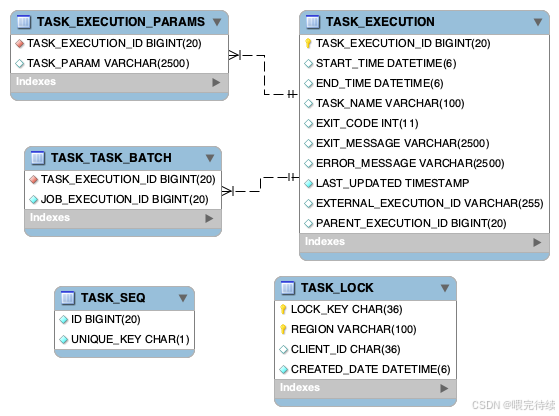

存储层:负责持久化任务元数据和执行信息 。Spring Cloud Task默认使用H2内存数据库,但在生产环境中通常配置为MySQL、PostgreSQL等关系型数据库 。存储层通过TaskRepository接口管理任务执行记录,确保任务状态的可靠存储。

在组件协作方面,Spring Cloud Task采用以下流程:任务请求从前端或第三方应用触发后,经过网关层转发到核心处理层,由任务生成器拆分任务并存储到数据库(TaskExecution记录);任务调度中心通过定时器和分布式锁获取待处理任务,分配至注册的服务模块;任务执行后,结果反馈至核心处理层,更新任务状态 。

四、解决的问题

Spring Cloud Task主要解决以下问题:

任务的高可用性:在分布式环境中,确保任务即使在节点故障时也能可靠执行,避免任务丢失或重复执行。通过任务元数据的持久化存储和分布式锁机制,Spring Cloud Task能够保证任务的正确执行和状态更新。

任务的分布式管理:在微服务架构中,任务可能需要在多个节点间分配执行,Spring Cloud Task通过任务调度中心和注册中心(如Eureka、Nacos)的配合,实现任务的动态分配和负载均衡 。

任务状态跟踪与历史查询:传统定时任务难以追踪执行历史和状态,Spring Cloud Task通过TaskExecution和TaskExplorer接口,提供完整的任务执行历史记录和状态查询能力 。

资源优化:短生命周期设计使得任务执行完毕后自动关闭,避免了资源浪费。这一特性在处理一次性或低频任务时尤为重要,可以显著降低系统资源占用。

任务依赖管理:对于有依赖关系的任务,Spring Cloud Task支持前置条件校验,确保任务按正确顺序执行 。例如,任务B的执行必须等待任务A完成,系统会自动处理这种依赖关系。

五、关键特性

Spring Cloud Task具备以下关键特性:

轻量级设计:基于Spring Boot构建,无需复杂配置即可快速开发短生命周期任务。与传统长期运行的微服务相比,它在任务执行完毕后自动关闭,节省系统资源。

任务元数据持久化:通过TaskRepository将任务执行信息(如任务名称、开始时间、结束时间、状态、参数等)持久化到数据库,支持后续的查询和分析。

任务状态管理:任务状态分为待分发(INIT)、执行中(PROGRESS)、已完成(SUCCESS)和失败(FAILURE)四种,提供完整的生命周期跟踪 。

任务分区(Task Partitioning):对于大型任务,Spring Cloud Task支持将其拆分为多个子任务并行执行,通过TaskSplitter和TaskProcessor实现分布式计算,提高执行效率 。

与Spring Cloud生态深度集成:与配置中心(Config)、服务发现(Eureka、Nacos)、API网关(Gateway)、负载均衡(Ribbon)等组件无缝协作,提供统一的微服务任务管理解决方案 。

命令行和HTTP API触发:支持通过命令行参数或HTTP API触发任务执行,提供灵活的任务启动方式。

自动关闭上下文:默认情况下,任务执行完毕后Spring Boot应用上下文会自动关闭,释放资源。可通过配置spring.cloud.task.closecontext_enabled=false禁用此特性,使应用持续运行。

六、与同类产品对比

在任务调度领域,Spring Cloud Task与Quartz、Spring Batch等产品有显著差异:

| 特性 | Spring Cloud Task | Quartz | Spring Batch |

|---|---|---|---|

| 适用场景 | 短生命周期任务、微服务环境 | 长期运行、复杂调度规则 | 大规模批处理作业 |

| 资源占用 | 任务执行完毕后自动关闭,资源占用低 | 长期运行,资源占用较高 | 资源占用较高,适合批量处理 |

| 分布式支持 | 原生支持分布式环境,避免重复执行 | 需额外配置集群,容易重复执行 | 需结合其他框架实现分布式 |

| 微服务集成 | 与Spring Cloud生态无缝集成 | 需自行处理微服务环境下的协调 | 专注于批处理,与微服务集成度高 |

| 任务持久化 | 自动记录任务执行元数据 | 需自行实现任务状态跟踪 | 提供完善的作业元数据管理 |

与Quartz相比,Spring Cloud Task更适合微服务架构下的任务调度,它解决了Quartz在分布式环境中容易重复执行的问题,并与Spring Cloud生态深度集成,简化了配置和管理。与Spring Batch相比,Task更专注于任务调度和执行,而Batch则专注于大规模批处理作业的实现。两者可以结合使用,发挥各自优势。

七、使用方法

1. 基础配置

首先,创建一个Spring Boot项目,并添加Spring Cloud Task依赖:

<dependency><groupId>org.springframework.cloud</groupId><artifactId>spring-cloud-starter-task</artifactId><version>3.0.4</version>

</dependency>在application.properties中配置数据源和任务参数 :

# 数据源配置(使用MySQL)

spring.datasource.url=jdbc:mysql://localhost:3306/task_db

spring.datasource.username=root

spring.datasource.password=123456

spring.datasource.driver-class-name=com.mysql.cj.jdbc.Driver# Task配置

spring.cloud.task.name=myTask

spring.cloud.task.initialize.enable=true

spring.cloud.task.tablePrefix=TASK_2. 定义任务逻辑

使用CommandLineRunner或Tasklet定义任务逻辑:

@SpringBootApplication

@EnableTask

public class MyTaskApplication {public static void main(String[] args) {SpringApplication.run(MyTaskApplication.class, args);}@Beanpublic CommandLineRunner commandLineRunner() {return args -> {System.out.println("任务开始执行...");// 任务逻辑Thread.sleep(5000);System.out.println("任务执行完成");// 应用自动关闭};}}或使用Tasklet实现更复杂的任务逻辑:

@Component

public class MyTasklet implements Tasklet {@Overridepublic RepeatStatus execute(StepContribution contribution, ChunkContext chunkContext) throws Exception {System.out.println("执行任务let逻辑...");// 获取任务参数Map<String, Object> arguments = chunkContext.getStepContext().getJobParameters().getParameters();String param = (String) arguments.get("myParam");System.out.println("参数值:" + param);// 处理任务return RepeatStatus.FINISHED;}}3. 任务执行与监控

启动应用后,任务将自动执行:

java -jar my-task.jar --spring.cloud.task.name=myTask或通过HTTP API触发任务执行:

curl -X POST "http://localhost:8080/actuator/task"任务执行状态可通过TaskExplorer接口查询 :

@Autowired

private TaskExplorer taskExplorer;public void checkTaskStatus() {List<TaskExecution> taskExecutions = taskExplorer.findTaskExecutionsByTaskName("myTask");for (TaskExecution execution : taskExecutions) {System.out.println("任务ID:" + execution.getExecutionId());System.out.println("任务状态:" + execution.getExitCode());System.out.println("开始时间:" + execution.getStartTime());System.out.println("结束时间:" + execution.getEndTime());}

}4. 任务分区(Task Partitioning)

对于大型任务,可以启用任务分区以提高执行效率 :

@SpringBootApplication

@EnableTask

@EnableTaskPartitioning

public class PartitionedTaskApplication {public static void main(String[] args) {SpringApplication.run(PartitionedTaskApplication.class, args);}@Beanpublic Partitioner partitioner() {return new Partitioner() {@Overridepublic Map<String, Partition> getPartitions() {Map<String, Partition> partitions = new HashMap<>();for (int i = 0; i < 10; i++) {Partition partition = new Partition();partition.set arguments(Collections.singletonMap("chunk", i));partitions.put("partition-" + i, partition);}return partitions;}};}@Beanpublic Step step() {return new StepBuilder("step").<Partition, Partition>chunk(1).reader(partition -> {// 根据分区参数读取数据return partition.getArguments().get("chunk");}).processor(item -> {// 处理数据return item;}).writer(items -> {// 写入结果}).build();}@Beanpublic Job job() {return new JobBuilder("myJob").start(step()).build();}}在application.properties中配置分区数量:

spring.cloud.task-partitioning.grid-size=105. Spring Cloud Data Flow集成

Spring Cloud Task可以与Spring Cloud Data Flow集成,实现更复杂的任务编排和管理:

首先,创建一个Maven项目,并添加Data Flow相关依赖:

<dependency><groupId>org.springframework.cloud</groupId><artifactId>spring-cloud-starter-data-flow任务</artifactId><version>2.9.0</version>

</dependency>定义任务应用:

@SpringBootApplication

@EnableTask

public class DataFlowTaskApplication {public static void main(String[] args) {SpringApplication.run(DataFlowTaskApplication.class, args);}@BeanpublicCommandLineRunner commandLineRunner() {return args -> {System.out.println("Data Flow任务执行开始...");// 任务逻辑System.out.println("Data Flow任务执行结束");};}}然后,将任务应用上传到Spring Cloud Data Flow Server,并定义任务流:

# 上传任务应用

spring cloud task create --name data-flow_task --definition "data-flow_task:1.0-SNAPSHOT"# 定义任务流

task launch data-flow_task八、实际应用示例

1. 数据同步任务

以下是一个数据同步任务的实现示例,使用Spring Cloud Task从数据库中读取数据并写入文件:

@SpringBootApplication

@EnableTask

public class DataSyncTaskApplication {public static void main(String[] args) {SpringApplication.run(DataSyncTaskApplication.class, args);}@BeanpublicCommandLineRunner commandLineRunner(JdbcTemplate模板) {return args -> {System.out.println("数据同步任务开始执行...");// 从数据库读取数据List<Map<String, Object>> results = template.queryForList("SELECT * FROM my_table");// 写入文件FileWriter writer = new FileWriter("output.txt");for (Map<String, Object> row : results) {writer.write(row.toString() + "\n");}writer.close();System.out.println("数据同步任务执行完成");};}}2. 定时清理任务

以下是一个定时清理任务的实现示例,使用Spring Cloud Task定期清理缓存数据:

@SpringBootApplication

@EnableTask

public class CacheCleanupTaskApplication {public static void main(String[] args) {SpringApplication.run(CacheCleanupTaskApplication.class, args);}@BeanpublicCommandLineRunner commandLineRunner(RedisTemplate<String, String> redisTemplate) {return args -> {System.out.println("缓存清理任务开始执行...");// 清理过期缓存redisTemplate.keys("*").forEach(key -> {if (redisTemplate.getExpire(key) <= 0) {redisTemplate.delete(key);}});System.out.println("缓存清理任务执行完成");};}}3. 分布式任务调度

以下是一个分布式任务调度的实现示例,使用Spring Cloud Task与Eureka集成,实现任务的分布式执行 :

@SpringBootApplication

@EnableTask

@EnableEurekaClient

public class DistributedTaskApplication {public static void main(String[] args) {SpringApplication.run(DistributedTaskApplication.class, args);}@BeanpublicCommandLineRunner commandLineRunner() {return args -> {System.out.println("分布式任务开始执行...");// 获取Eureka注册的服务列表List<InstanceInfo> instances = eurekaClient.getApplications().get instances();// 将任务分配到不同服务实例instances.forEach(instance -> {RestTemplate template = new RestTemplate();template.postForLocation("http://"+instance.get hostname port() +"/api/executeTask", null);});System.out.println("分布式任务执行完成");};}}九、最佳实践与注意事项

在使用Spring Cloud Task时,建议遵循以下最佳实践:

使用配置中心管理任务参数:将任务参数(如数据库连接信息、执行频率等)集中管理在Spring Cloud Config或Nacos中,便于动态更新和维护 。

启用任务分区处理大数据量任务:对于需要处理大量数据的任务,启用任务分区(@EnableTaskPartitioning)并合理设置grid-size,以提高执行效率 。

配置适当的JVM参数:在Dockerfile中设置合理的JVM参数(如内存限制、垃圾回收策略),避免任务执行过程中出现内存溢出等问题。

FROM openjdk:17-jre-slim

WORKDIR /app

COPY target/my-task.jar /app/my-task.jar

ENV JAVA_OPTS="-Xmx512m -Xms256m"

ENTRYPOINT ["java", "$JAVA_OPTS", "-jar", "/app/my-task.jar"]设置任务重试策略:在application.properties中配置任务重试策略,确保任务在失败时能够自动重试:

spring.cloud.task retry.max-attempts=3

spring.cloud.task retry(initial delay=1000

spring.cloud.task retry delay-multiplier=2.0集成监控工具:添加Spring Boot Actuator依赖,启用任务执行监控和健康检查 :

<dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-actuator</artifactId>

</dependency>避免任务重复执行:在分布式环境中,确保任务调度中心使用分布式锁(如Redis锁)获取任务,避免多个实例同时执行同一任务 。

合理选择数据库:在生产环境中,避免使用H2内存数据库,选择MySQL、PostgreSQL等持久化数据库,并根据需要配置spring.cloud.task.tablePrefix自定义表前缀。

结合Spring Cloud Data Flow:对于复杂的任务编排场景,考虑与Spring Cloud Data Flow集成,实现任务的统一管理和调度。

十、总结与展望

Spring Cloud Task通过轻量级设计和微服务原生支持,为分布式系统中的短生命周期任务管理提供了理想解决方案。它简化了任务开发、执行和管理流程,提供了完善的任务元数据持久化和状态跟踪机制,与Spring Cloud生态深度集成,适应了现代微服务架构的需求。

随着云原生和微服务技术的不断发展,Spring Cloud Task也在持续优化和演进。未来,我们可以期待它在以下方面取得更多进展:

更好的云平台支持:进一步优化与Kubernetes、AWS等云平台的集成,实现任务的自动扩缩容和调度优化。

更强大的任务编排能力:增强与Spring Cloud Data Flow的集成,提供更灵活的任务流定义和执行策略。

更完善的监控和告警机制:整合Prometheus、Grafana等监控工具,提供任务执行的可视化监控和异常告警。

更高效的资源管理:优化任务执行时的资源分配和回收机制,进一步降低资源占用。

更丰富的任务类型支持:扩展对不同类型任务(如流式任务、事件驱动任务等)的支持,满足更多业务场景的需求。

对于技术开发人员来说,Spring Cloud Task提供了一种简洁而强大的方式来构建和管理微服务中的短暂任务。通过合理配置和使用,可以显著提升系统的可扩展性、可靠性和资源利用率。在实际应用中,Spring Cloud Task尤其适合那些只需要执行一次或短时间运行的任务,数据迁移、缓存清理、日志归档等场景。通过与Spring Cloud Data Flow的集成,还可以实现更复杂的任务编排和管理,为微服务架构提供完整的任务调度解决方案。

参考资料:

- Spring Cloud Task 文档

本博客专注于分享开源技术、微服务架构、职场晋升以及个人生活随笔,这里有:

📌 技术决策深度文(从选型到落地的全链路分析)

💭 开发者成长思考(职业规划/团队管理/认知升级)

🎯 行业趋势观察(AI对开发的影响/云原生下一站)

关注我,每周日与你聊“技术内外的那些事”,让你的代码之外,更有“技术眼光”。

日更专刊:

🥇 《Thinking in Java》 🌀 java、spring、微服务的序列晋升之路!

🏆 《Technology and Architecture》 🌀 大数据相关技术原理与架构,帮你构建完整知识体系!关于博主:

🌟博主GitHub

🌞博主知识星球