Agent开发进阶路线:从基础响应到自主决策的架构演进

阿里云2025年AI Agent架构报告指出,AI应用正经历从被动工具向“智能伙伴” 的根本性转变,其核心在于实现思考-行动的闭环决策系统。

一、基础功能阶段:规则驱动的响应式Agent

1.Agent核心定义与基础能力

AI Agent的本质是“感知-决策-执行”循环系统,其核心特性包括:自主性(无需人工干预)、反应性(实时响应环境变化)、目标导向性(任务分解与规划)。基础阶段典型应用包括客服聊天机器人和自动化流程助手,依赖以下技术实现:

# 有限状态机(FSM)示例:客服对话流程控制

states = {"start": ["问候", "转人工"], "问候": ["问题分类", "结束"], "问题分类": {"退款": "转接退款流程", "投诉": "记录工单"}} current_state = "start"

while current_state != "结束": action = states[current_state] user_input = input(f"可选操作: {action}") current_state = action.get(user_input, "错误处理") 图1:基础Agent架构图

┌──────────────┐ ┌──────────────┐ ┌──────────────┐

│ 环境感知 │───> │ 规则引擎决策 │───> │ API执行 │

│ (关键词匹配) │<─── │ (状态机/决策树)│<─── │ (数据查询) │

└──────────────┘ └──────────────┘ └──────────────┘ 2.关键技术实现

环境感知:基于正则表达式或关键词模板的意图识别(如正则规则

r"退款|退货|换货"匹配售后请求)决策机制:有限状态机管理对话流程,决策树处理分支逻辑

工具调用:通过RESTful API集成外部服务(如订单查询接口)

二、功能增强阶段:多模态与复杂任务处理

1.机器学习驱动的认知升级

在现代智能系统中,当传统的基于规则的编程方法难以应对复杂的现实场景时,引入统计模型和机器学习算法就变得尤为重要。这种情况通常出现在以下几种典型场景中:

(1)自然语言处理领域:传统的基于语法规则的NLP系统在处理歧义语句、方言或新兴网络用语时表现欠佳。而基于统计语言模型和深度学习的方法,如BERT、GPT等模型,能够通过海量语料训练,捕捉语言的统计规律和上下文关系。

(2)计算机视觉任务:在图像识别、目标检测等任务中,手工设计的特征提取器往往难以应对光照变化、遮挡、视角变换等复杂情况。而卷积神经网络(CNN)等深度学习模型能够自动学习具有判别性的视觉特征。

当基础规则无法覆盖复杂场景时,需引入统计模型:

# 基于Rasa的意图识别模型配置(YAML片段)

pipeline:

- name: WhitespaceTokenizer

- name: RegexFeaturizer

- name: DIETClassifier # 双向Transformer实体提取 epochs: 100 关键突破:

上下文处理:通过对话状态跟踪(DST)维护多轮会话记忆

异常处理:置信度阈值机制(<0.7时触发人工接管)

多模态融合:文本+图像联合输入处理(如OCR识别图片中的订单号)

2.复杂任务分解与执行

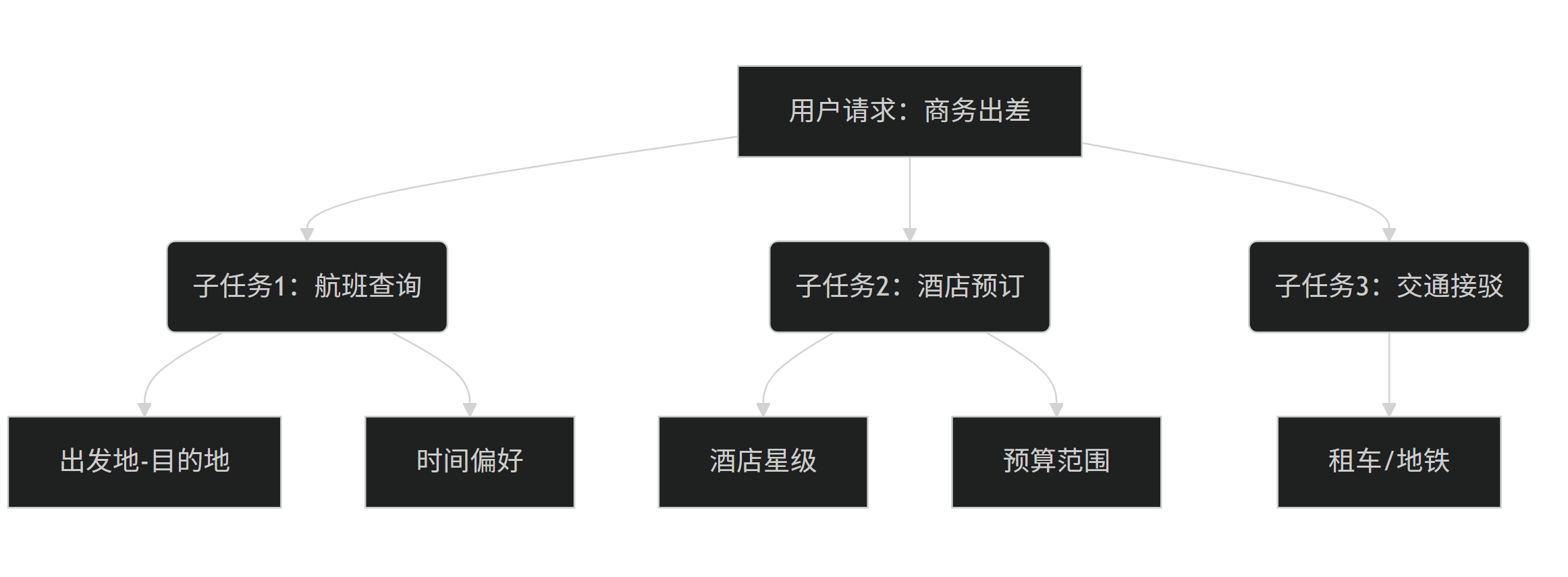

以旅行规划Agent为例,其任务分解逻辑需实现:

1.目标识别与需求分析

- 通过对话或问卷方式收集用户基本信息(预算、时间、同行人数等)

- 解析用户偏好(如喜欢自然风光还是城市观光)

- 识别特殊需求(如无障碍设施、饮食限制等)

- 示例:用户表示"想带父母去一个气候温和的海岛",则提取出"家庭出游"、"中老年人"、"海岛"、"温和气候"等关键需求

2.多维度任务分解

- 将总目标拆分为可独立执行的子任务: a) 目的地筛选(气候条件、飞行时长、签证政策) b) 行程编排(每日景点路线、交通衔接) c) 住宿选择(位置、房型、设施) d) 预算分配(交通、住宿、餐饮占比)

- 每个子任务可进一步细分,如"交通安排"包含航班查询、当地接送、景点间移动等

3.优先级排序与依赖关系处理

- 建立任务依赖图(如需先确定目的地才能订酒店)

- 区分关键路径任务(如签证办理时效性)和弹性任务

- 设置里程碑节点(如出票截止日前3天完成机票预订)

执行挑战:

工具动态选择:根据上下文调用航班API或酒店API

异常回退:当首选航班售罄时自动启用备选方案

跨模态对齐:确保语音指令与界面操作的一致性

三、自主决策阶段:强化学习与架构革新

1.强化学习驱动的自适应

1.1 状态空间(S)的详细组成:

- 用户意图:包括显式查询(如"帮我订机票")和隐式需求(如用户在查看天气预报后询问"需要带伞吗")

- 环境参数:当前时间、地理位置、设备类型、网络状态等上下文信息

- 历史动作:过去N步已执行的操作及其结果反馈(成功率、执行时长等)

- 会话历史:当前对话的上下文记录,用于理解多轮交互意图

1.2 动作空间(A)的具体实现:

- 工具调用:API调用(如天气查询API、支付接口)、数据库操作等

- 参数调整:动态调整查询范围(如时间窗口)、返回结果数量等

- 子任务触发:分解复杂任务为原子操作(订机票→查航班→比价→支付)

- 交互策略:确认询问、模糊推荐、主动建议等多种交互方式

1.3 奖励函数(R)的多维度设计:

- 主要指标:

- 任务完成率(主要目标达成比例)

- 用户满意度(显式评分+隐式行为分析)

- 耗时成本(端到端响应时间)

- 辅助指标:

- 资源消耗(API调用次数、计算资源占用)

- 风险控制(错误操作带来的负面影响)

- 探索奖励(尝试新策略的激励)

1.4PPO算法工程实现详解

基于Stable Baselines3的PPO实现代码扩展说明:

# 基于Stable Baselines3的PPO实现

from sb3_contrib import RecurrentPPO

model = RecurrentPPO( "MlpLstmPolicy", env, # 自定义Agent环境 gamma=0.99, # 未来奖励折扣 verbose=1

)

model.learn(total_timesteps=100000) 案例:阿里云MCP服务通过RL优化医疗账单决策,在成本与诊断准确性间取得平衡

2.分层控制架构设计

三层决策系统实现自主性

┌───────────────┐

│ 元认知层 │◀──自我反思与策略调整

│ (目标评估) │

└───────────────┘ ▲

┌───────────────┐

│ 规划层 │◀──任务分解与工具选择

│ (ReAct引擎) │

└───────────────┘ ▲

┌───────────────┐

│ 反应层 │◀──实时环境响应

│ (工具执行) │

└───────────────┘ 多Agent协作模式:

竞合机制:基于拍卖模型的资源分配(如物流Agent竞价运输任务)

角色分工:MetaGPT框架模拟软件团队(产品经理/工程师/测试员)

四、前沿探索:大模型赋能与挑战

1.LLM为核心的推理革命

ReAct范式成为主流架构(思考→行动→观察循环):

1. Thought: 需要查询今日日期

2. Act: 调用Search工具,输入“当前日期”

3. Observe: 获得“2025-08-17”

4. Thought: 需查询该日期历史事件

5. Act: 调用Search,输入“2025-08-17历史事件”

6. Observe: 获得事件列表

7. Act: 总结输出最终答案 里云双引擎架构中,LLM为“大脑”生成计划,Agent为“肢体”执行动作

工具增强新范式:

WebWatcher多模态Agent:整合网页浏览/图像搜索/OCR,在BrowseComp-VL基准超越GPT-4o 13.6%

ReaGAN图网络:节点自主决策,打破传统GNN局部性限制

2.关键挑战与破局思路

| 挑战 | 解决方向 | 案例 |

|---|---|---|

| 幻觉问题 | RAG+事实核查链 | 医疗Agent融合知识图谱 |

| 实时性瓶颈 | 模型蒸馏+边缘计算 | 海事PPO卸载策略降低延迟22.9% |

| 伦理风险 | 可解释性决策树+审计日志 | 金融Agent透明化账单决策 |

五、实践指南:从开发到部署

1.框架选型策略

| 框架 | 适用场景 | 优势 |

|---|---|---|

| LangChain | 企业级复杂应用 | 200+工具集成,生态完善 |

| AutoGen | 快速原型验证 | 人机协作简易 |

| MetaGPT | 多角色协作流程 | 模拟SOP驱动开发团队 |

配置示例(多Agent协作):

# AutoGen多Agent初始化

writer = ConversableAgent(name="作家", system_message="科技文章创作")

reviewer = ConversableAgent(name="评审", system_message="修改建议")

reviewer.initiate_chat(writer, message="撰写AI Agent技术文章") 2.持续迭代关键指标

任务成功率:核心路径完成度(如购物车下单率)

决策质量:奖励函数数值变化(PPO的episode reward)

人工接管率:<5%表明高自治性

响应延迟:边缘场景<500ms(如工业质检Agent)

技术拐点:微软Agent Lightning框架通过解耦执行与训练,允许开发者无需修改代码即可将现有Agent(如LangChain系统)接入强化学习环境,标志着Agent开发进入“自主进化”新阶段。