深入解析文本分类技术全景:从特征提取到深度学习架构

一、文本分类的核心流程

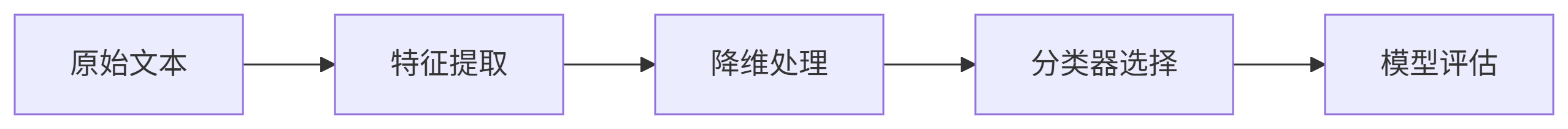

论文提出通用四阶段框架(见图1):

关键阶段解析:

-

特征提取

-

词袋模型:TF-IDF权重计算(公式:

W(d,t) = TF(d,t) * log(N/df(t))) -

词嵌入进阶:

-

Word2Vec:Skip-gram/CBOW架构(图2展示预测逻辑)

-

GloVe:全局共现矩阵优化(图3可视化词空间)

-

FastText:子词n-gram解决未登录词问题

-

上下文嵌入:ELMo动态词表示(双向LSTM捕获语境)

-

-

-

降维技术对比

方法 优势 文本场景局限 PCA 线性关系提取快 高维稀疏文本效果差 LDA 保留类别判别信息 需人工指定维度数 随机投影 计算效率高(Johnson-Lindenstrauss引理保证) 小数据集表现不稳定 自编码器 非线性特征学习 需要大量训练数据 -

分类算法演进路线

-

传统模型:Rocchio(质心距离)、朴素贝叶斯(多项式概率计算)

-

统计学习:SVM(核技巧处理高维)、最大熵模型(Logistic回归)

-

集成方法:AdaBoost(错误样本重加权)、随机森林(决策树投票)

-

深度学习:

-

CNN:局部特征捕获(图19展示文本卷积结构)

-

LSTM/GRU:序列建模(图17门控机制详解)

-

HAN:文档级分层注意力(图20双层级注意力机制)

-

-

二、五大关键突破点

-

特征工程革命

-

上下文嵌入解决多义词问题:如“apple”在水果/公司场景的差异化表示

-

FastText子词嵌入:对形态丰富语言(如土耳其语)效果显著

-

-

深度架构创新

-

RMDL随机多模型(图21):

并行训练DNN/CNN/RNN,通过投票集成降低方差 -

HDLTex层次分类:

适配医疗/法律文档的树状标签体系(图22)

-

-

评估指标陷阱

-

慎用准确率:文本数据普遍存在类别不平衡(如垃圾邮件检测)

-

推荐组合:Macro-F1(平等看待各类别) + AUC(综合排序能力)

-

-

领域应用前沿

-

医疗:Patient2Vec分析EHR电子病历

-

法律:CRF模型解析法律条文结构

-

社交网络:HAN处理长评论情感分析

-

三、工业实践建议

# 基于Scikit-learn的文本分类Pipeline示例

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.decomposition import TruncatedSVD

from sklearn.ensemble import RandomForestClassifierpipeline = Pipeline([('tfidf', TfidfVectorizer(max_features=10000)), ('svd', TruncatedSVD(n_components=300)), # 替代PCA处理稀疏矩阵('clf', RandomForestClassifier(n_estimators=100))

])调优策略:

-

小数据集优先:TF-IDF + SVM(线性核)

-

长文本处理:BERT微调 > GloVe + BiLSTM

-

实时系统:FastText(兼顾速度与OOV能力)

四、局限与挑战

-

词袋模型:忽略词序(“不错”vs“错误”表示相同)

-

深度学习:

-

黑盒问题:Attention机制可部分缓解

-

数据饥饿:少样本场景需结合迁移学习

-

-

领域适配:医疗文本需专业词典增强

论文源码:https://github.com/kk7nc/Text_Classification

延展阅读:2023年Transformer架构(如BERT)已在文本分类实现SOTA