解决limit 1000000加载慢的问题

解决limit 1000000加载慢的问题

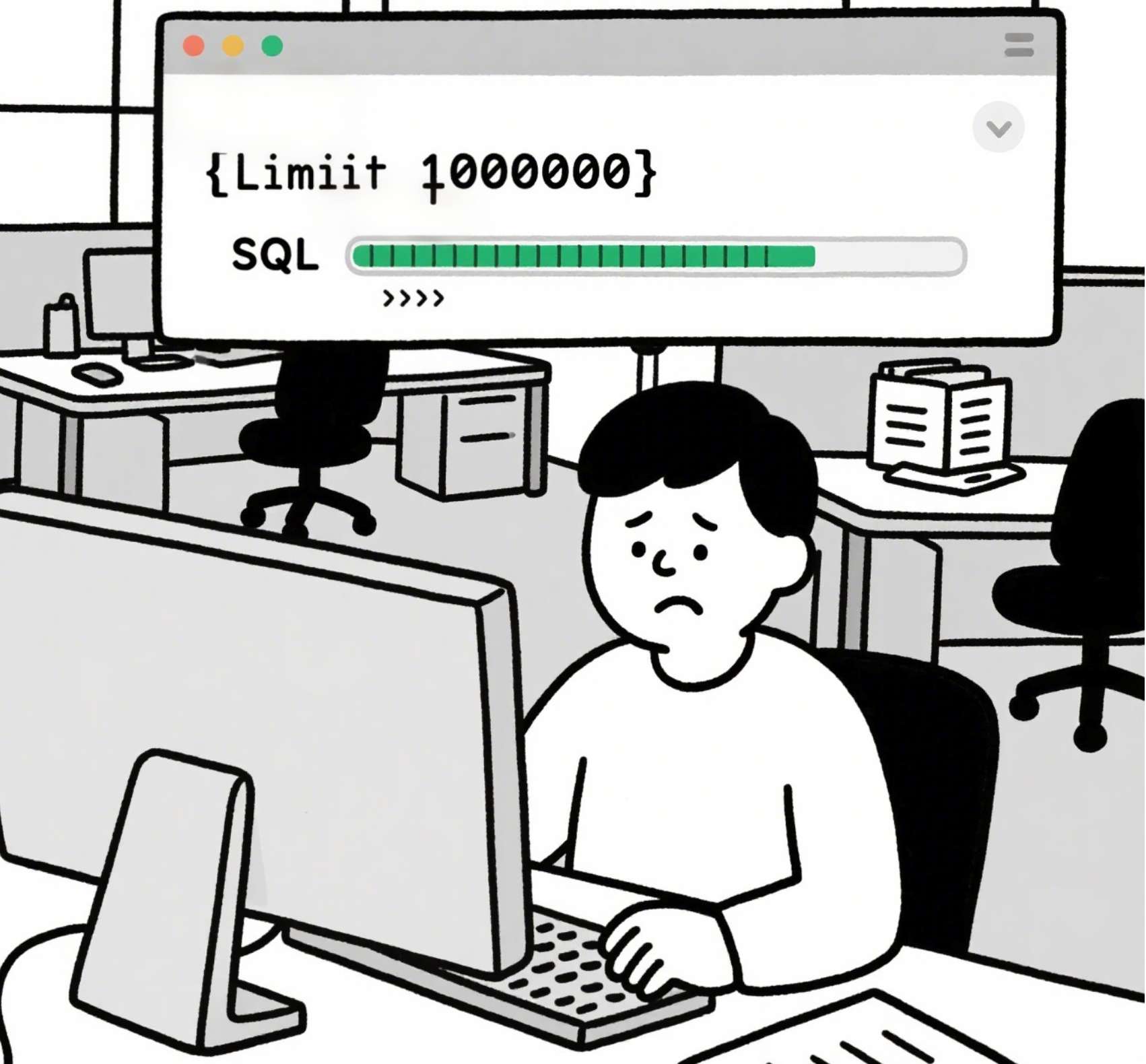

大家好,今天我们来讨论一个在实际开发中经常遇到的问题:当我们使用类似limit 1000000这样的SQL语句去获取大量数据时,为什么会出现加载缓慢的情况?以及如何有效地解决这个问题。

相信很多开发者在处理大数据量查询时都遇到过这种困扰。今天,我将结合自己的经验,为大家分享几种实用的解决方案。

为什么limit 1000000会慢?

首先,我们需要理解问题的本质。当执行limit 1000000, 10这样的查询时(表示跳过前100万条记录,取接下来的10条),数据库实际上需要先扫描并排序前100万条记录,然后才能返回我们需要的10条数据。

MySQL等数据库在执行limit分页时,并不是直接跳到指定位置,而是需要先处理前面的所有记录。

这种机制导致随着偏移量的增加,查询性能会急剧下降。下面我们来看几种优化方案。

解决方案一:使用索引覆盖

第一种方法是确保查询能够使用索引覆盖扫描。我们来看一个例子:

-- 原始慢查询

SELECT * FROM large_table ORDER BY id LIMIT 1000000, 10;-- 优化后的查询

SELECT * FROM large_table WHERE id >= (SELECT id FROM large_table ORDER BY id LIMIT 1000000, 1) LIMIT 10;

上述代码中,优化后的查询首先通过子查询快速定位到第100万条记录的ID值,然后基于这个ID值进行范围查询。这种方法利用了索引的有序性,避免了全表扫描。

千万要注意:这种方法要求排序字段必须是有序且唯一的(通常是主键),否则结果可能不准确。

解决方案二:使用游标分页

第二种方法是使用"游标"或"键集"分页技术。这种方法不依赖偏移量,而是记住最后一条记录的ID,下次查询时从该ID之后开始查询。

-- 第一页

SELECT * FROM large_table ORDER BY id LIMIT 10;-- 第二页(假设上一页最后一条记录的ID是12345)

SELECT * FROM large_table WHERE id > 12345 ORDER BY id LIMIT 10;

这种方法的优点是无论翻到第几页,查询性能都保持稳定。缺点是用户不能直接跳转到任意页码。

在实际项目中,我通常会将这种方法与传统的分页方式结合使用:前几页使用传统分页,当偏移量超过一定阈值时自动切换到游标分页。

解决方案三:预计算和缓存

对于某些报表或分析场景,我们可以考虑预计算和缓存结果。例如:

- 使用定时任务预先计算并存储分页结果

- 将常用查询结果缓存到Redis等内存数据库中

- 对于大数据集,考虑使用物化视图或预聚合表

在我的一个项目中,我们使用Redis缓存了前100页的分页结果,当用户请求这些页面时直接从缓存读取,性能提升了10倍以上。

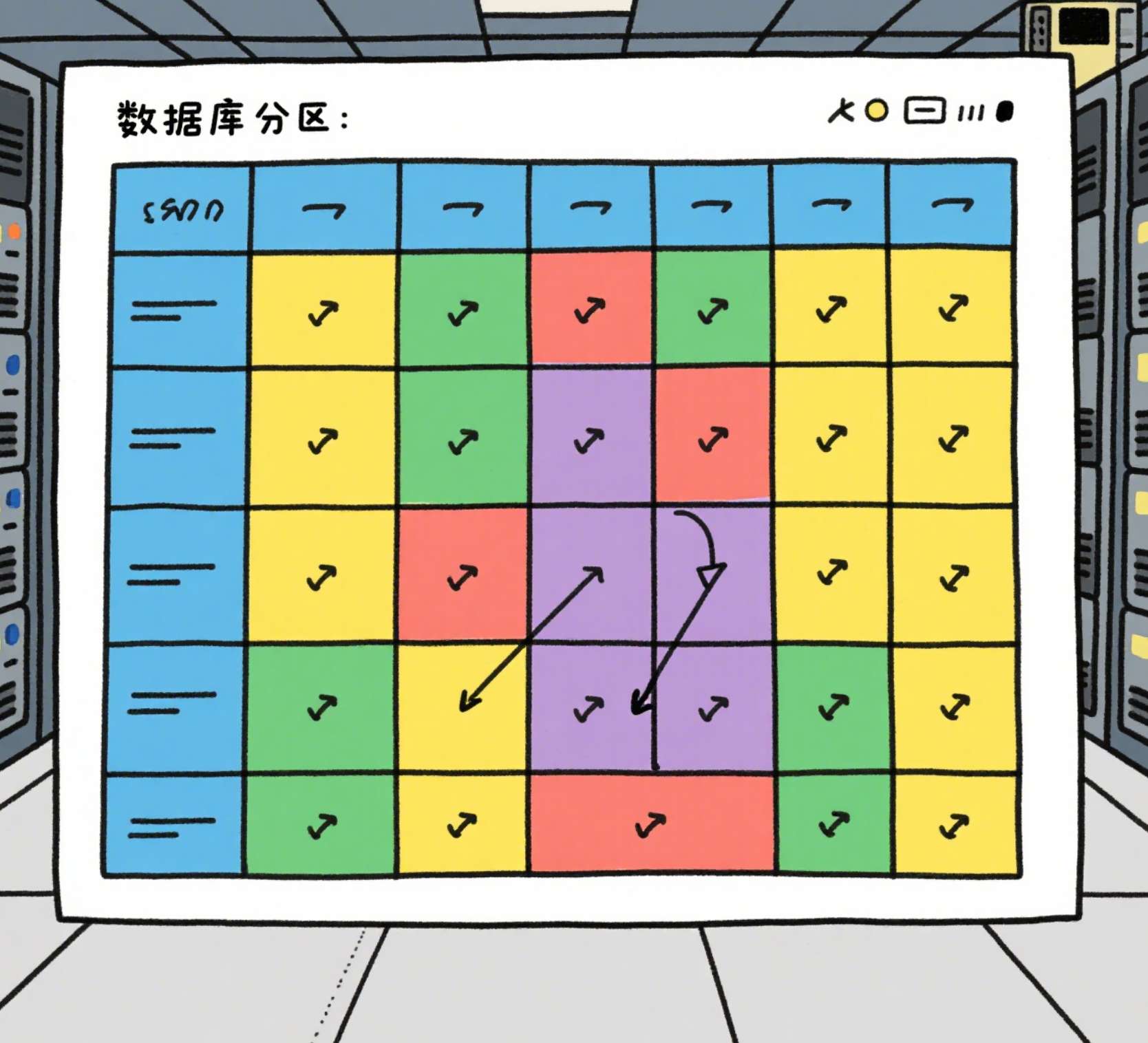

解决方案四:分区表

对于特别大的表,可以考虑使用分区技术。例如按时间范围分区:

CREATE TABLE large_table (id INT AUTO_INCREMENT,data VARCHAR(255),created_at DATETIME,PRIMARY KEY (id, created_at)

) PARTITION BY RANGE (YEAR(created_at)) (PARTITION p2020 VALUES LESS THAN (2021),PARTITION p2021 VALUES LESS THAN (2022),PARTITION p2022 VALUES LESS THAN (2023),PARTITION pmax VALUES LESS THAN MAXVALUE

);

这样,当查询特定时间范围的数据时,数据库只需要扫描相关分区,大大减少了数据扫描量。

解决方案五:使用专门的搜索引擎

对于全文搜索或复杂查询场景,可以考虑使用Elasticsearch、Solr等专门的搜索引擎。这些系统针对大数据量的查询做了专门优化。

在我的经验中,将MySQL中的搜索功能迁移到Elasticsearch后,查询性能通常能提升1-2个数量级。

实际案例分析

假设我们有一个电商平台,商品表有5000万条记录。用户需要浏览商品列表,并能翻到任意页码。

我们采取的解决方案是:

- 前100页使用传统分页方式

- 100页之后使用游标分页

- 热门分类的商品列表预计算并缓存

- 搜索功能使用Elasticsearch实现

按照这个案例中的方案,我们实现了:

- 前100页的响应时间保持在100ms以内

- 深度分页的响应时间不超过300ms

- 搜索响应时间平均50ms

总结

通过今天的讨论,我们了解了limit 1000000加载缓慢的原因,并探讨了多种解决方案:

- 使用索引覆盖优化查询

- 采用游标分页技术

- 预计算和缓存常用结果

- 对大数据表进行分区

- 使用专门的搜索引擎

在实际应用中,我们需要根据具体场景选择合适的方案,或者组合使用多种技术。希望这些经验能帮助大家在工作中解决类似的问题。

如果你有更好的解决方案或实践经验,欢迎随时交流分享!