GR00t 安装使用教程踩坑记录

1、简介

github: https://github.com/NVIDIA/Isaac-GR00T

最近入门使用GR00t,使用安装踩坑记录,显卡为5080系列最新GPU,安装github安装步骤使用,遇到无法安装flash-atten包,因为最新包还不支持50系类架构算力sm_120。

github安装步骤中也就差flash-atten没有安装了。

conda create -n gr00t python=3.10

conda activate gr00t

pip install --upgrade setuptools

pip install -e .

### pip install --no-build-isolation flash-attn==2.7.1.post4

2、解决办法

github中Issues找到问题解决办法:https://github.com/NVIDIA/Isaac-GR00T/issues/101

1)只能源码编译包了。安装了大概一个多小时。

GitHub flash-atten :GitHub - Dao-AILab/flash-attention: Fast and memory-efficient exact attention

#

pip install packaging ninja

github clone https://github.com/Dao-AILab/flash-attention.git

#

cd flash-attention

# conda activate env

python setup.py install ##MAX_JOBS=4/8/24,这个好像可以放在前面,限制限制线程数防止系统崩。暂时没设置。# 找不到cuda的话。

nvcc -V

which nvcc

export CUDA_HOME=/usr/local/cuda-12.8

# 或者bashrc中添加, 不是CUDA_HOME=$CUDA_HOME:/usr...

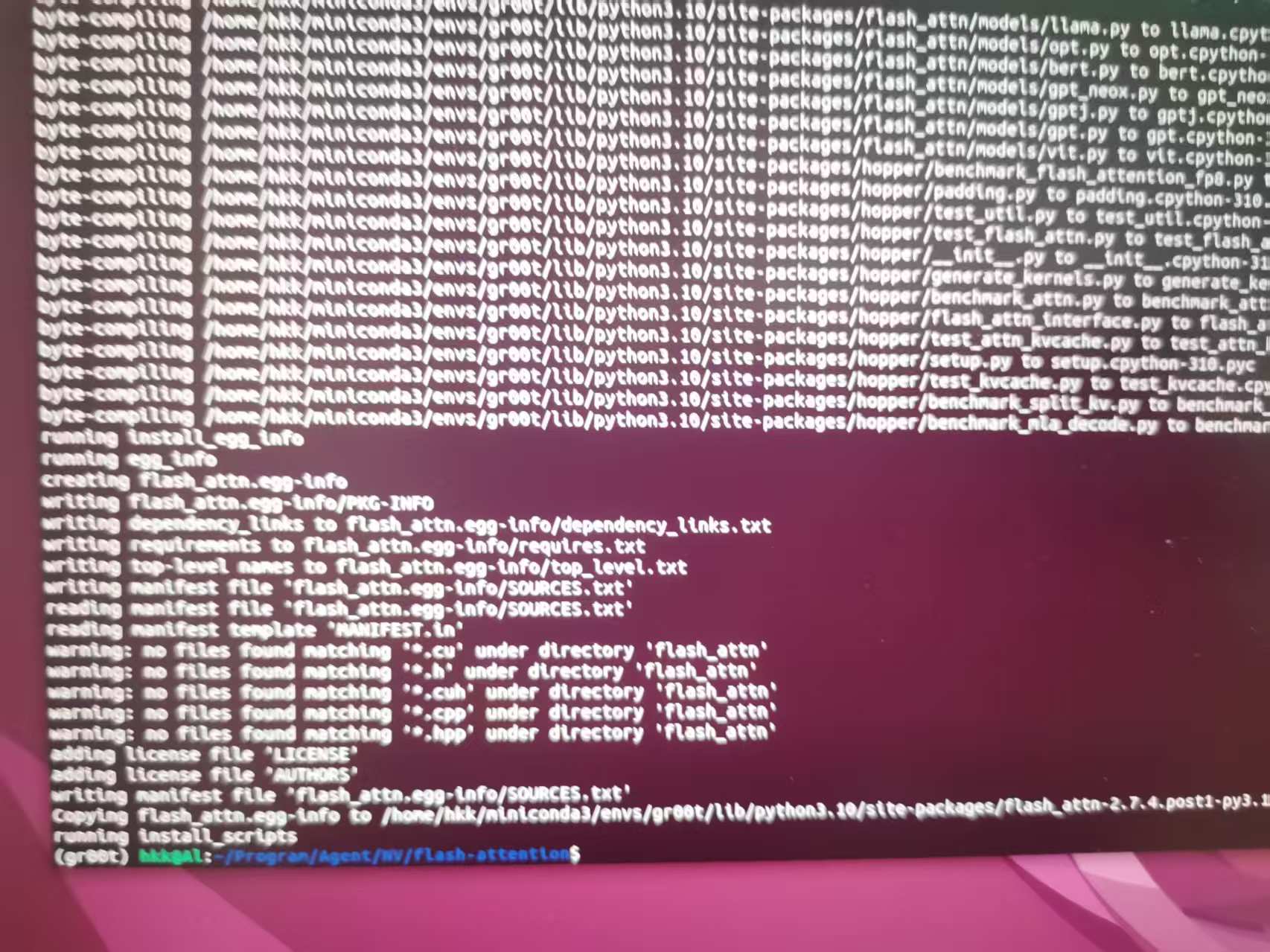

安装完成后的终端结果。

2)运行测试 。参考GitHub安装教程。测试这么久一直在运行,说明安装没有问题,可以Ctrl+C终端了。

export PYTHONPATH=$PWD

pytest -q -s tests/test_flash_attn.py

3)接口使用

import flash_attn_interface

flash_attn_interface.flash_attn_func()

flash-atten安装参考连接:flash-attention保姆级安装教程_flashattention安装-CSDN博客

3、参考连接

链接