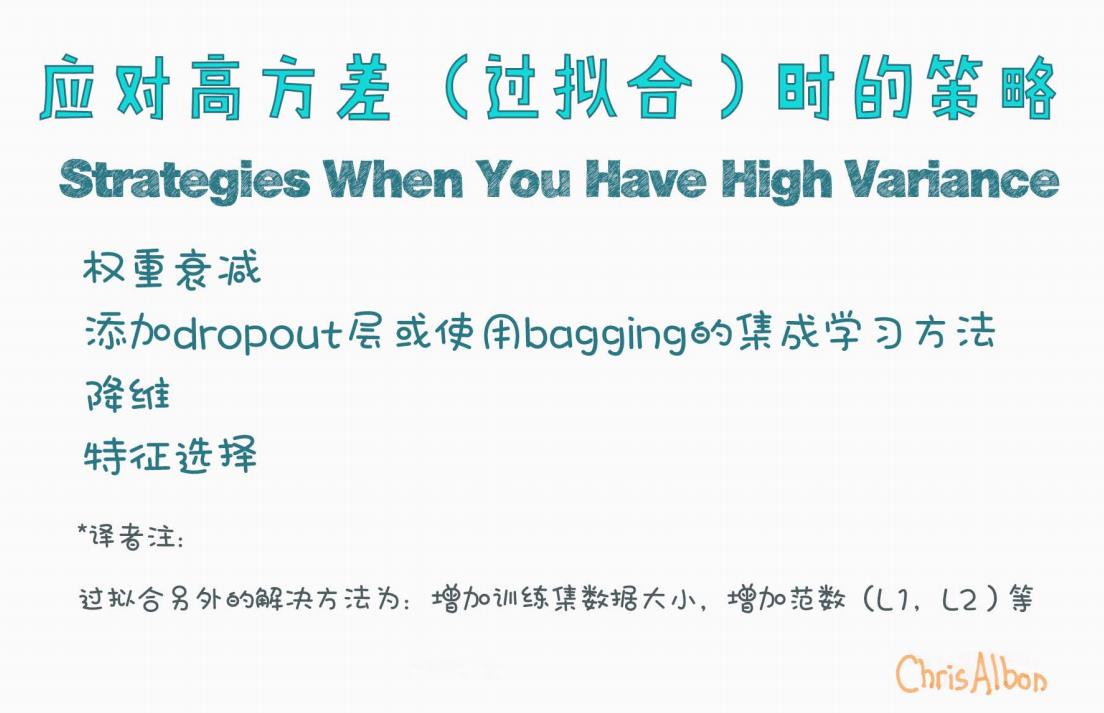

【漫话机器学习系列】216.应对高方差(过拟合)的策略详解(Strategies When You Have High Variance)

应对高方差(过拟合)的策略详解:机器学习中的常见方法

在机器学习的建模过程中,我们常常会面对一种令人头疼的问题——过拟合(Overfitting)。过拟合的本质是模型对训练数据“记得太多”,导致在新数据上表现不佳,也就是所谓的高方差问题(High Variance)。

那么,如何有效应对这一问题呢?本文将基于 Chris Albon 总结的思维导图,深入探讨几种常见且有效的技术手段。

一、什么是高方差(过拟合)?

在监督学习中,一个模型若在训练集上表现良好,却在验证集或测试集上表现较差,我们就称其为高方差模型。其特点包括:

-

训练误差小,测试误差大;

-

对训练集中的噪声过度学习;

-

泛化能力差,无法适应未见样本。

二、应对高方差的四大策略

Chris Albon 总结了四种在模型训练中应对过拟合的方法:

1. 权重衰减(Weight Decay)

核心思想:限制模型权重的大小,从而抑制其复杂度,防止过度拟合训练数据。

这通常通过引入正则化项实现:

-

L1 正则化(Lasso):使部分权重趋向于零,具有特征选择的效果。

-

L2 正则化(Ridge):平滑地减小所有权重,避免某些权重异常大。

常见实现方式:

# 以sklearn为例

from sklearn.linear_model import Ridge

model = Ridge(alpha=0.5)

在神经网络中,也常见如下方式:

# TensorFlow/Keras

Dense(units=64, kernel_regularizer=l2(0.01))

2. 添加 Dropout 层 或 使用 Bagging 的集成学习方法

Dropout(用于神经网络)

Dropout 是一种正则化技术,在每次前向传播时随机“丢弃”一部分神经元,防止网络对部分路径过度依赖。

from keras.layers import Dropout

model.add(Dropout(0.5)) # 50% 的神经元在训练时被暂时禁用

Bagging(Bootstrap Aggregating)

Bagging 是一种集成学习策略,通过训练多个基学习器并对它们的预测进行平均或投票来降低模型方差。

常见的 bagging 模型:

-

随机森林(Random Forest)

-

Bagged Decision Trees

from sklearn.ensemble import BaggingClassifier

model = BaggingClassifier(base_estimator=DecisionTreeClassifier(), n_estimators=10)

3. 降维(Dimensionality Reduction)

当特征维度过高时,模型很容易陷入“维度灾难”,导致过拟合。常用的降维方法包括:

-

主成分分析(PCA)

-

线性判别分析(LDA)

-

AutoEncoder(自编码器)

PCA 示例:

from sklearn.decomposition import PCA

pca = PCA(n_components=20)

X_new = pca.fit_transform(X)

4. 特征选择(Feature Selection)

并非所有特征都是有意义的。冗余或噪声特征会增加模型学习的难度。通过特征选择,我们可以保留对模型有用的信息,同时减少过拟合的风险。

常见方法:

-

方差阈值(Variance Threshold)

-

相关性过滤(Filter Methods)

-

嵌入式方法(如 L1 正则)

-

基于模型的重要性评分(如 XGBoost、RandomForest)

from sklearn.feature_selection import SelectKBest, f_classif

X_new = SelectKBest(f_classif, k=10).fit_transform(X, y)

三、其他应对过拟合的方法(译者补充)

除了上面列出的主要策略外,Chris Albon 在图中还补充了一些常见手段:

增加训练集数据大小

数据越多,模型就越不容易对特定样本过度拟合,从而提升泛化能力。

增加正则项(如 L1、L2)

正则化能够在损失函数中增加“惩罚项”,使模型趋向更简单、更稳健。

Loss = 原始损失 + λ × 正则项四、总结:选择适合的策略要结合模型与数据特点

| 方法 | 是否适用于深度学习 | 是否适用于传统模型 | 特点 |

|---|---|---|---|

| 权重衰减 | ✅ | ✅ | 控制模型复杂度 |

| Dropout | ✅ | ❌ | 神经网络专属,防止 co-adaptation |

| Bagging | ✅(部分模型) | ✅ | 集成多个模型减少方差 |

| 降维 | ✅ | ✅ | 简化模型输入,消除噪声 |

| 特征选择 | ✅ | ✅ | 仅保留有用特征 |

| 增加数据量 | ✅ | ✅ | 提高泛化能力,从根本缓解过拟合 |

参考资料

-

Chris Albon 的视觉笔记

-

《Deep Learning》—— Ian Goodfellow

-

Scikit-learn 官方文档

-

机器学习实战经验

如果你对某个具体策略有兴趣深入了解,欢迎留言或私信我,我们可以一起探讨更具体的应用和实现细节!