Midscenejs自然语言写测试用例

背景

以往的自动化测试工具大部分都需要使用有一定的技术背景,或多或少要会写个python,js之类的代码。本期介绍个通过自然语音交互形成自动化测试用例的工具midscenejs

midscenejs介绍

官方文档:https://midscenejs.com/zh/index.html

github:https://github.com/web-infra-dev/midscene

安装配置

步骤一:

到https://github.com/web-infra-dev/midscene/releases下载压缩包

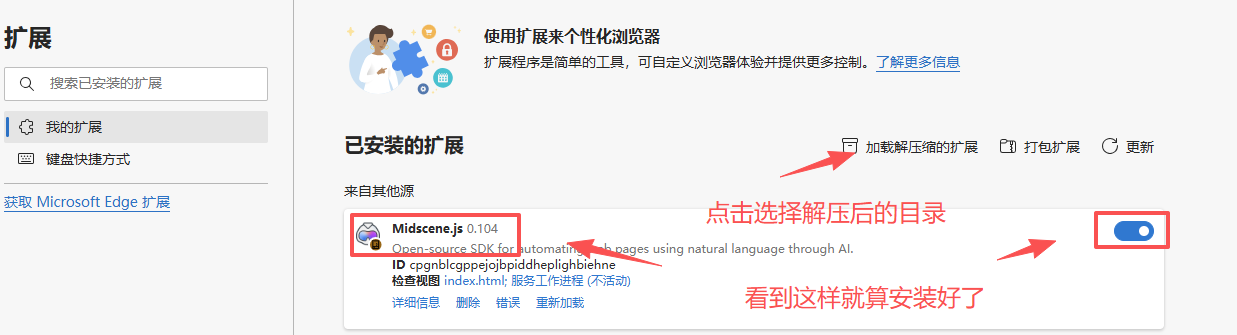

步骤二:

本地解压后,添加到chrome或edage浏览器的拓展里面

步骤三:

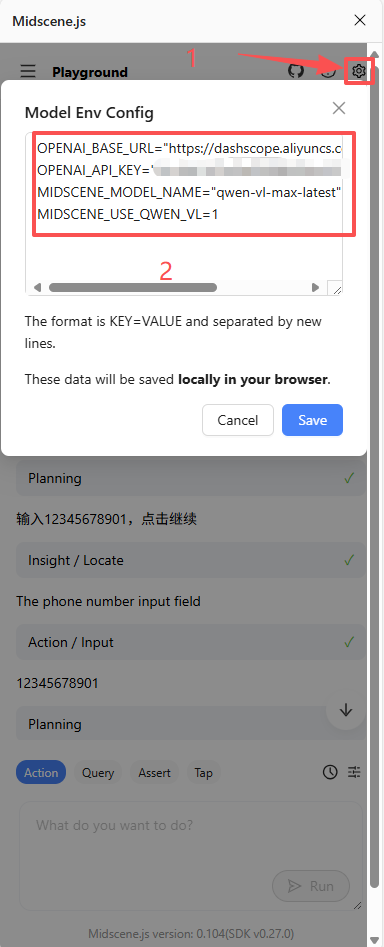

配置大模型,需要的多模态的,他用到图像识别等功能。

OPENAI_BASE_URL="https://dashscope.aliyuncs.com/compatible-mode/v1"

OPENAI_API_KEY="xxxx"

MIDSCENE_MODEL_NAME="qwen-vl-max-latest"

MIDSCENE_USE_QWEN_VL=1

到这里配置就结束了。

体验

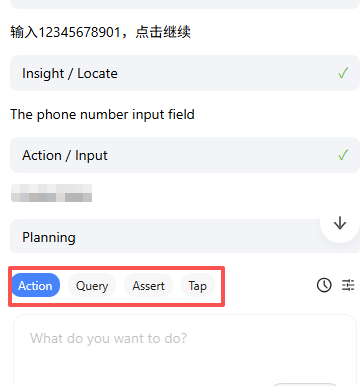

体验部分主要围绕工具下面4个按钮展开

Action

根据用户提示词自动规划如何完成某个操作步骤。

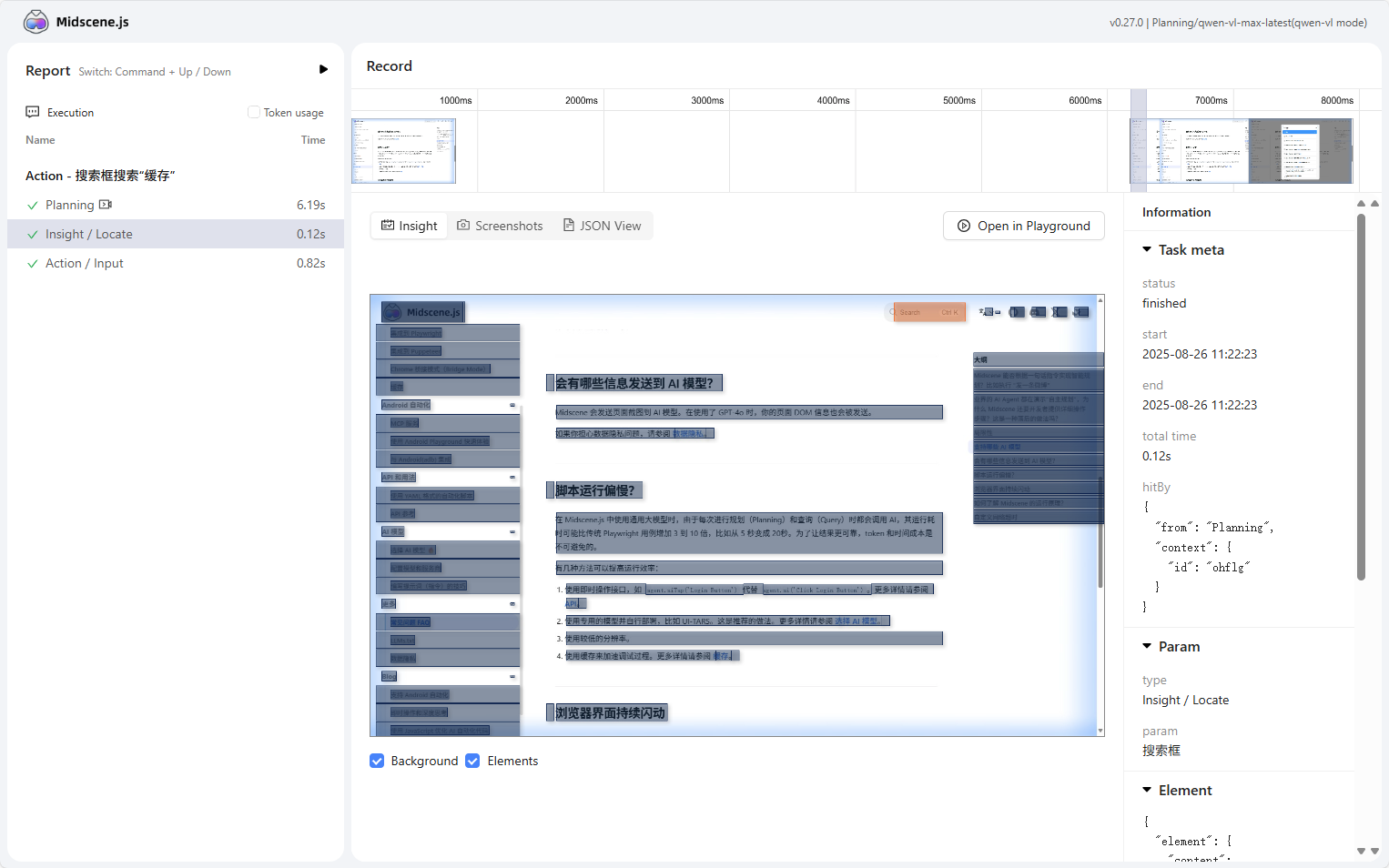

可以下载执行结果的报告,了解整个执行过程

Query

用于提取ui上的文字,转成结构化数据

Assert

断言,判断执行结果是否符合预期

Tap

触发界面点击,Action也可以完成,但Action会先规划,执行时间和效率要比这个低

结语

优点

midscene给我们提供了一个通过自然语言就可以跟浏览器和android交互的能力,相比以前自动化需要写代码门槛降低了很多。

另外一个优势,因为是自然语言交互,所以解决了部分以前自动化的维护难的痛点,就是界面有个小改动,自动化的代码就得重新调整,很多自动化做不起来跟这个有莫大关系。

缺点

1.由于是基于大模型的能力,所以执行效率也低很多,比较费token,官方也有为此提供一些解决方案,参考缓存篇章https://midscenejs.com/zh/caching.html

2.虽然可以通过自然语言交互,但指令还是需要比较清晰,不能非常笼统抽象,例如给他一个url,让他自动探索出买一杯咖啡,这种是做不到的。当然这个要求可能有点超纲了,但这种要求AI肯定也是能做到的。

往期文章

- 小智AI声波配网

- 小智AI完全自定义唤醒词

- 小智AI服务端部署实现播放自己的歌单

- 小智AI+MCP