大数据毕业设计选题推荐-基于大数据的北京气象站数据可视化分析系统-Hadoop-Spark-数据可视化-BigData

✨作者主页:IT毕设梦工厂✨

个人简介:曾从事计算机专业培训教学,擅长Java、Python、PHP、.NET、Node.js、GO、微信小程序、安卓Android等项目实战。接项目定制开发、代码讲解、答辩教学、文档编写、降重等。

☑文末获取源码☑

精彩专栏推荐⬇⬇⬇

Java项目

Python项目

安卓项目

微信小程序项目

文章目录

- 一、前言

- 二、开发环境

- 三、系统界面展示

- 四、部分代码设计

- 五、系统视频

- 结语

一、前言

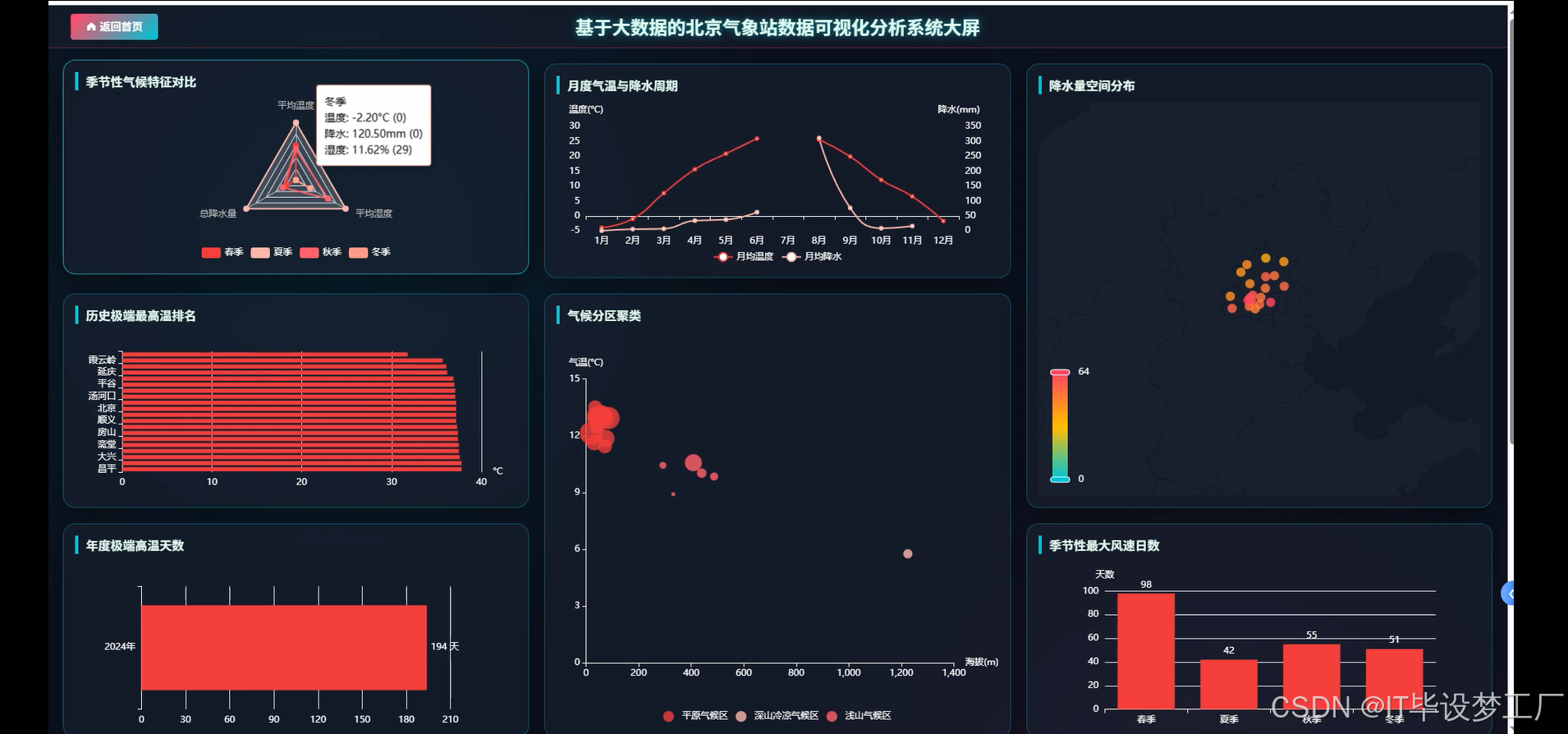

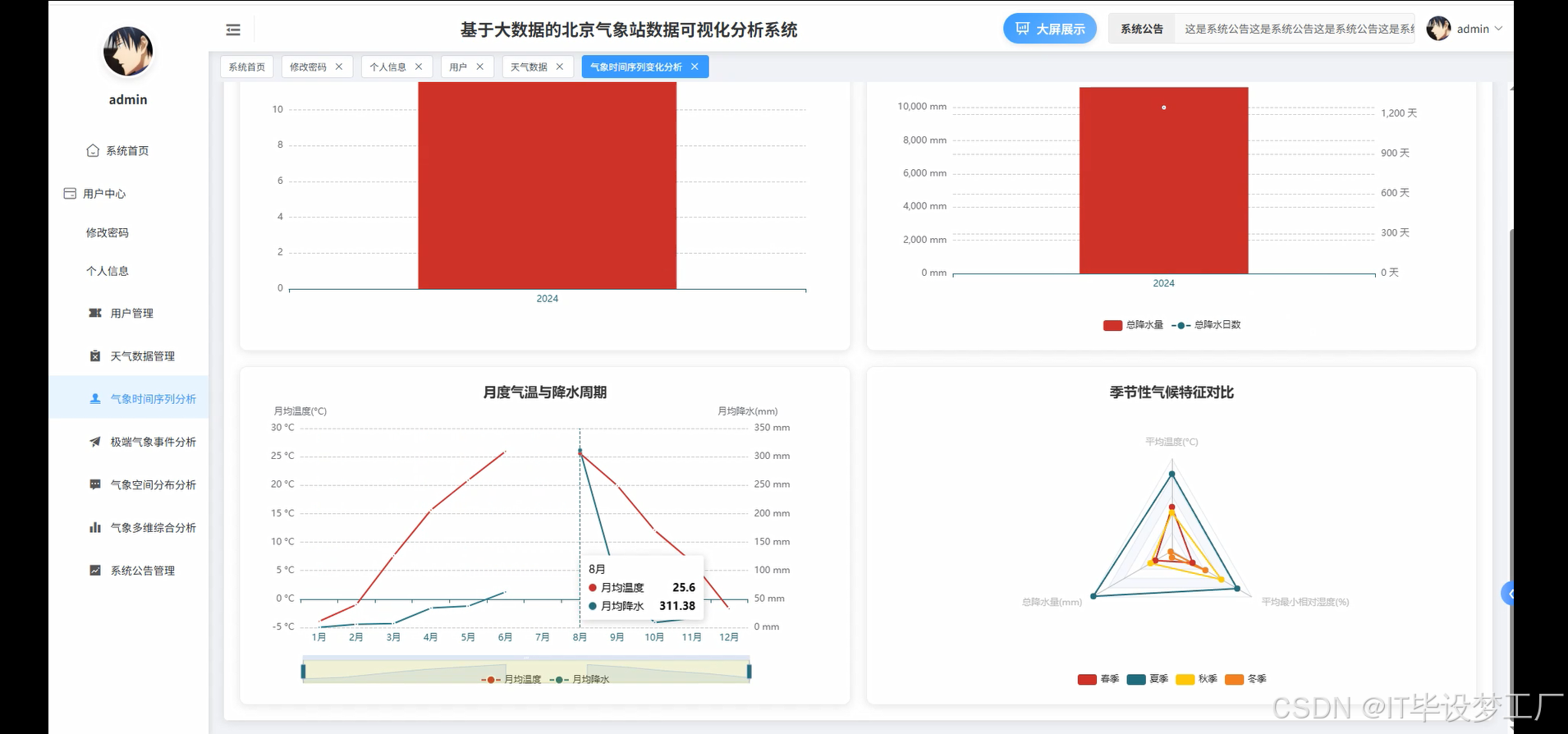

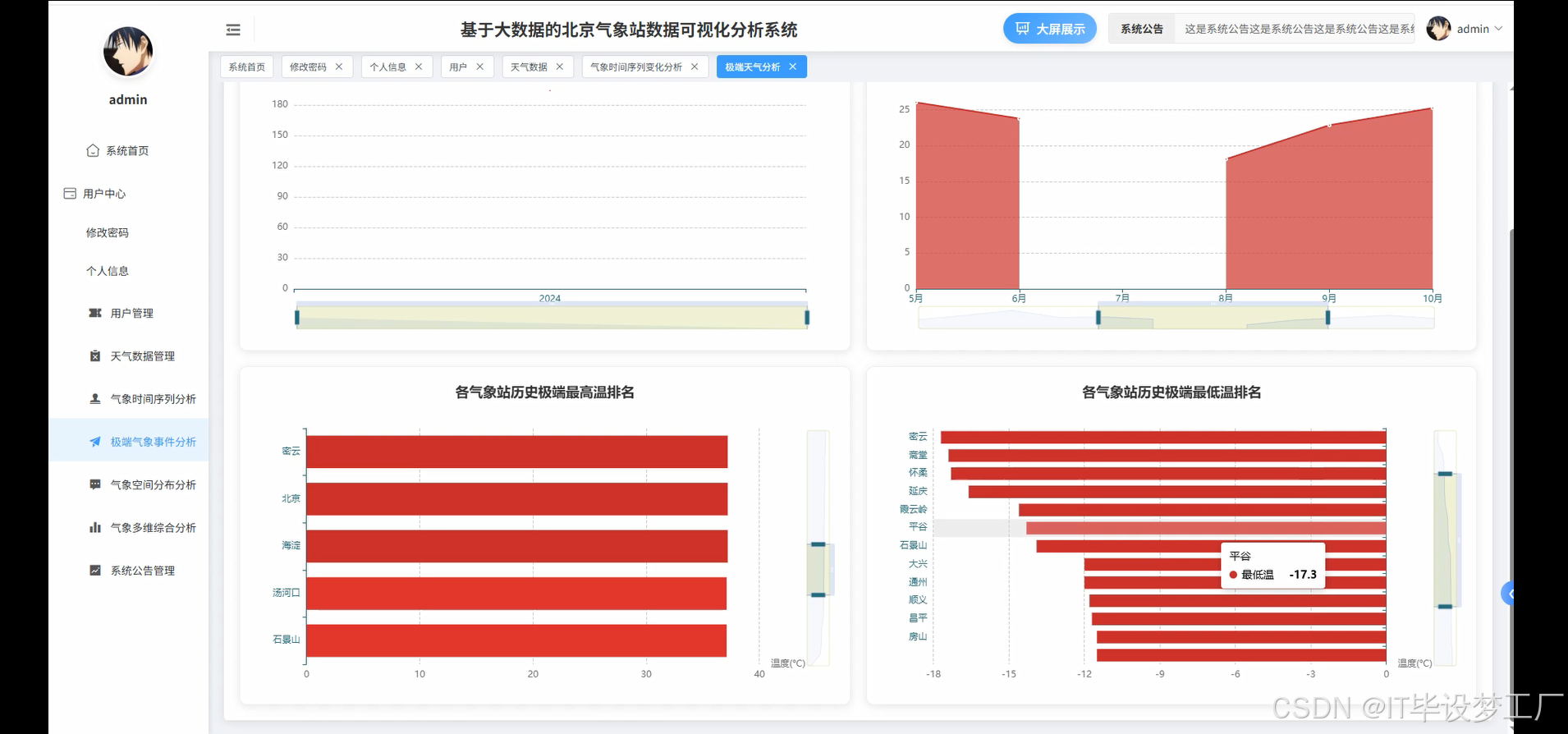

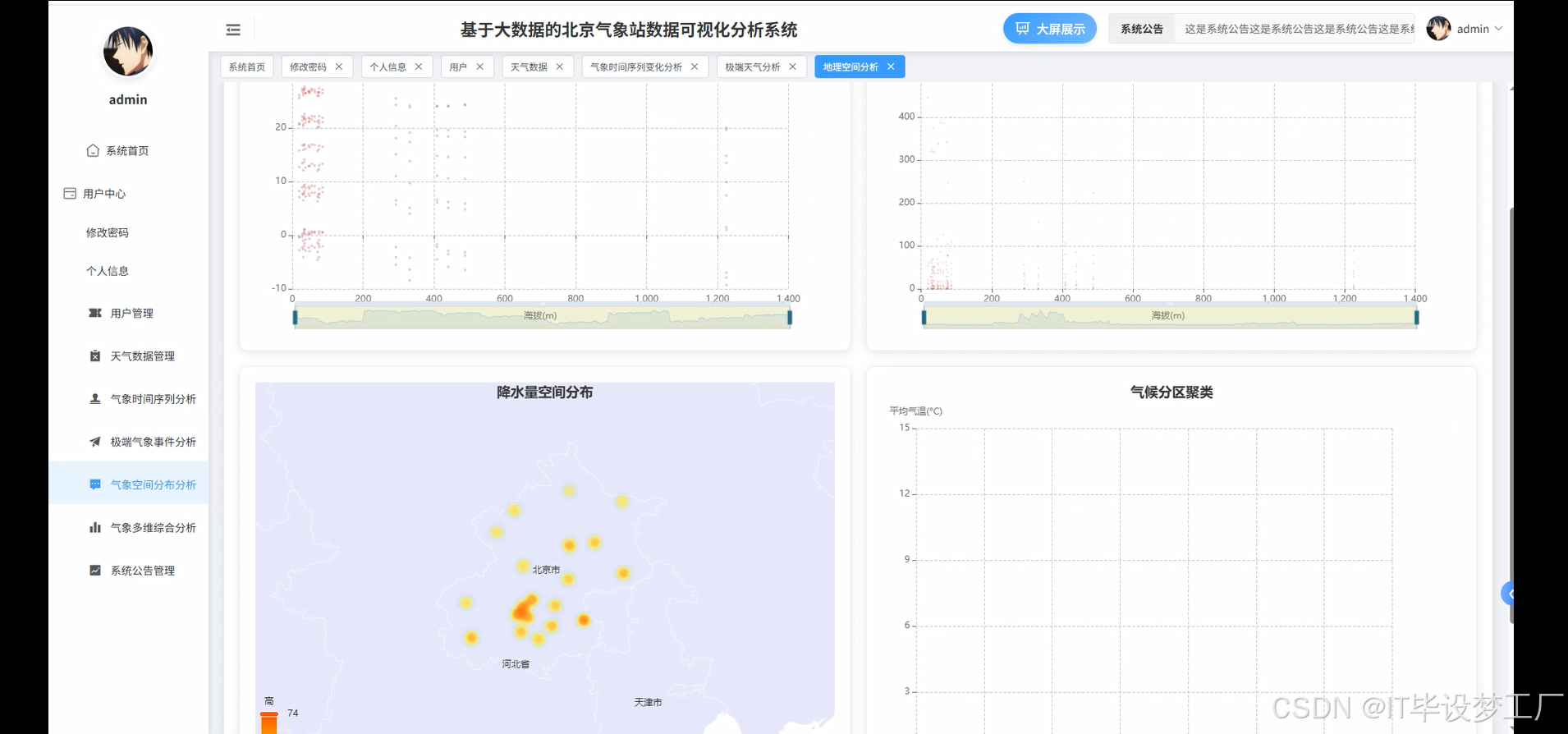

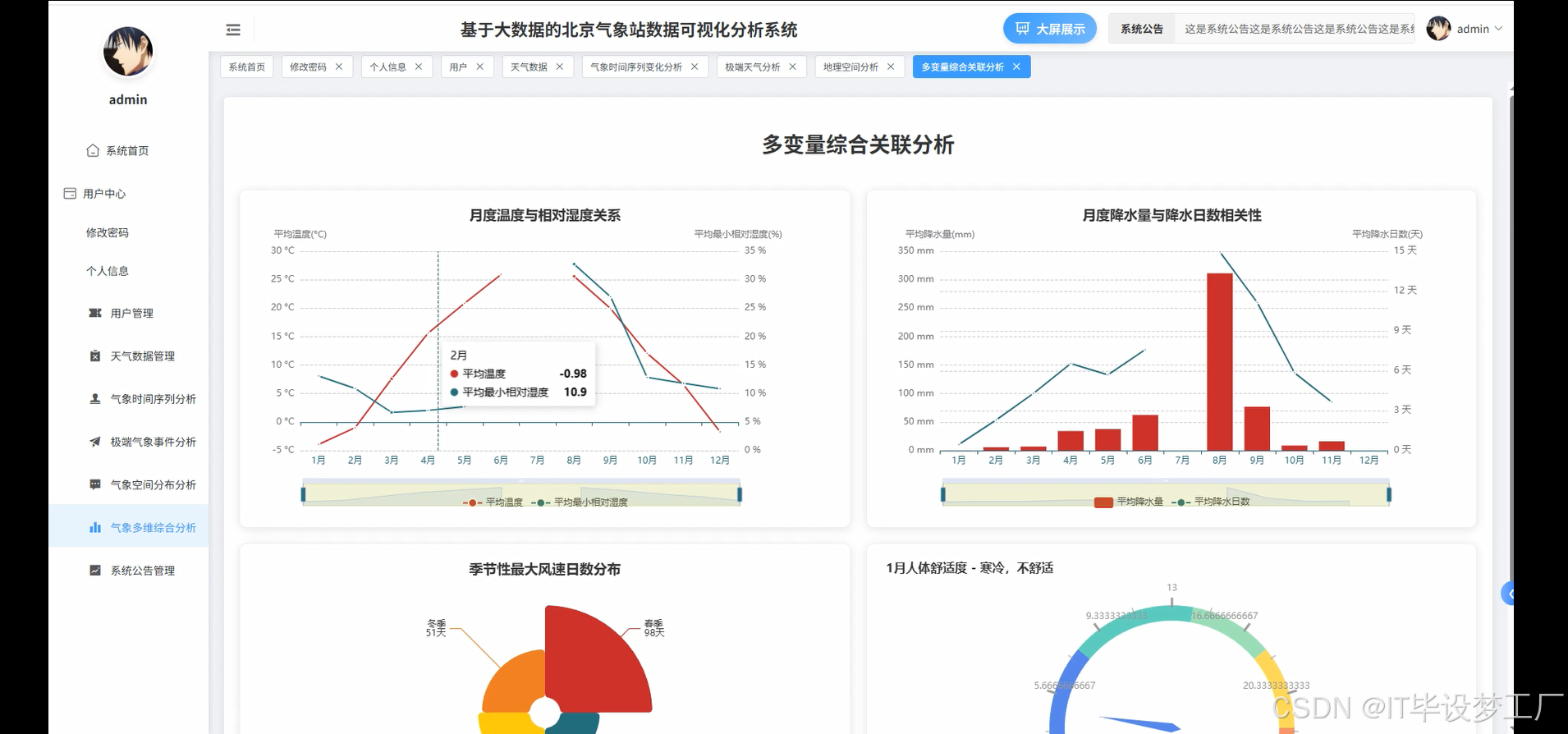

本系统是基于大数据技术的北京气象站数据可视化分析系统。系统通过集成Hadoop和Spark框架,结合Python和Java语言的双版本支持,基于Django和Spring Boot后端框架,提供强大的数据存储、处理与分析功能。前端使用Vue框架,结合ElementUI、Echarts、HTML、CSS等技术,提供丰富的交互界面和数据可视化展示。系统能够对北京地区气象数据进行详细分析,包括年度气温变化、降水量趋势、极端天气事件等,帮助用户深入了解气候模式和天气变化趋势,支持气象数据的时序分析、空间分析与多变量综合分析。借助Spark的分布式计算能力,系统实现了对海量气象数据的高效处理,为气象研究、农业规划、城市气候适应性研究等提供了数据支持。

选题背景:

气象数据的获取和分析在当今社会中具有重要的实际应用价值,尤其是随着全球气候变化的日益加剧,城市气候研究和预测变得越来越重要。北京作为中国的首都,具有复杂的地理和气候特征。气象数据不仅对城市规划、农业生产、交通出行等方面具有重要影响,而且能够为应对极端天气事件(如高温、暴雨、沙尘等)提供有力支持。因此,针对北京地区的气象数据进行科学分析和可视化处理,不仅可以提供更精确的气候趋势预测,还能为政府、科研机构和市民提供决策支持。然而,目前许多气象数据的处理和分析仍然依赖传统的数据分析工具,缺乏灵活性与高效性。为此,本课题通过引入大数据技术,提出构建基于Hadoop和Spark框架的气象数据可视化分析系统。

选题意义:

本课题具有较强的实际应用价值,能够帮助用户更加直观和高效地分析和理解气象数据。首先,系统通过集成大数据处理框架,能够处理海量气象数据,解决传统气象数据分析工具处理效率低、扩展性差的问题。其次,通过前端的可视化界面,用户可以便捷地查看并对比不同气象站的数据,直观感受气象变化趋势,获取包括年度温度变化、降水量趋势、季节性气候特点等各类分析结果。这对于城市气候适应性研究、农业生产及灾害预警等领域具有重要意义。此外,系统支持气象数据的历史对比和极端天气事件分析,为气象灾害的预测与防治提供数据支持。总体来说,本课题通过技术创新,提升了气象数据的处理与展示能力,帮助用户做出更加科学、合理的决策。

二、开发环境

- 大数据框架:Hadoop+Spark(本次没用Hive,支持定制)

- 开发语言:Python+Java(两个版本都支持)

- 后端框架:Django+Spring Boot(Spring+SpringMVC+Mybatis)(两个版本都支持)

- 前端:Vue+ElementUI+Echarts+HTML+CSS+JavaScript+jQuery

- 详细技术点:Hadoop、HDFS、Spark、Spark SQL、Pandas、NumPy

数据库:MySQL

三、系统界面展示

- 基于大数据的北京气象站数据可视化分析系统界面展示:

四、部分代码设计

- 项目实战-代码参考:

from pyspark.sql import SparkSession

import pandas as pd

from django.shortcuts import render

from .models import WeatherData

import numpy as np# 创建SparkSession

spark = SparkSession.builder \.appName("BeijingWeatherStation") \.config("spark.sql.warehouse.dir", "/user/hive/warehouse") \.enableHiveSupport() \.getOrCreate()def analyze_temperature_trend(request):# 从数据库获取气象数据weather_data = WeatherData.objects.all()df = pd.DataFrame(list(weather_data.values()))# 使用Spark处理数据spark_df = spark.createDataFrame(df)avg_temp_by_year = spark_df.groupBy("year").agg({"avg_temp": "avg"})avg_temp_by_year = avg_temp_by_year.orderBy("year")# 将结果转换为Pandas DataFrame以便渲染result = avg_temp_by_year.toPandas()return render(request, 'temperature_trend.html', {'result': result})def analyze_precipitation_trend(request):# 从数据库获取降水数据weather_data = WeatherData.objects.all()df = pd.DataFrame(list(weather_data.values()))# 使用Spark处理降水数据spark_df = spark.createDataFrame(df)annual_precipitation = spark_df.groupBy("year").agg({"precipitation": "sum"})annual_precipitation = annual_precipitation.orderBy("year")# 将结果转换为Pandas DataFrame以便渲染result = annual_precipitation.toPandas()return render(request, 'precipitation_trend.html', {'result': result})def extreme_weather_analysis(request):# 从数据库获取极端天气数据weather_data = WeatherData.objects.all()df = pd.DataFrame(list(weather_data.values()))# 使用Spark处理极端高温事件数据spark_df = spark.createDataFrame(df)extreme_heat_days = spark_df.filter(spark_df["max_temp"] >= 35)extreme_heat_days_count = extreme_heat_days.groupBy("year").agg({"max_temp": "count"})extreme_heat_days_count = extreme_heat_days_count.orderBy("year")# 将结果转换为Pandas DataFrame以便渲染result = extreme_heat_days_count.toPandas()return render(request, 'extreme_weather.html', {'result': result})def seasonal_climate_comparison(request):# 从数据库获取季节性气候数据weather_data = WeatherData.objects.all()df = pd.DataFrame(list(weather_data.values()))# 使用Spark处理季节性气候数据spark_df = spark.createDataFrame(df)seasonal_data = spark_df.groupBy("season").agg({"avg_temp": "avg", "precipitation": "sum", "min_relative_humidity": "avg"})seasonal_data = seasonal_data.orderBy("season")# 将结果转换为Pandas DataFrame以便渲染result = seasonal_data.toPandas()return render(request, 'seasonal_comparison.html', {'result': result})五、系统视频

- 基于大数据的北京气象站数据可视化分析系统-项目视频:

大数据毕业设计选题推荐-基于大数据的北京气象站数据可视化分析系统-Hadoop-Spark-数据可视化-BigData

结语

大数据毕业设计选题推荐-基于大数据的北京气象站数据可视化分析系统-Hadoop-Spark-数据可视化-BigData

大家可以帮忙点赞、收藏、关注、评论啦~

源码获取:⬇⬇⬇

精彩专栏推荐⬇⬇⬇

Java项目

Python项目

安卓项目

微信小程序项目